- pub

Flux.1-dev LoRAのファインチューニング: 教訓とベストプラクティス

はじめに: Flux.1-dev LoRAのファインチューニングの課題

Flux.1-dev LoRAのファインチューニングは、ちょっと複雑で大変かもね。いろんなユーザーが自分の体験や知見をシェアしてくれてるから、うまく進めるためのヒントがいっぱいだよ。大事なポイントは、正しい設定を学ぶこと、ハードウェアの制約を考慮すること、そして質を落とさずに理想的な感じを出すことだね。

1. 画像は少なめからスタート

問題

多すぎる画像を使うと、ファインチューニングが複雑になることがあるんだ。

例

「私のベストモデルは20枚のトレーニング画像なんだけど、40枚よりもずっとプロンプトが楽だよ。」

解決策

少ない画像から始めて、より良くてコントロールしやすいモデルを作ろう。だいたい20枚がいい感じみたい。

2. 最適なイテレーションと学習率

問題

デフォルトのイテレーション数や学習率じゃ、理想的な結果が出ないことがあるんだ。モデルがトークンを無視するっていうことも。

例

「デフォルトの1,000イテレーションは少なすぎた。2,000ステップが私にはジャストだった。」

解決策

イテレーションの回数や学習率を微調整しよう。普通は、2,000ステップと0.0004の学習率がいいって言われてるよ。

3. ハードウェアの考慮

問題

VRAMが少ないと、プロセスが遅くなったりパフォーマンスに影響が出たりするんだ。

例

「トレーニングと後の推論には32GBのRAMで大丈夫だよ。24GBのVRAMは、RAMが足りないとき以外はいらないかな。」

解決策

十分なRAMを確保しよう。VRAMが少ないシステムでもトレーニングは可能だけど、時間がかかるかもしれないね。

4. ファイルサイズと背景の管理

問題

未トリミングや不均一な画像は、トレーニングの効果を下げる可能性があるんだ。

例

「Flux LoRAのトレーニング画像はスクエアに切り抜く必要ある?私は切り抜かなかったけど、うまくいったよ。」

解決策

トリミングは必須じゃないけど、データセットの一貫性を保つと結果が良くなるよ。可能なら、一貫した背景と画像サイズを使おう。

5. 質の劣化への対処

問題

LoRAを使うと、質や解剖学的な正確さが落ちることがあるんだよね。

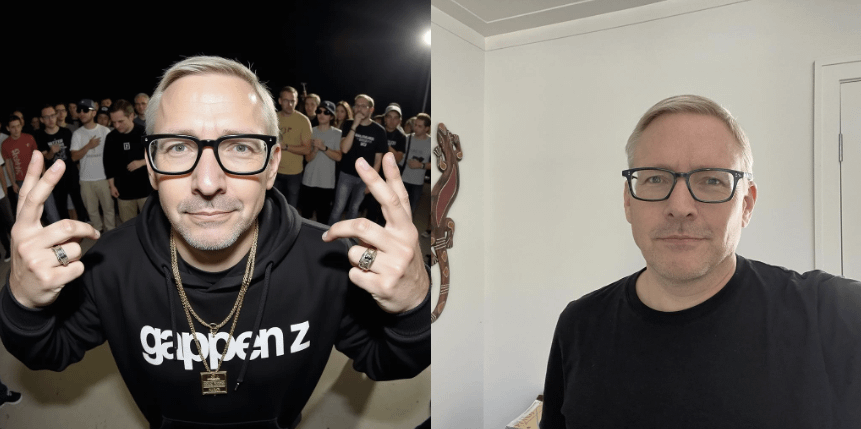

例

「これが言ってる解剖学的な劣化だよ。指や手がなんか崩れ始めるんだ。」

解決策

トレーニングのときはバッチサイズを大きめにして、質を向上させよう。あまりにも多くのイテレーションでファインチューニングしすぎないように、大事なのは画像が歪むのを避けること。

6. トレーニングと生成のヒント

問題

ローカルでトレーニングや画像生成するのは、時間がかかって難しいんだよね。

例

「セットアップには、この動画がすごく役に立ったよ: YouTubeチュートリアル」

解決策

Replicateみたいなクラウドサービスを使ったり、事前に用意されたテンプレートを使ってプロセスを簡素化しよう。ローカルでは、ai-toolkitみたいなツールが結構効果的だよ。

7. パラメータの実験

問題

デフォルト設定じゃ、ベストな結果が出ないこともあるし、フレームワークによってパラメータの扱いが違うんだ。

例

「私のLoRAはA40でたった300ステップで、これ以上の質はもう無理だよ。」

解決策

いろいろな設定やパラメータを試してみよう。複数の構成をテストして、自分に合ったやり方を見つけることが大事だね。

結論: ベストプラクティス

- 高品質な画像を少なめから始める。

- イテレーション数と学習率を慎重に調整する。

- ハードウェアが最低限の要件を満たしているか確認する。

- 一貫した画像と背景を使用する。

- 質の劣化サインに注意する。

- チュートリアルや既存のワークフローを利用する。

- いろんなフレームワークや設定を試してみる。

こうしたガイドラインを守れば、Flux.1-dev LoRAのファインチューニングで高品質で正確な結果が得られるよ。楽しんでプロンプトを使ってね!