- pub

Feinabstimmung von Flux.1-dev LoRA: Lektionen und Best Practices

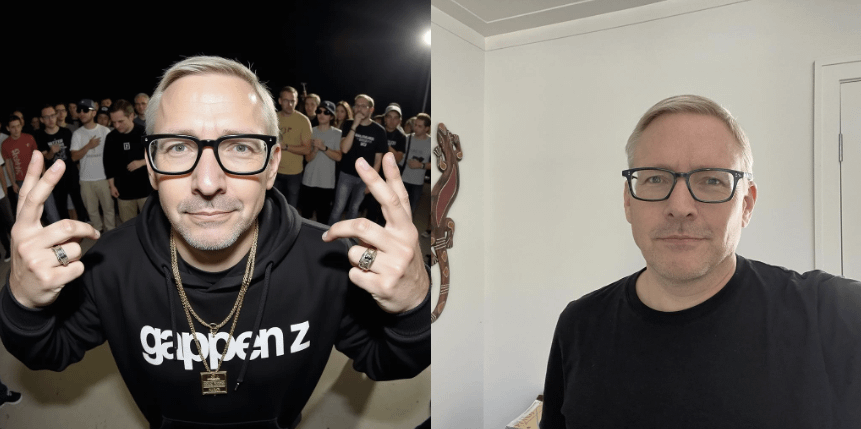

Einführung: Die Herausforderung beim Feintuning von Flux.1-dev LoRA

Das Feintuning von Flux.1-dev LoRA kann echt knifflig und manchmal ganz schön überwältigend sein. Viele Nutzer haben ihre Erfahrungen und Tipps geteilt, um anderen eine reibungslosere Bearbeitung zu ermöglichen. Wichtige Themen sind die richtigen Einstellungen zu lernen, mit Hardwarebeschränkungen umzugehen und das gewünschte Ergebnis zu erzielen, ohne die Qualität zu verschlechtern.

1. Mit weniger Bildern starten

Problem

Viele Nutzer haben festgestellt, dass zu viele Bilder beim Training den Feintuning-Prozess verkomplizieren können.

Beispiel

„Mein bestes Modell hat 20 Trainingsbilder, und es ist viel einfacher zu steuern als mit 40 Bildern.“

Lösung

Starte mit weniger Bildern, um ein besseres und kontrollierbareres Modell zu bekommen. Etwa 20 Bilder scheinen für viele optimal zu sein.

2. Optimale Iterationen und Lernrate

Problem

Die Standardanzahl der Iterationen und Lernraten bringen vielleicht nicht die besten Ergebnisse. Einige Nutzer erleben, dass ihre Modelle die Tokens ignorieren.

Beispiel

„Die Standardanzahl von 1.000 Iterationen war zu niedrig. 2.000 Schritte waren für mich der richtige Punkt.“

Lösung

Spiele mit der Anzahl der Iterationen und der Lernrate. In der Regel haben Nutzer herausgefunden, dass etwa 2.000 Schritte und eine Lernrate von 0,0004 gut funktionieren.

3. Hardware-Überlegungen

Problem

Begrenzter VRAM kann den Prozess verlangsamen und die Leistung beeinträchtigen.

Beispiel

„32 GB RAM sind für das Training und spätere Inferenzen in Ordnung. 24 GB VRAM sind nicht nötig, es sei denn, du hast wenig RAM.“

Lösung

Stelle sicher, dass du genug RAM hast. Bei Systemen mit geringem VRAM kann das Training zwar länger dauern, aber es ist immer noch machbar.

4. Datei-Größen und Hintergründe verwalten

Problem

Nicht zugeschnittene oder ungleichmäßige Bilder können die Effektivität des Trainings verringern.

Beispiel

„Muss das Bild für das Training von Flux LoRA quadratisch zugeschnitten werden? Ich habe es nicht gemacht, hat aber trotzdem gut funktioniert.“

Lösung

Zuschneiden ist zwar nicht zwingend notwendig, aber eine konsistente Datenbasis kann die Ergebnisse verbessern. Verwende nach Möglichkeit einheitliche Hintergründe und Bildgrößen.

5. Mit Qualitätsverlust umgehen

Problem

Einige Benutzer haben einen Qualitätsverlust und anatomische Ungenauigkeiten bei der Verwendung der LoRA bemerkt.

Beispiel

„Das ist es, was ich mit anatomischen Fehlern meine. Die Finger und Hände beginnen aus irgendeinem Grund zu brechen.“

Lösung

Verwende größere Batch-Größen beim Training, um die Qualität zu verbessern. Vermeide es, das Feintuning mit zu vielen Iterationen zu überladen, da das die Bilder verzerrt.

6. Tipps fürs Training und die Generierung

Problem

Das Training und die Generierung von Bildern lokal kann zeitaufwendig und herausfordernd sein.

Beispiel

„Für die Einrichtung war dieses Video sehr hilfreich: YouTube-Tutorial“

Lösung

Nutze Cloud-Dienste wie Replicate für aufwendigere Aufgaben oder vorgefertigte Vorlagen, um den Prozess zu vereinfachen. Lokal können Tools wie ai-toolkit sehr effektiv sein.

7. Mit Parametern experimentieren

Problem

Die Standardeinstellungen liefern nicht immer die besten Ergebnisse, und verschiedene Frameworks behandeln Parameter unterschiedlich.

Beispiel

„Meine LoRAs benötigten auf einer A40 nur 300 Schritte, und die Qualität kann nicht besser werden.“

Lösung

Experimentiere mit verschiedenen Einstellungen und Parametern. Finde heraus, was für deinen speziellen Anwendungsfall am besten funktioniert, indem du mehrere Konfigurationen testest.

Fazit: Beste Praktiken

- Starte mit weniger, aber hochwertigen Bildern.

- Passe die Iterationszahlen und Lernraten vorsichtig an.

- Stelle sicher, dass deine Hardware die Mindestanforderungen erfüllt.

- Nutze konsistente Bilder und Hintergründe.

- Achte auf Anzeichen von Qualitätsverlust.

- Nutze Tutorials und bereits bestehende Workflows.

- Experimentiere mit verschiedenen Frameworks und Einstellungen.

Wenn du diese Tipps befolgst, kannst du mit deinen Flux.1-dev LoRA Feintuning-Bemühungen hochwertige, präzise Ergebnisse erzielen. Viel Spaß beim Ausprobieren!