- pub

Flux.1 LoRA ve DoRA Eğitiminde Optimizasyonlu OneTrainer Ayarları ve İpuçları (20% Daha Hızlı)

Eğitim için Hazırlık

Model Seçimi

Öncelikle doğru Flux AI modelini seçtiğinden emin ol. OneTrainer, Flux.1 dev, pro ve schnell gibi çeşitli modelleri destekliyor. Projen için uygun olanı kullan.

- Modeli Edin: İstediğin modeli resmi kaynaklardan, mesela Hugging Face'den indir.

- Modeli Yükle: OneTrainer'da model ayarlarına git ve model dosyalarını yükle.

Ortamı Kurma

Donanım Gereksinimleri:

- GPU: En az 3060 öneriliyor. 4090 ile eğitim yaparsan daha iyi performans alırsın.

- VRAM: Yüksek çözünürlükler için en az 12 GB gerekir.

- RAM: En az 10 GB RAM önerilir, daha fazlası iyi olur.

Yazılım Gereksinimleri:

- İşletim Sistemi: Windows ve Linux üzerinde test edilmiştir.

- Bağımlılıklar: Tüm bağımlılıkların yüklü olduğundan emin ol. OneTrainer’ın belgelerinden gerekli kütüphanelerin ve araçların listesini kontrol et.

Detaylı Ayarlar ve Konfigürasyonlar

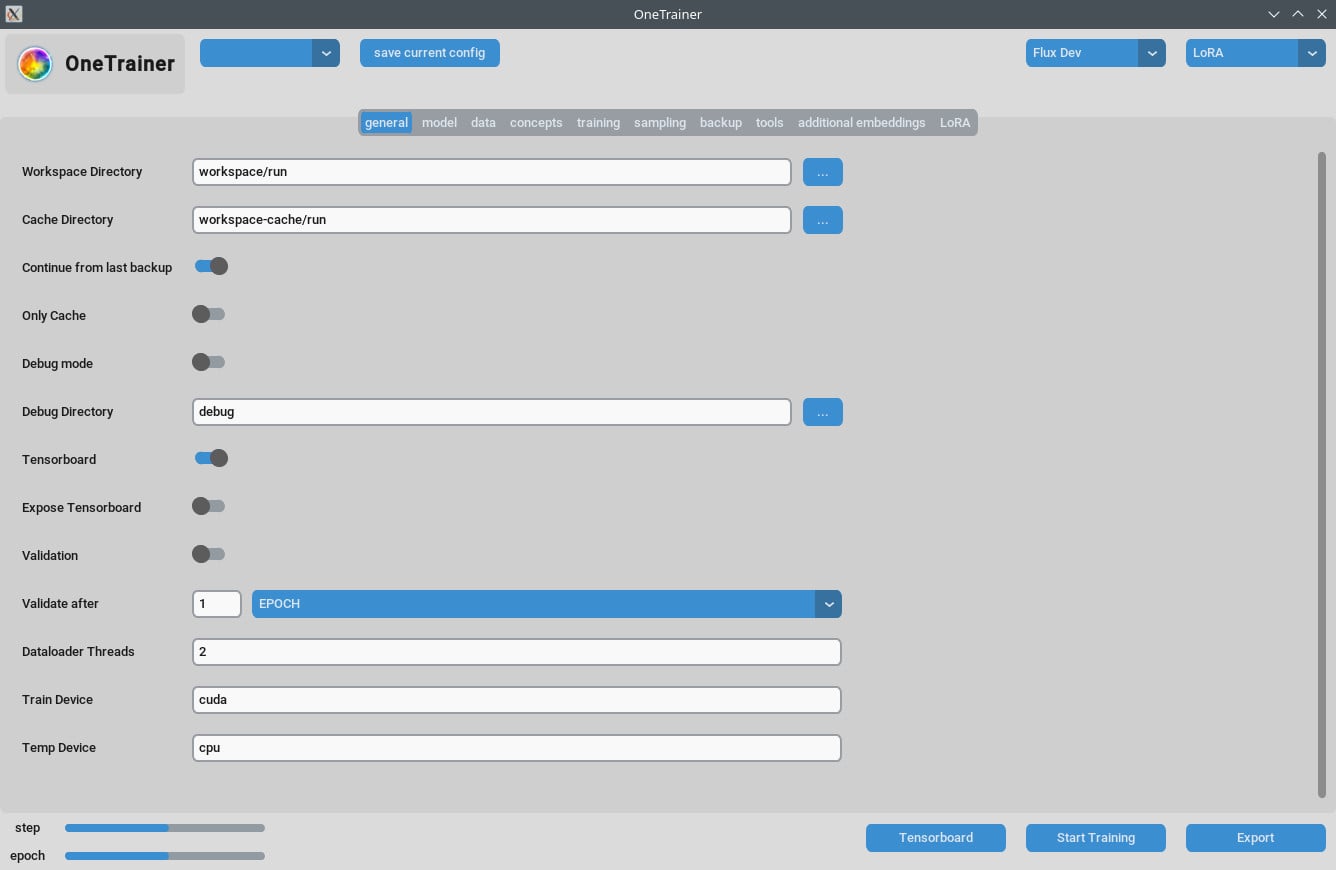

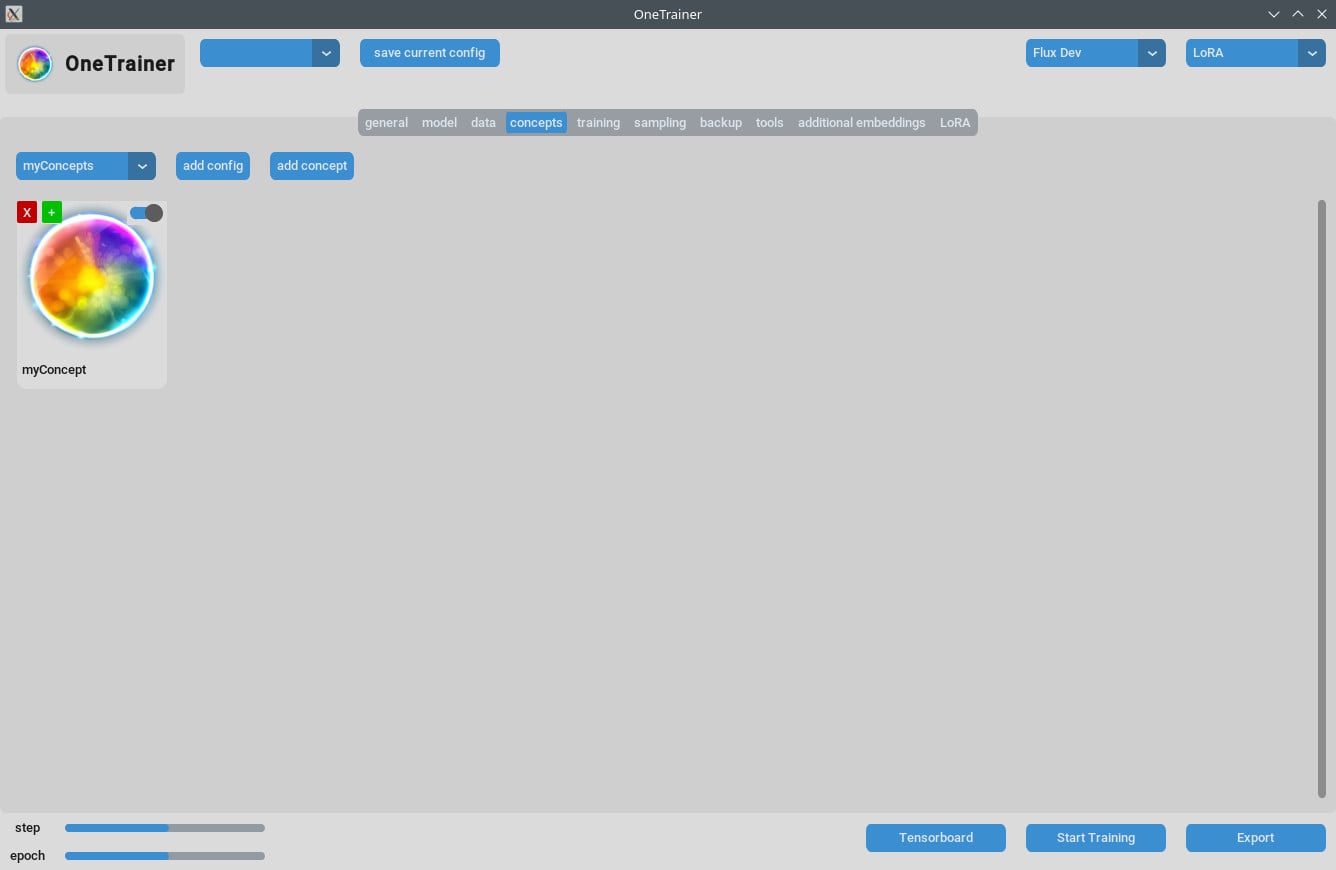

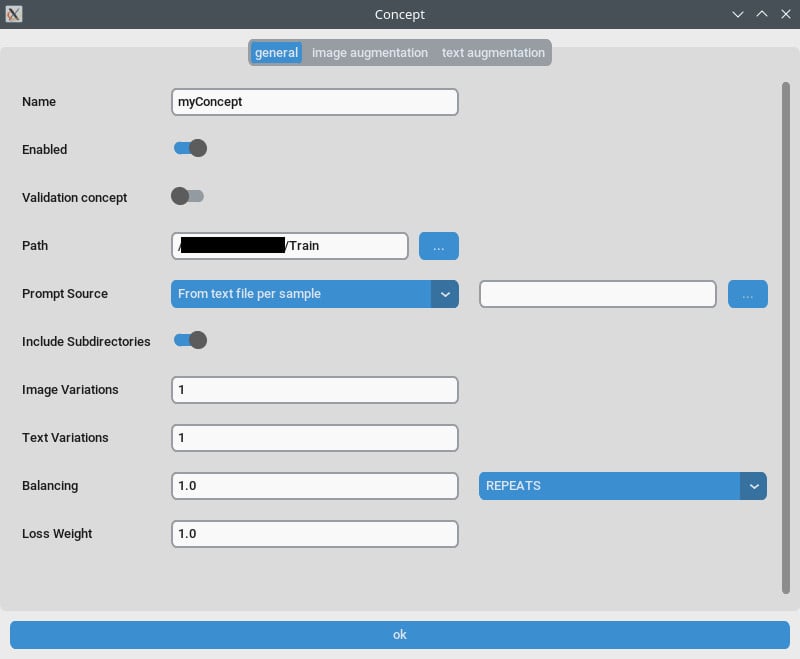

Konsept Sekmesi/Gene Ayarlar

- Tekrarlar:

Tekrarlarayarını 1 olarak ayarla. Yenilemelerin sayısını eğitim sekmesindekiEpoch Sayısıile ayarlayabilirsin. - Açıklama Kaynağı: Eğer her resim için ayrı başlık yerine bir "tetik kelime" istiyorsan, bunu "tek bir metin dosyasından" olarak kullan. Bu ayarı tetik kelimenin/ifadenin bulunduğu bir metin dosyasına yönlendir.

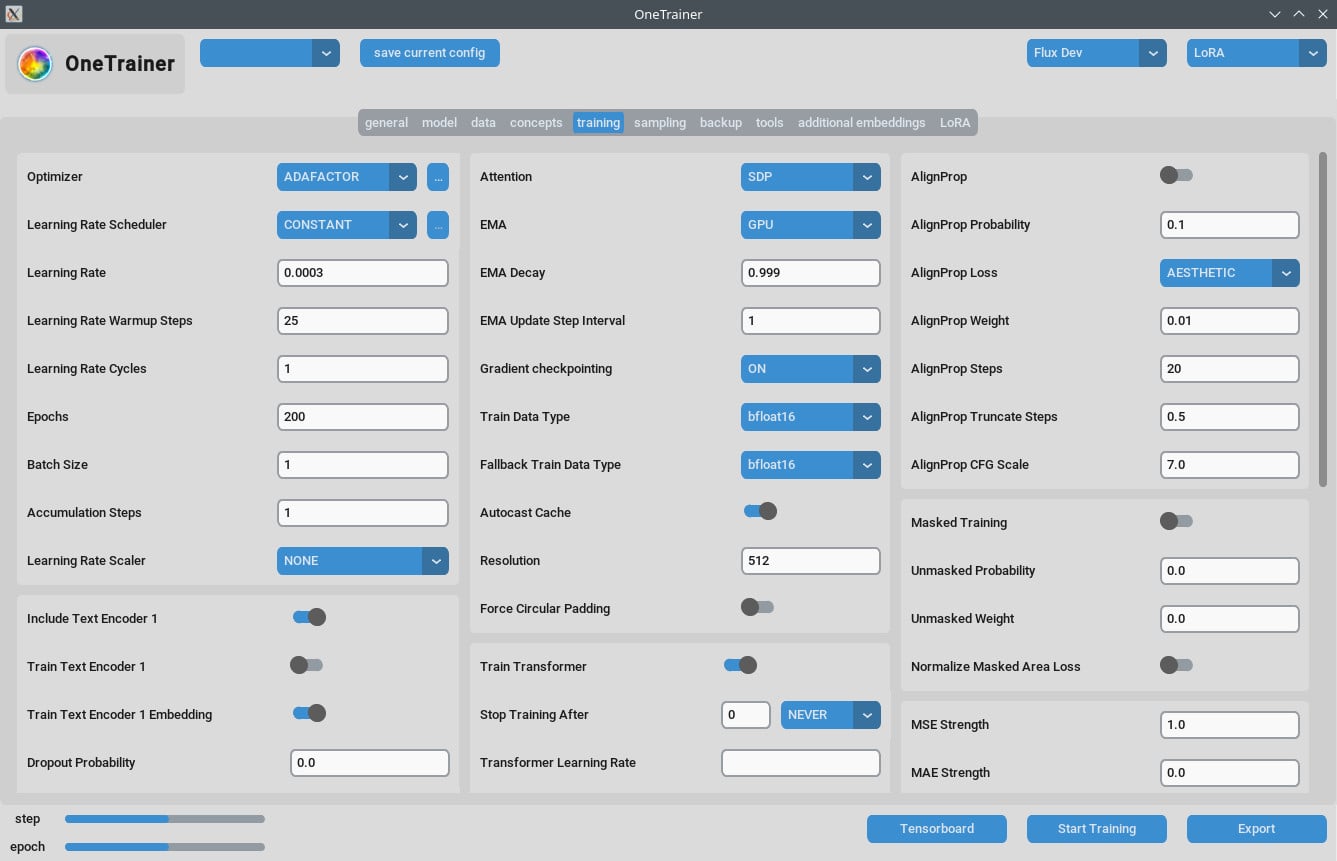

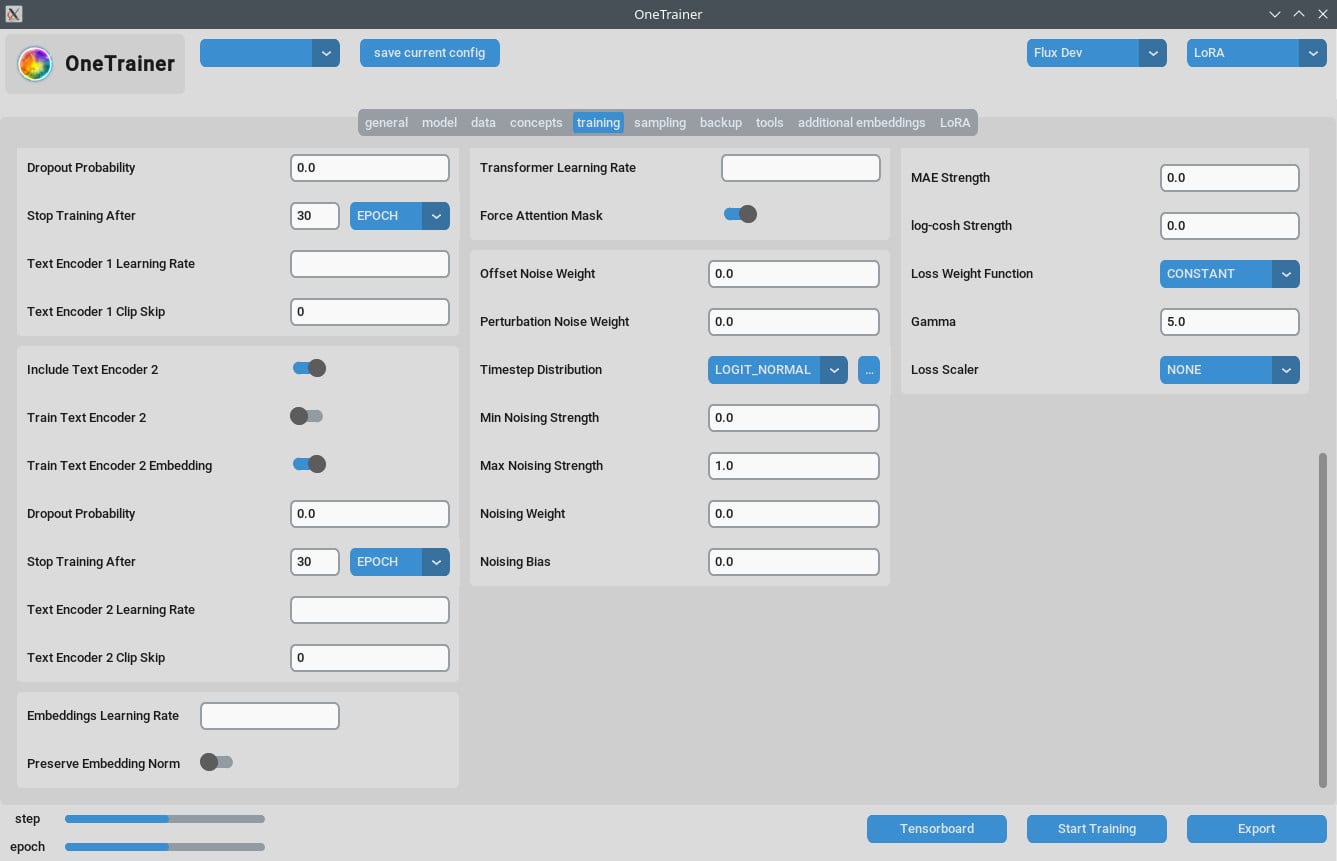

Eğitim Sekmesi

Çözünürlük Ayarları

- Daha İyi Kalite İçin:

Çözünürlükayarını 768 veya 1024 olarak ayarla, böylece daha kaliteli çıktılar alırsın.

- EMA Ayarları:

- EMA: SDXL eğitimleri sırasında kullan.

- EMA GPU: VRAM tasarrufu için EMA'yı "GPU" yerine "KAPALI" olarak ayarla.

- Öğrenme Hızı:

- Başlangıç noktası olarak 0.0003 veya 0.0004 iyi olabilir. İhtiyaçlarına göre ayarlarsın.

- Epoch Sayısı:

- Genellikle, 40 epoch iyi sonuçlar gösterir. Veri setinin karmaşıklığına göre ayarlayabilirsin.

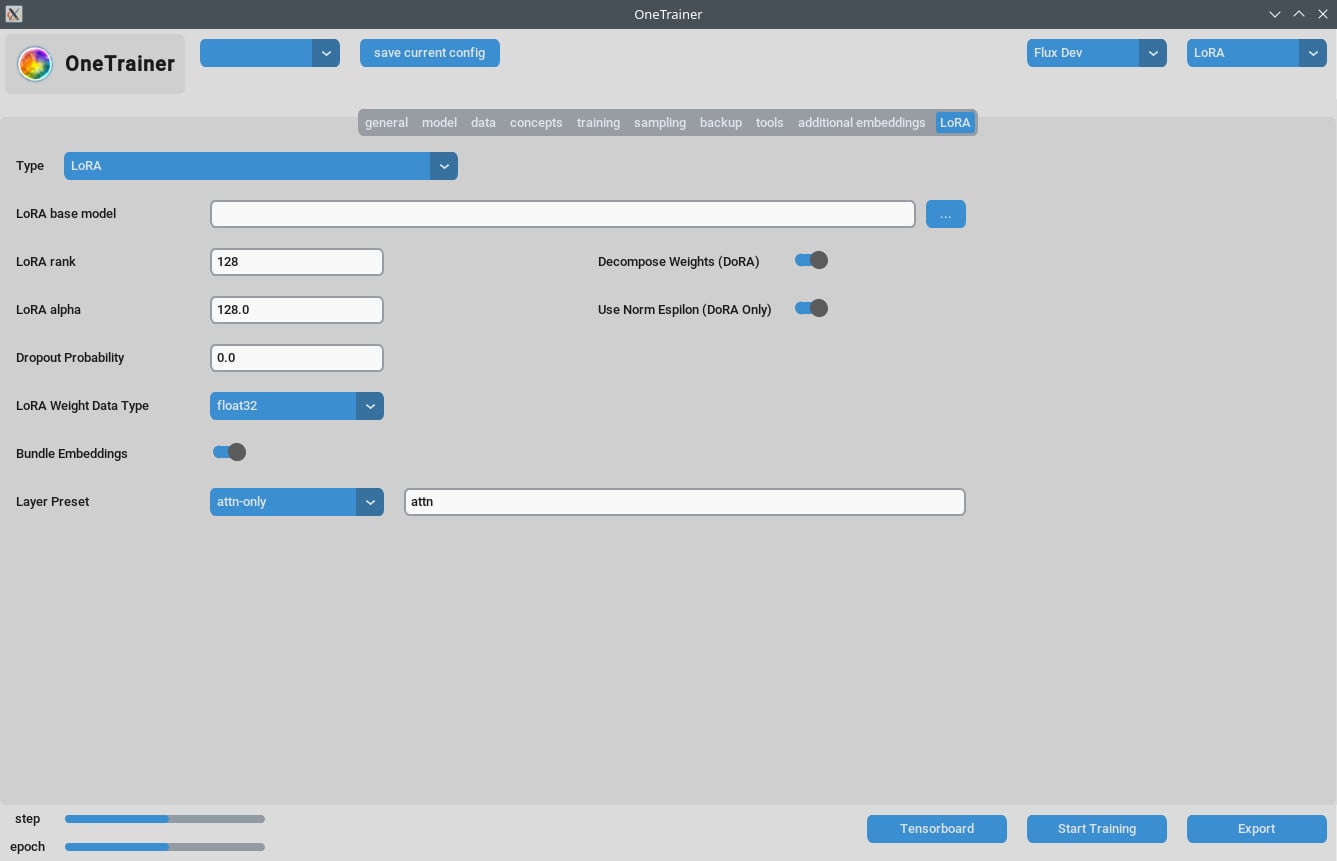

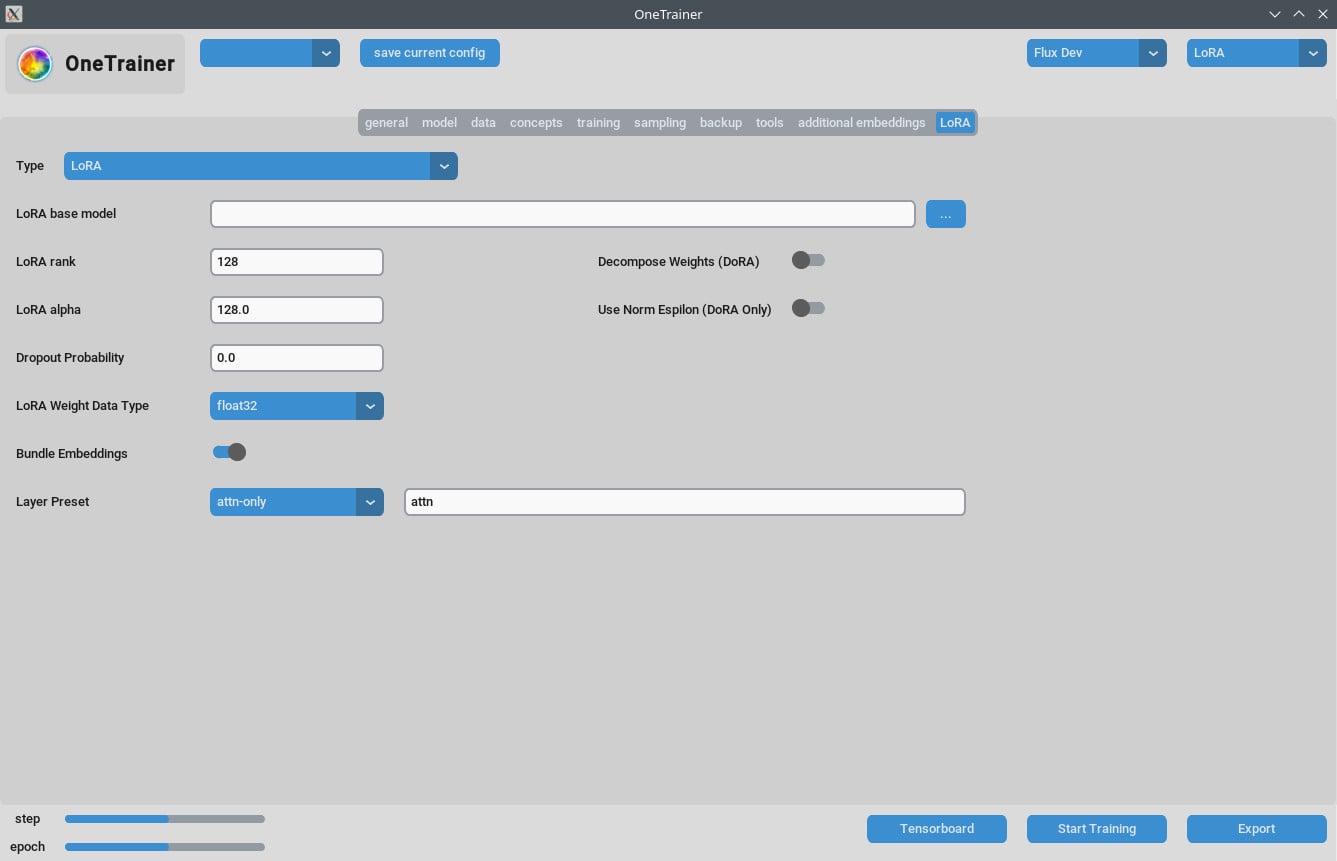

LoRA Sekmesi

- Sıra ve Alpha:

- Bu değerleri aynı tut (örneğin, 64/64, 32/32) ya da öğrenme hızını ona göre ayarla.

- Sonuç LoRA Modelleri:

- En son ComfyUI versiyonlarında kullanıyorsan güncellemelerin uygulandığından emin ol.

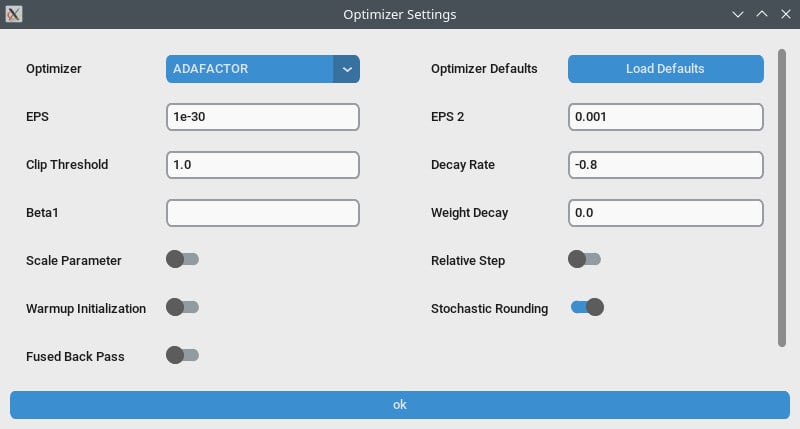

Performans Optimizasyonu

- Gradient Checkpointing:

- Yavaş hızlar yaşıyorsan bunu devre dışı bırakmayı dene, özellikle donanımın yüksek VRAM destekliyorsa.

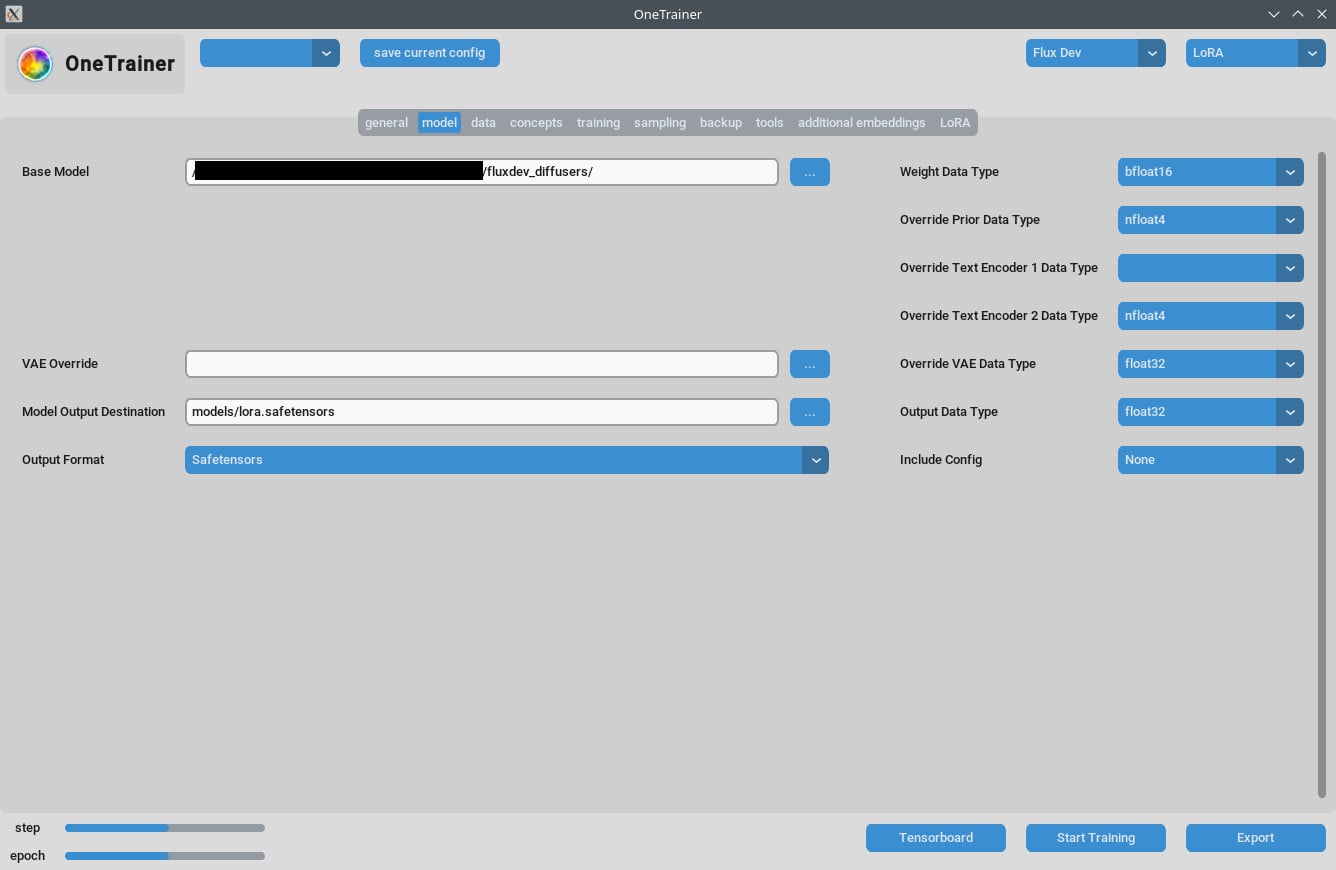

- bf16 vs nfloat4:

- "model" sekmesinde

Override Prior Data Typeayarını bf16'ya değiştir, böylece kalite artabilir. Bu ayar VRAM ve hızı etkiler.

- "model" sekmesinde

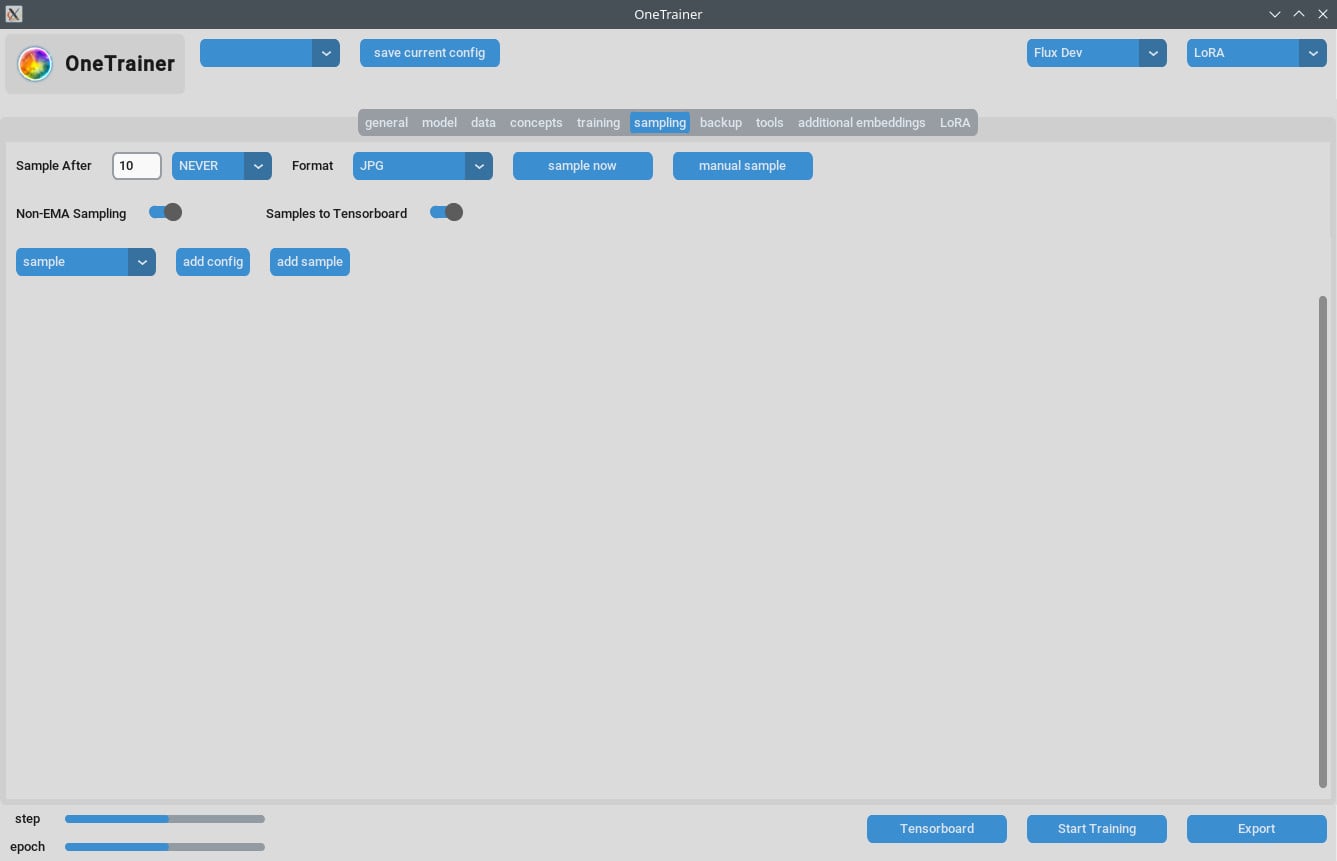

Örnekleme Sorunlarını Yönetme

- Bazı kullanıcılar örnekleme sırasında Out Of Memory (OOM) hataları yaşadı. GPU'nun yeterli VRAM'e sahip olduğundan emin ol.

- OneTrainer'ı düzenli olarak güncelle, böylece bu tür sorunları gidermek için hata düzeltmelerini ve yamanları alırsın.

Çoklu Konsept Eğitimi için İpuçları

Mevcut Sınırlamalar

- Aynı seansta farklı tetik kelimelerle birden fazla kişiyi eğitmek genellikle başarısız olabilir.

- Farklı nesneler veya durumlar (örneğin, spor ayakkabılar ve belirli arabalar) daha iyi çalışır.

En İyi Uygulamalar

- Kısa Açıklamalar:

- Kısa, doğal dil ile yazılmış açıklamalar kullan. Bunlar birkaç yüz adımda iyi sonuçlar veriyor.

- LoRA Yığma:

- Bir konsept LoRA'sı ile karakter LoRA'sını yığmak, birleşik eğitimden daha iyi sonuçlar verir.

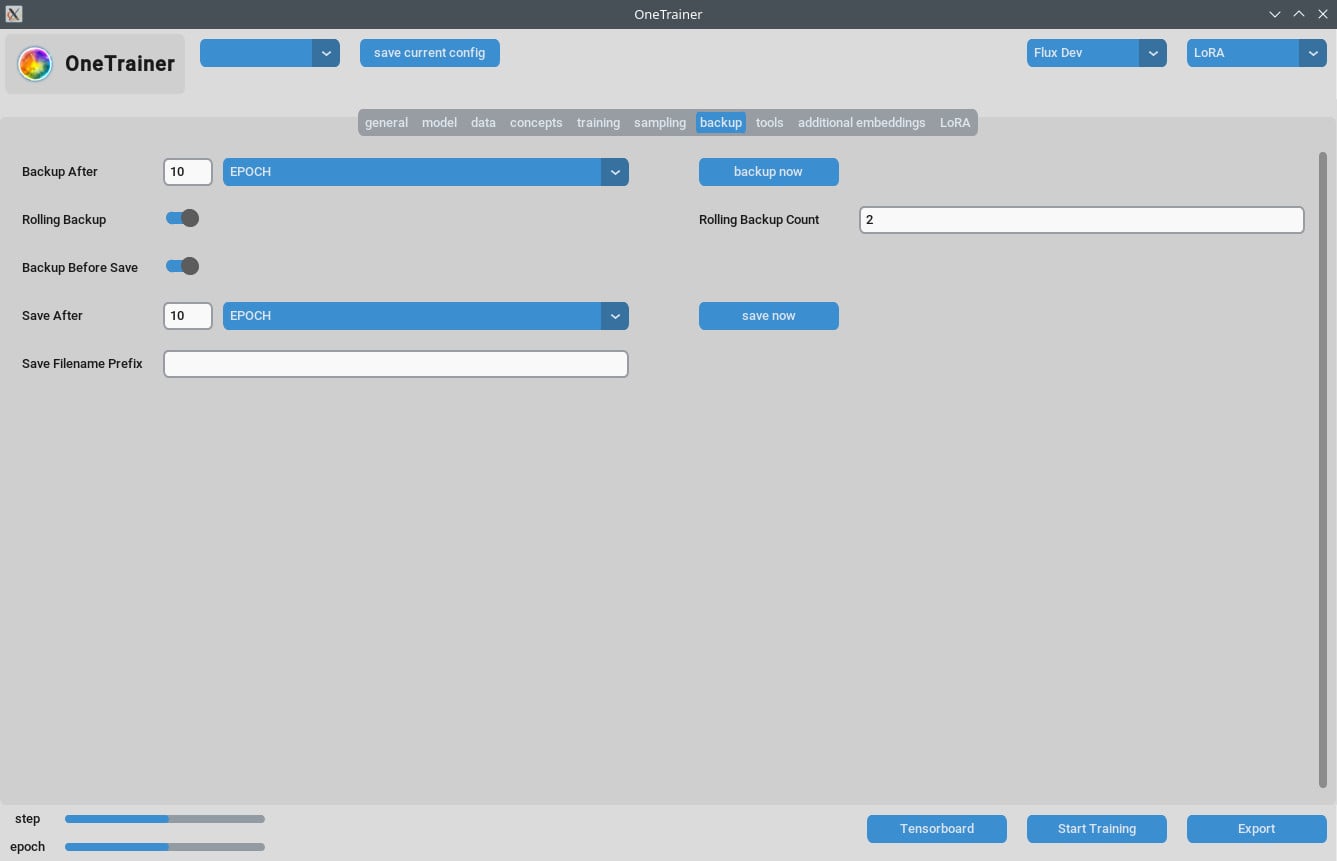

Açıklamalar ve Veri Yönetimi

- Eğitim verini dikkatlice organize et. Epoch sayısı verinin karmaşıklığına bağlıdır.

- Kısa ve net açıklamalar, eğitim verimliliğini artırabilir.

Sıkça Sorulan Sorular

S1: OneTrainer'ı Flux.1 dışındaki modeller için kullanabilir miyim?

Evet, OneTrainer SD 1.5, SDXL ve daha fazlasını destekliyor. Ayarlar modele göre değişir.

S2: OneTrainer otomatik olarak konsept adını tetik kelime olarak mı kullanıyor?

Evet, konsept adı tetik kelime gibi iş görebilir. Projeye anlam katacak şekilde olmasına dikkat et.

S3: Eğitimin sırasında VRAM'imi nasıl etkili bir şekilde yönetebilirim?

Gradient Checkpointing ayarını CPU_OFFLOAD yap. Bu ayar, hızında büyük bir kayba neden olmadan VRAM kullanımını azaltır.

S4: NF4 kullanmak ile tam hassasiyetli katmanlar arasında ne gibi bir fark var?

NF4, VRAM kullanımını azaltır ama kaliteyi biraz düşürebilir. Tam hassasiyetli katmanlar kaliteyi korur ama daha fazla VRAM gerektirir.

S5: LoRA modelimin boyutunu nasıl küçültebilirim?

Rank ve Alpha değerlerini düşürebilir veya LoRA weight data type ayarını bfloat16 olarak ayarlayabilirsin. Bu boyutu azaltır ama kaliteyi etkileyebilir.

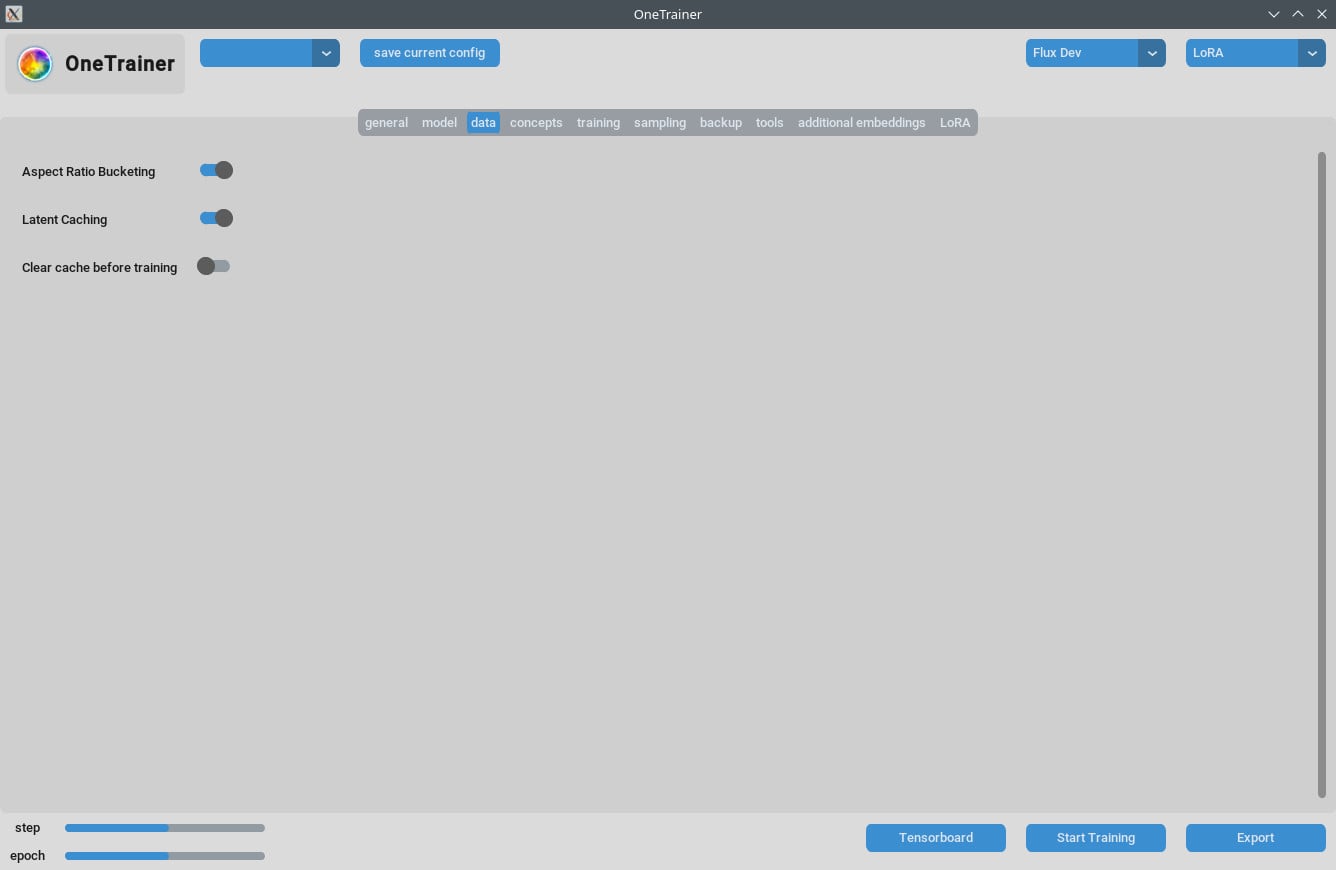

S6: OneTrainer çoklu çözünürlük eğitimini destekliyor mu?

Evet, OneTrainer çoklu çözünürlük eğitimini destekliyor. Kurulum için OneTrainer wiki'deki yönergeleri takip et.

S7: DoRA kullanırken görüntülerim pembe statik olarak görünüyor. Ne yapmalıyım?

Dikkat katmanı ayarlarını kontrol et. Bu soruna neden olabileceği için dikkat katmanlarının "full" olarak kullanılmaması gerekiyor.

S8: OneTrainer'da birden fazla konuyu nasıl yönetebilirim?

Farklı konular için farklı tekrar değerleri set ederek dengeli eğitim yap. Verileri dikkatlice organize et ki her konu eşit şekilde eğitim alabilsin.

S9: OneTrainer'da 'split mode' karşılığı var mı?

OneTrainer'da 'split mode' yok. Bunun yerine VRAM'i daha etkili bir şekilde yönetmek için Gradient Checkpointing'de CPU_OFFLOAD gibi ayarları kullan.

S10: OneTrainer ayarlarını daha yüksek VRAM kullanarak kaliteyi artıracak şekilde ayarlayabilir miyim?

Evet, çözünürlüğü artırabilir ve veri türleri ile gradient checkpointing ayarlarını ayarlayarak kaliteyi artırabilirsin.

Bu kılavuz, OneTrainer'ı Flux AI modelleri ile etkili bir şekilde kullanman için gereken tüm adımları, ayarları ve çözümleme ipuçlarını sağlamalı. İyi eğitimler!