- pub

Astuces et réglages optimisés pour OneTrainer : Formation Flux.1 LoRA et DoRA (20 % plus rapide)

Préparer le Training

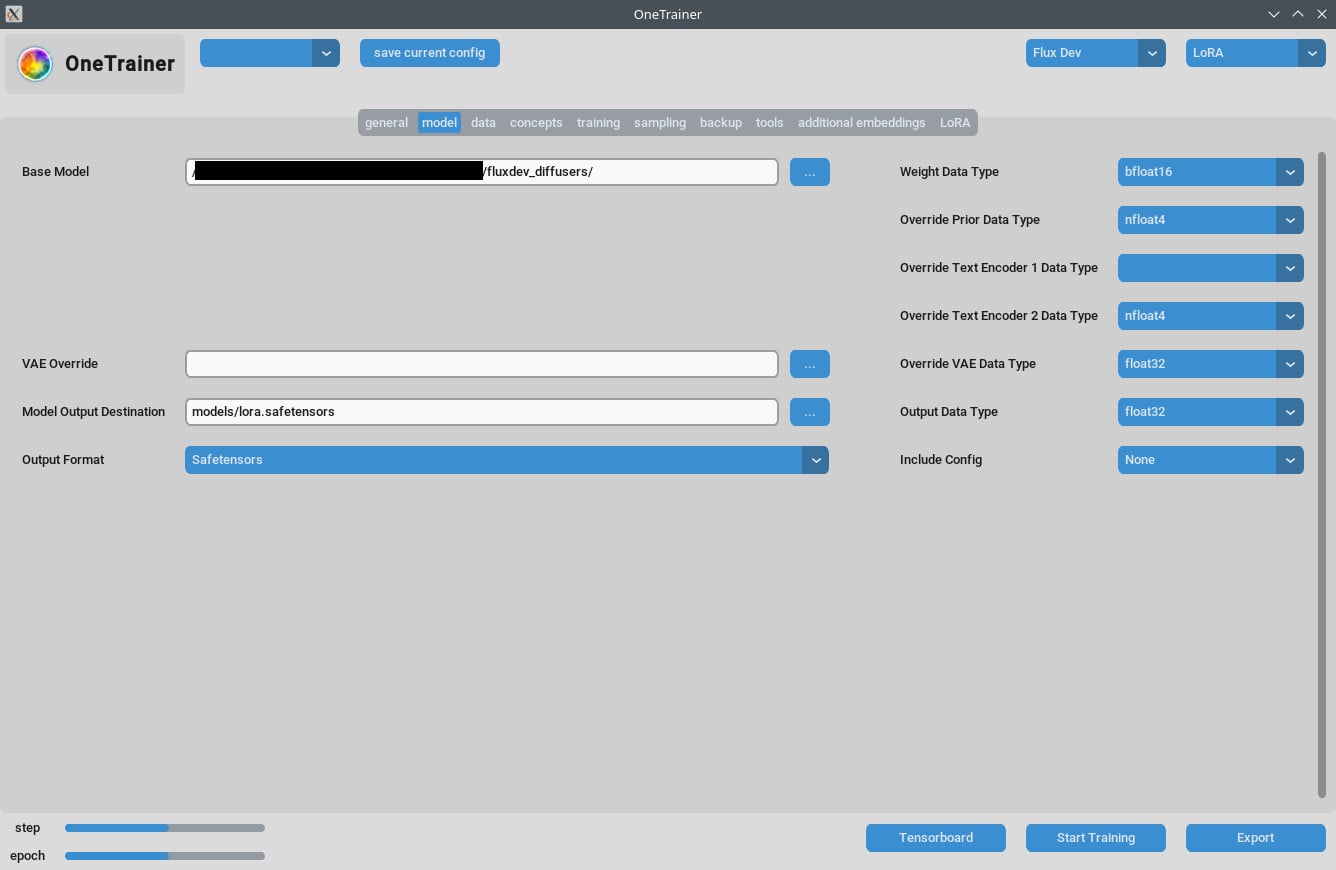

Choisir le Modèle

D'abord, assure-toi de bien avoir choisi le bon modèle Flux AI. OneTrainer supporte plusieurs modèles, comme Flux.1 dev, pro, et schnell. Choisis un modèle qui colle à ton projet.

- Acquérir le Modèle : Télécharge le modèle que tu veux depuis des sources officielles, comme Hugging Face.

- Charger le Modèle : Dans OneTrainer, va dans les paramètres du modèle et charge les fichiers du modèle.

Mettre en Place l'Environnement

Exigences Matérielles :

- GPU : Un minimum de 3060 est recommandé. Un 4090 donnera de meilleures performances.

- VRAM : Au moins 12 Go pour gérer des résolutions plus élevées.

- RAM : Minimum 10 Go de RAM, plus c'est mieux.

Exigences Logicielles :

- Système d'Exploitation : Ça marche sur Windows et Linux.

- Dépendances : Vérifie que toutes les dépendances sont installées. Regarde la documentation de OneTrainer pour la liste des bibliothèques et outils requis.

Paramètres et Configurations Détailés

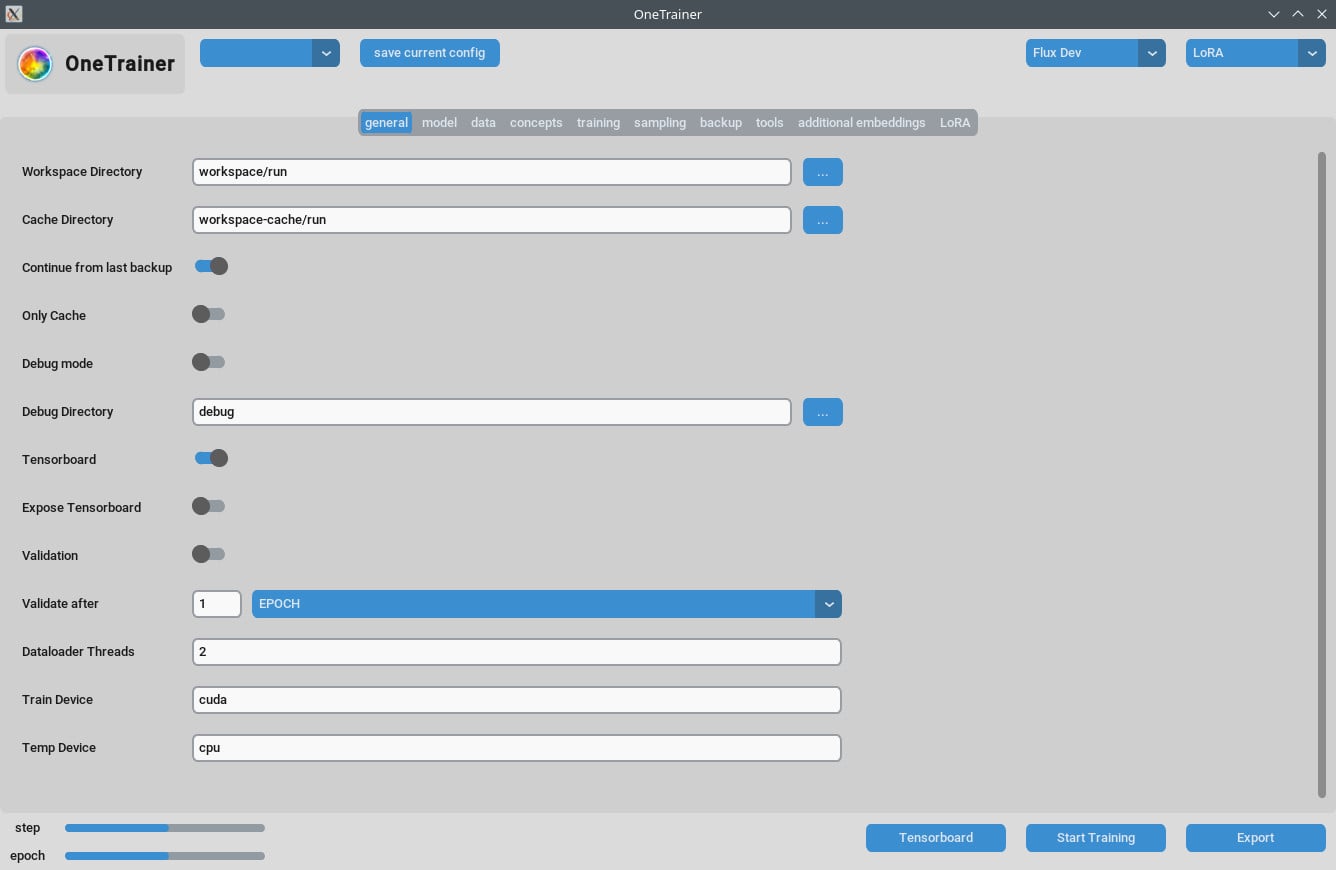

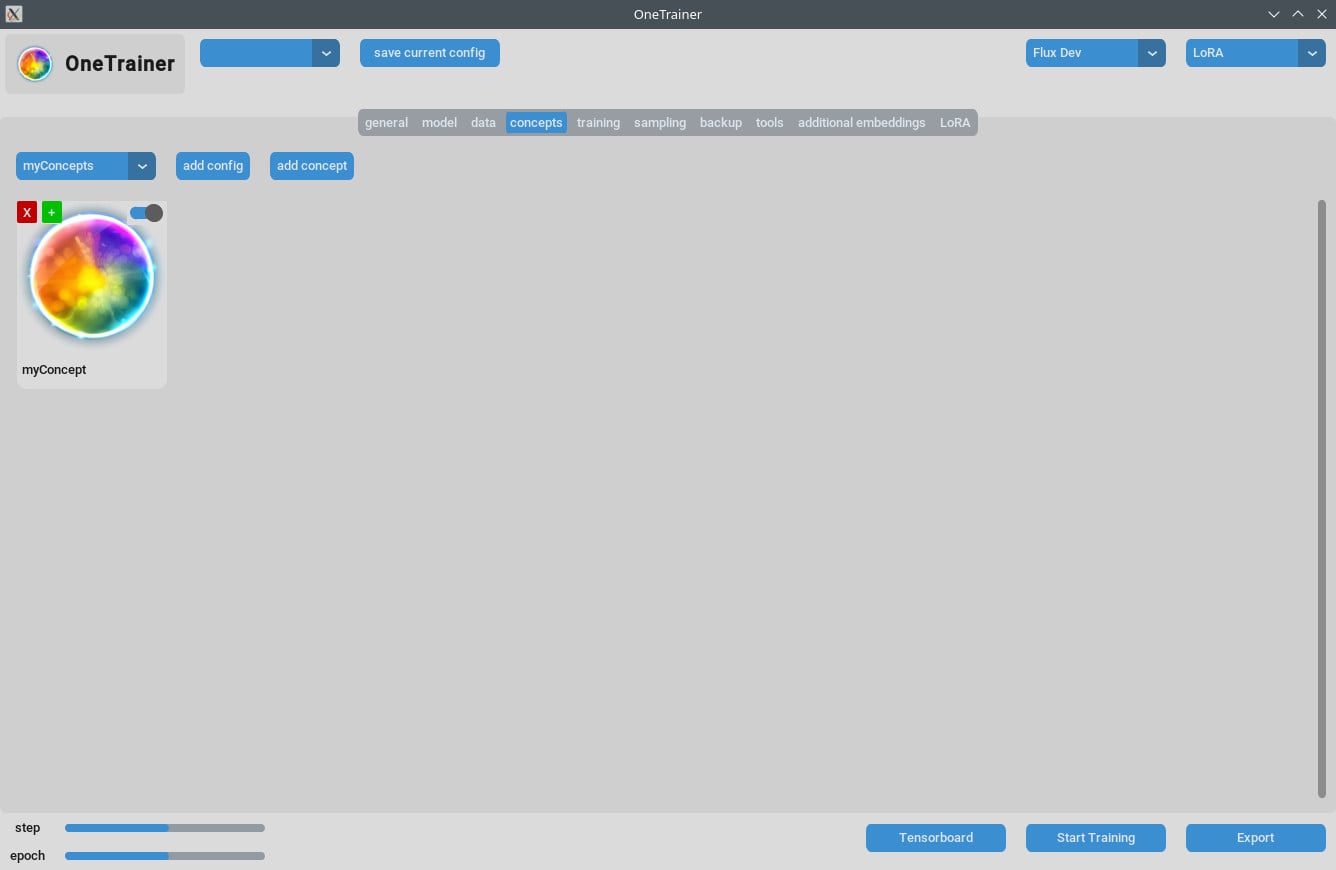

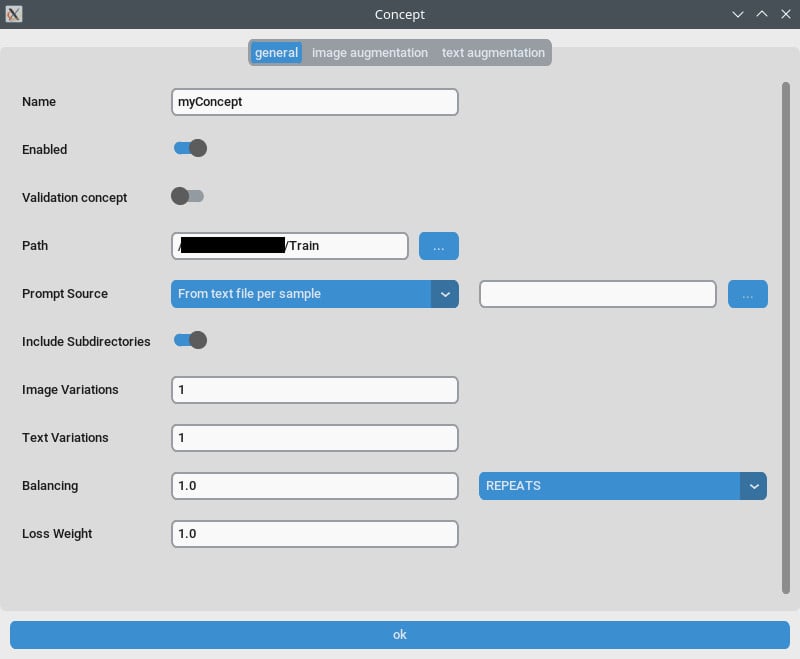

Onglet Concept/Paramètres Généraux

- Répétitions : Mets

Répetitionsà 1. Gère le nombre de répétitions avec leNombre d'Époquesdans l’onglet de formation. - Source de l'Annonce : Utilise "depuis un seul fichier texte" si tu veux un "mot déclencheur" au lieu de légendes individuelles pour chaque image. Pointe ce paramètre vers un fichier texte contenant ton mot/phrase déclencheur.

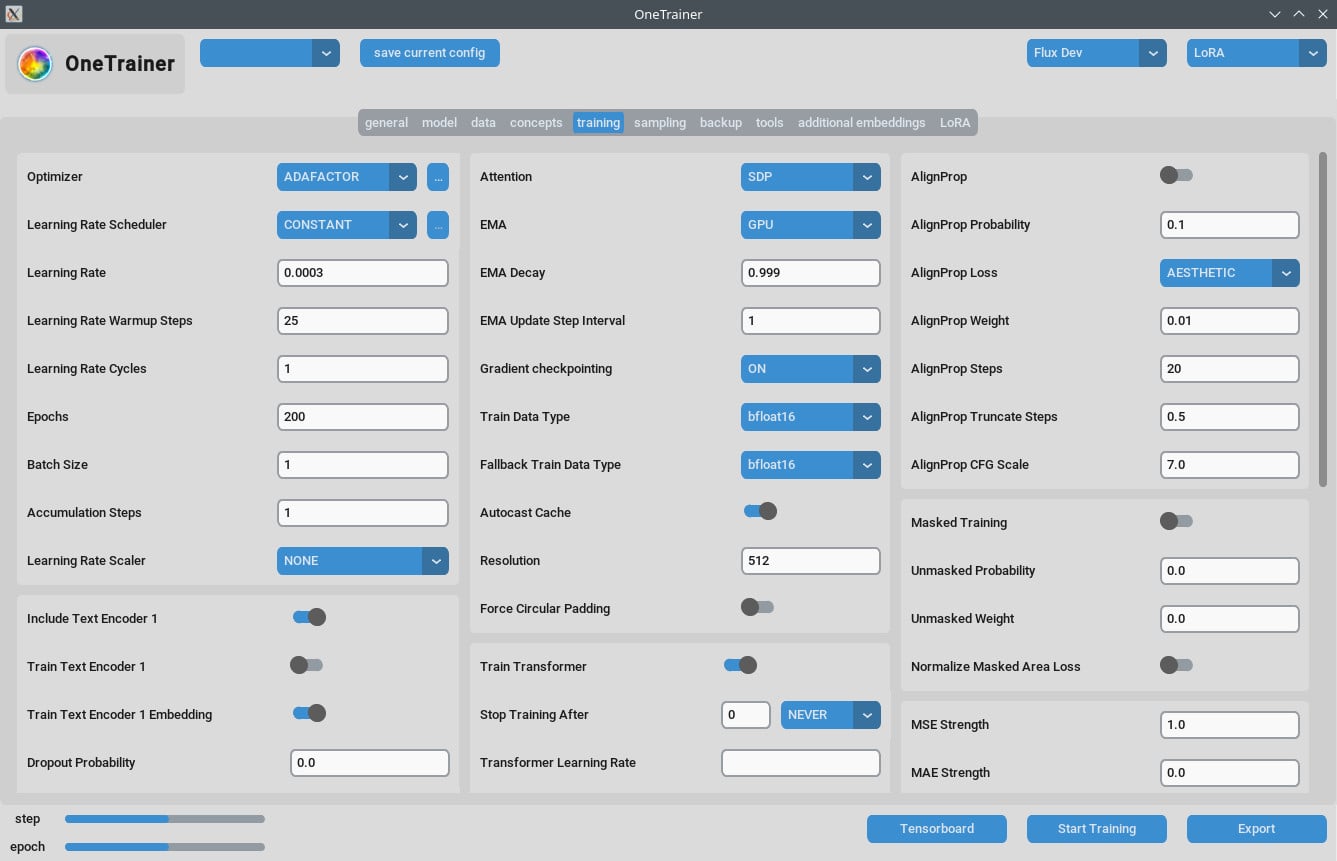

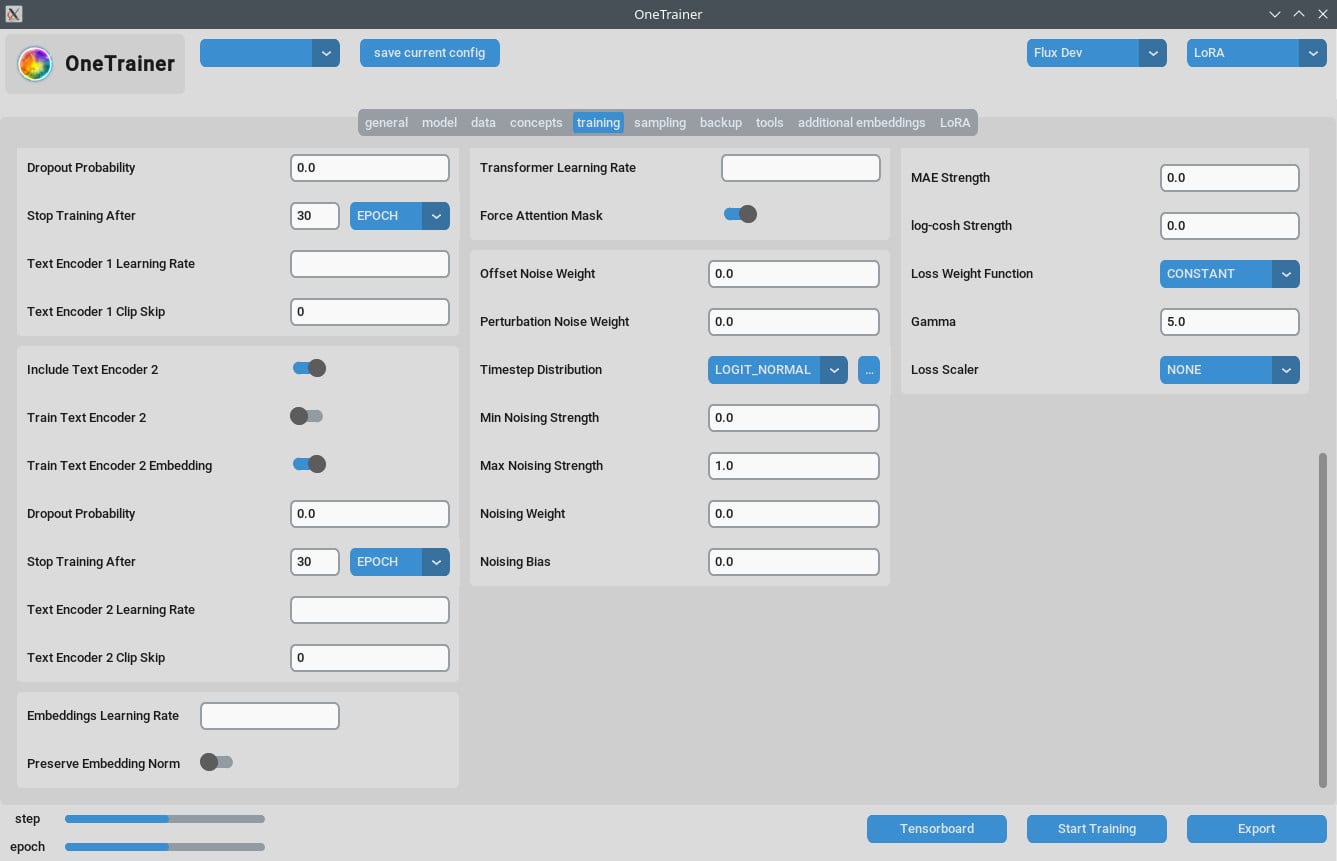

Onglet de Formation

Paramètres de Résolution

- Pour Meilleure Qualité :

- Mets

Résolutionà 768 ou 1024 pour des sorties de meilleure qualité.

- Mets

- Paramètres EMA :

- EMA : Utilise ça pendant les formations SDXL.

- EMA GPU : Pour économiser de la VRAM, mets EMA de "GPU" à "OFF."

- Taux d'Apprentissage :

- Un point de départ pourrait être 0.0003 ou 0.0004. Ajuste selon tes besoins.

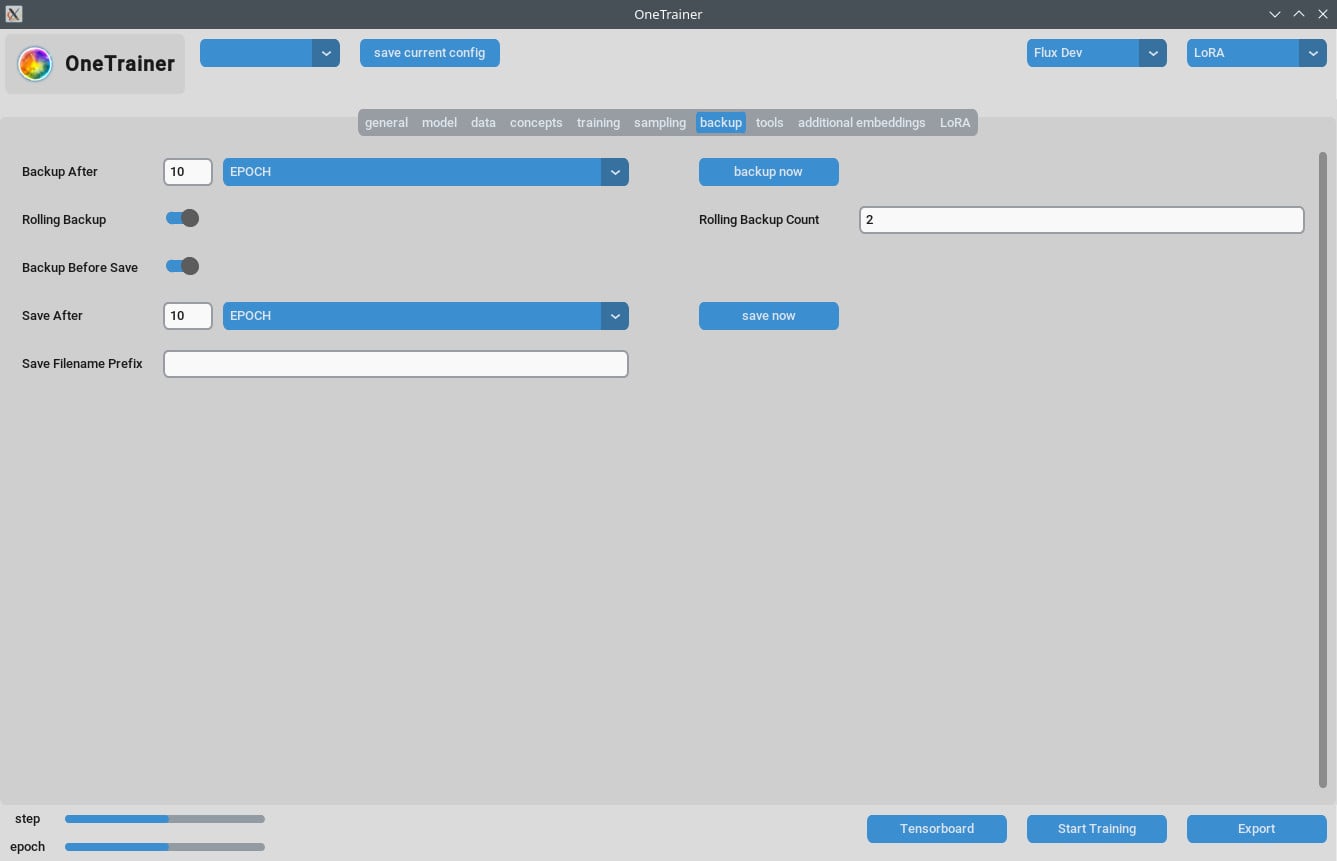

- Nombre d'Époques :

- En général, 40 époques donnent de bons résultats. Ajuste en fonction de la complexité de ton dataset.

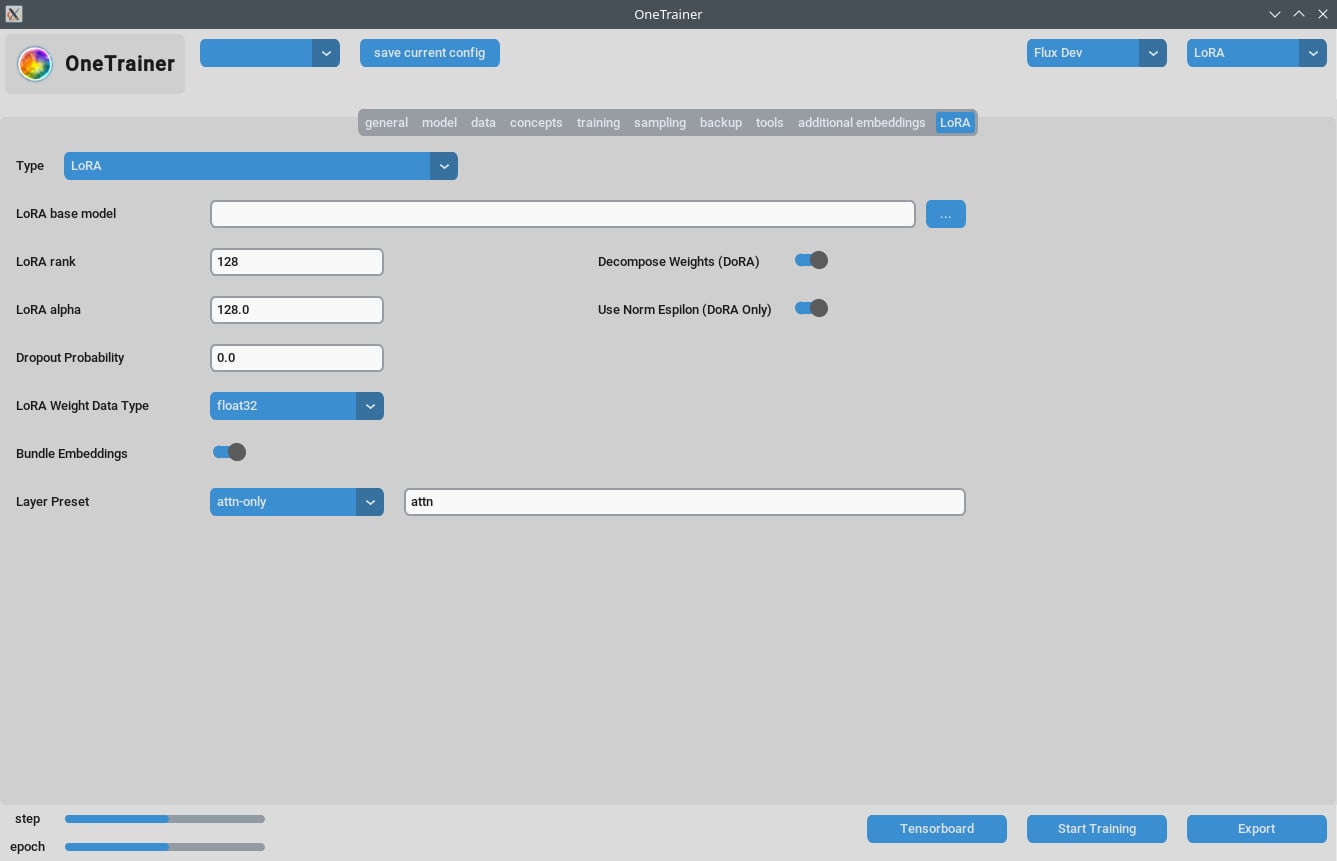

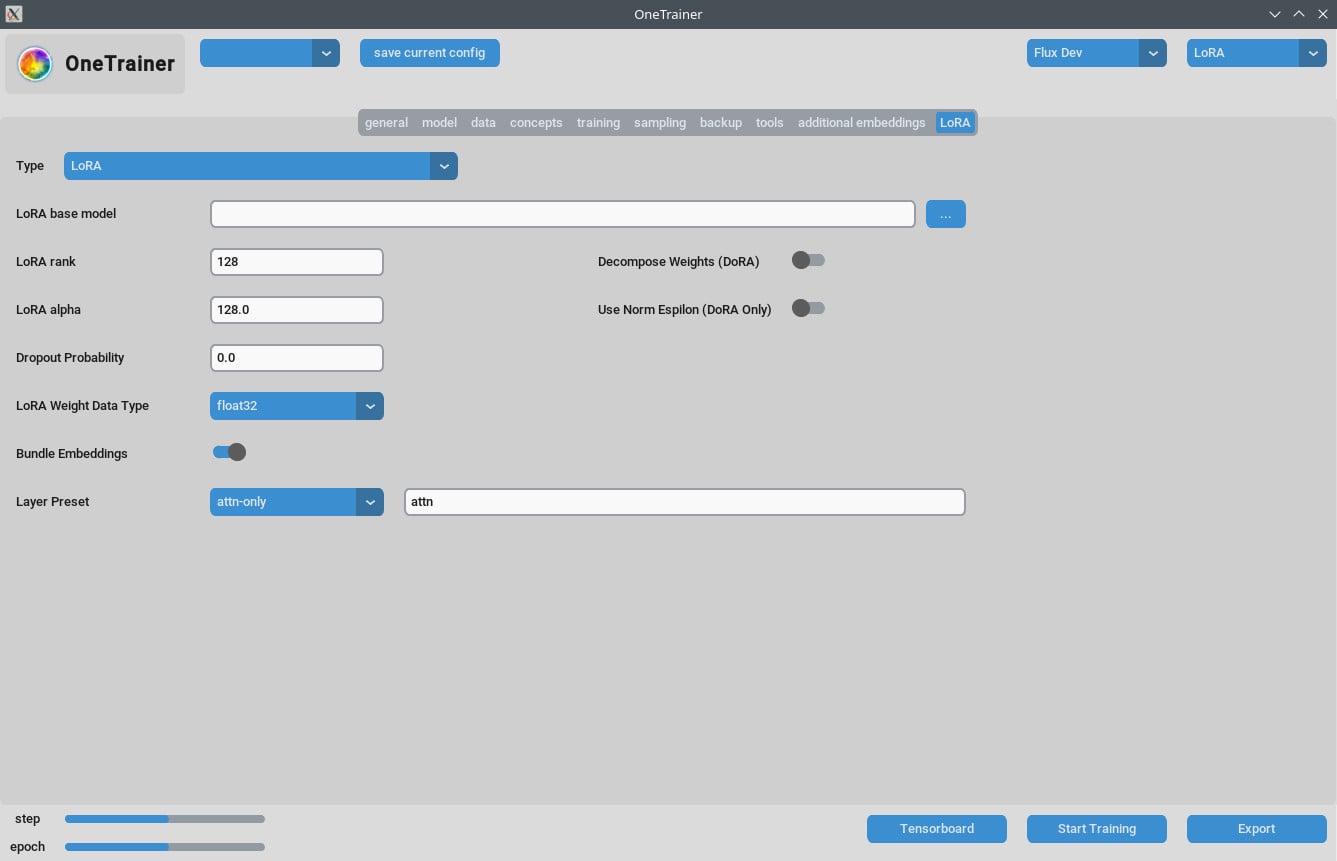

Onglet LoRA

- Rang et Alpha :

- Garde les mêmes valeurs (par exemple, 64/64, 32/32) ou ajuste ton taux d'apprentissage en conséquence.

- Résultats des Modèles LoRA :

- Assure-toi que les mises à jour sont appliquées si tu utilises des versions récentes de ComfyUI.

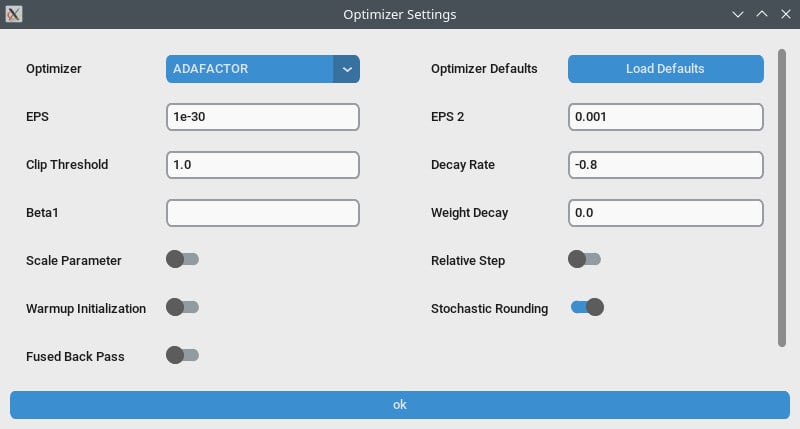

Optimisation de la Performance

- Gradient Checkpointing :

- Essaie de désactiver ça si tu as des vitesses lentes, surtout si ton matériel a plus de VRAM.

- bf16 vs nfloat4 :

- Dans l'onglet "modèle", change

Override Prior Data Typeà bf16 pour potentiellement améliorer la qualité. Cela impacte la VRAM et la vitesse.

- Dans l'onglet "modèle", change

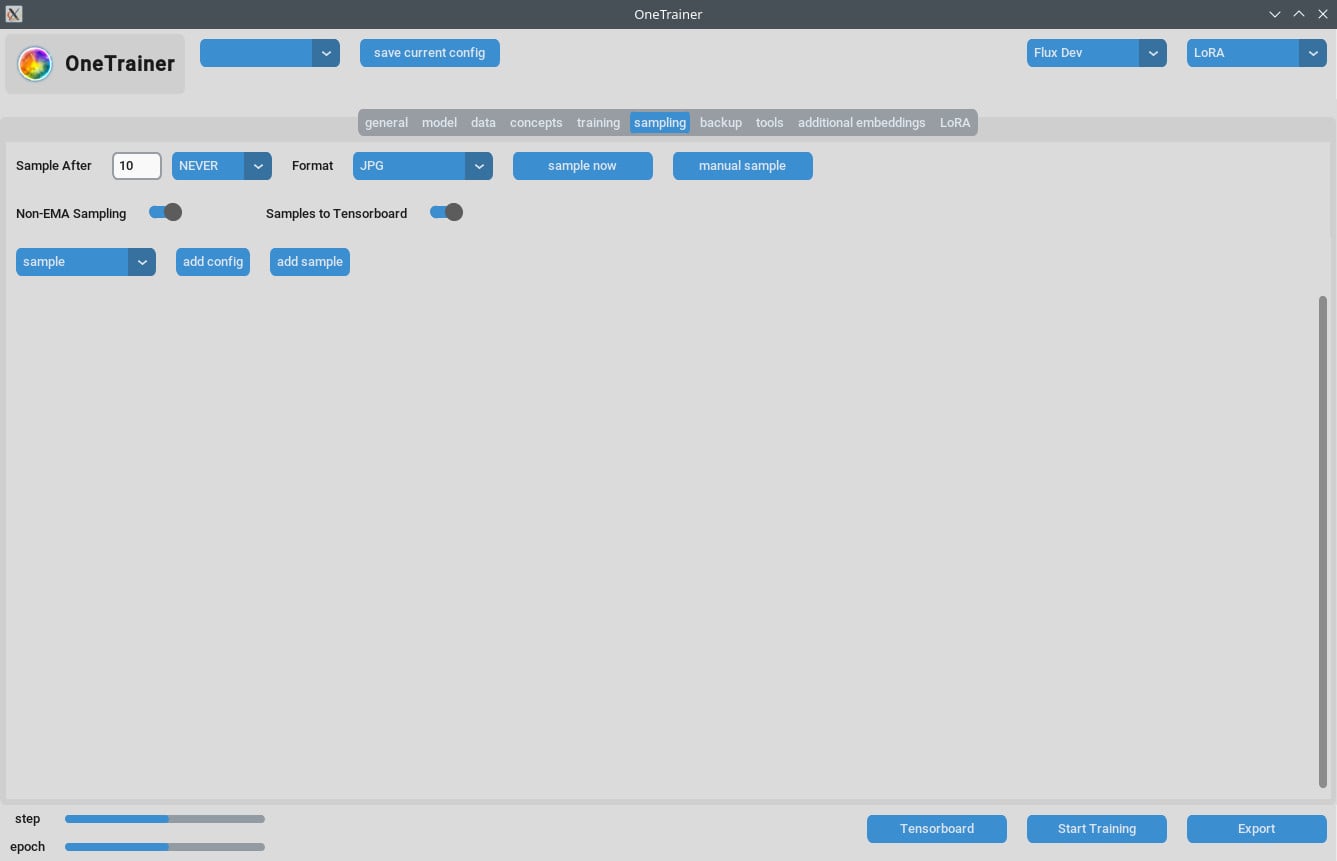

Gestion des Problèmes d'Échantillonnage

- Certains utilisateurs ont eu des erreurs de mémoire (OOM) pendant l'échantillonnage. Assure-toi que ton GPU a suffisamment de VRAM.

- Mets régulièrement à jour OneTrainer pour intégrer les corrections de bugs et patches qui adressent ces problèmes.

Conseils pour le Training Multi-Concept

Limitations Actuelles

- Former plusieurs personnes avec différents mots déclencheurs en même temps échoue souvent.

- Différents objets ou situations (comme des chaussures de training et des voitures spécifiques) fonctionnent mieux.

Meilleures Pratiques

- Légendes Courtes :

- Utilise des légendes courtes en langage naturel. Ça marche bien en quelques centaines d'étapes.

- Empiler les LoRAs :

- Empiler une LoRA de concept et de personnage donne de meilleurs résultats qu'une formation combinée.

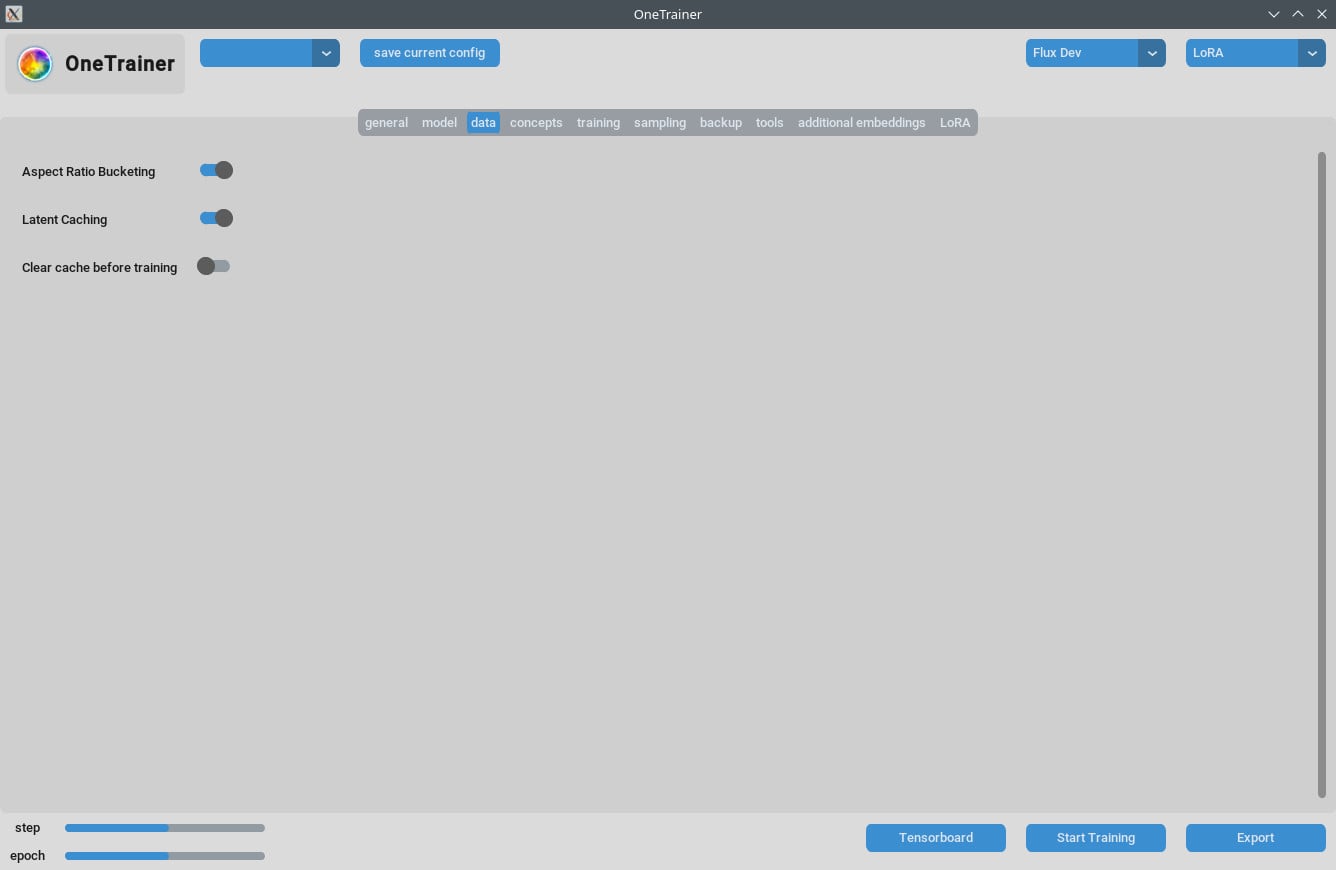

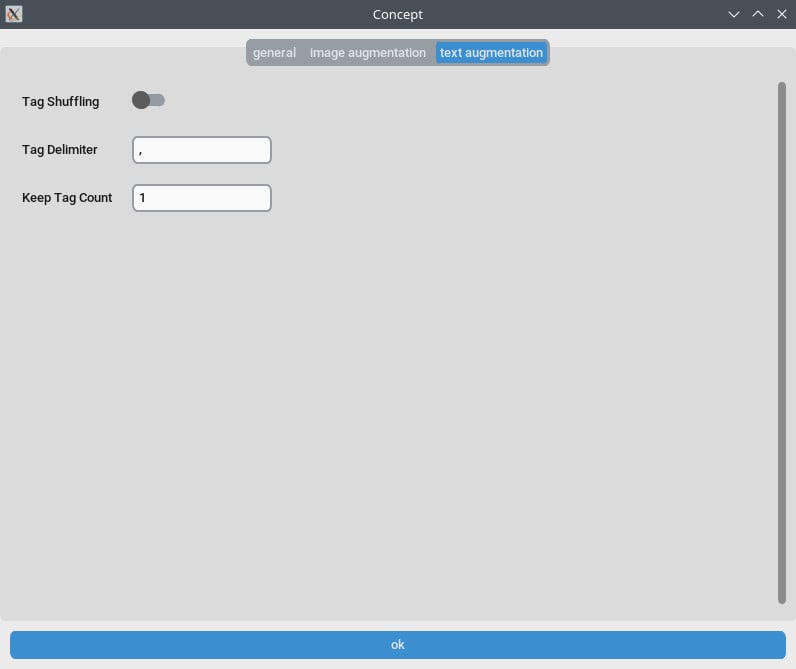

Gestion des Légendes et des Données

- Organise soigneusement tes données de formation. Le nombre d'époques dépend de la complexité de tes données.

- Des légendes courtes et précises peuvent vraiment améliorer l'efficacité de la formation.

FAQ

Q1 : Je peux utiliser OneTrainer pour des modèles autres que Flux.1 ?

Oui, OneTrainer supporte SD 1.5, SDXL, et d'autres. Les paramètres varieront selon le modèle.

Q2 : OneTrainer utilise-t-il automatiquement le nom du concept comme mot déclencheur ?

Oui, le nom du concept peut agir comme un mot déclencheur. Assure-toi qu'il soit significatif pour ton projet.

Q3 : Comment gérer efficacement la VRAM pendant la formation ?

Mets Gradient Checkpointing sur CPU_OFFLOAD. Ce paramètre aide à réduire l'utilisation de VRAM sans trop impacter la vitesse.

Q4 : Quel est l'impact de l'utilisation de NF4 par rapport aux couches à pleine précision ?

NF4 réduit l'utilisation de VRAM mais peut légèrement diminuer la qualité. Les couches à pleine précision gardent la qualité mais nécessitent plus de VRAM.

Q5 : Comment réduire la taille de mon modèle LoRA ?

Tu peux réduire les valeurs de Rang et Alpha ou mettre le type de données de poids LoRA sur bfloat16. Ça réduit la taille mais peut affecter la qualité.

Q6 : OneTrainer peut-il gérer la formation multi-résolution ?

Oui, OneTrainer supporte la formation multi-résolution. Suis les directives dans le wiki de OneTrainer pour le mettre en place.

Q7 : Mes images apparaissent comme du statique rose en utilisant DoRA. Que faire ?

Vérifie les paramètres de ta couche d'attention. Évite d'utiliser "full" pour les couches d'attention car cela pourrait poser problème.

Q8 : Comment gérer plusieurs sujets dans OneTrainer ?

Utilise une formation équilibrée en mettant des valeurs de répétition différentes pour chaque sujet. Organise les données soigneusement pour que chaque sujet ait un entraînement équitable.

Q9 : OneTrainer a-t-il un équivalent au 'mode_split' ?

OneTrainer n'a pas de 'mode_split'. Utilise plutôt des paramètres comme CPU_OFFLOAD pour Gradient Checkpointing afin de mieux gérer la VRAM.

Q10 : Les paramètres de OneTrainer peuvent-ils être ajustés pour une meilleure qualité avec une utilisation plus élevée de VRAM ?

Oui, augmente la résolution et ajuste les types de données et les paramètres de checkpointing pour améliorer la qualité.

Ce guide devrait te fournir tous les étapes nécessaires, les paramètres et les conseils de dépannage pour utiliser efficacement OneTrainer avec les modèles Flux AI. Bon entraînement !