- pub

Geoptimaliseerde OneTrainer Instellingen en Tips voor Flux.1 LoRA en DoRA Training (20% Sneller)

Voorbereiden op Training

Het Model Kiezen

Eerst, zorg dat je het juiste Flux AI model hebt gekozen. OneTrainer ondersteunt verschillende modellen, zoals Flux.1 dev, pro, en schnell. Zorg ervoor dat je een model gebruikt dat past bij jouw project.

- Model Verkrijgen: Download het gewenste model van officiële bronnen, zoals Hugging Face.

- Model Laden: Ga in OneTrainer naar de modelinstellingen en laad de modelbestanden.

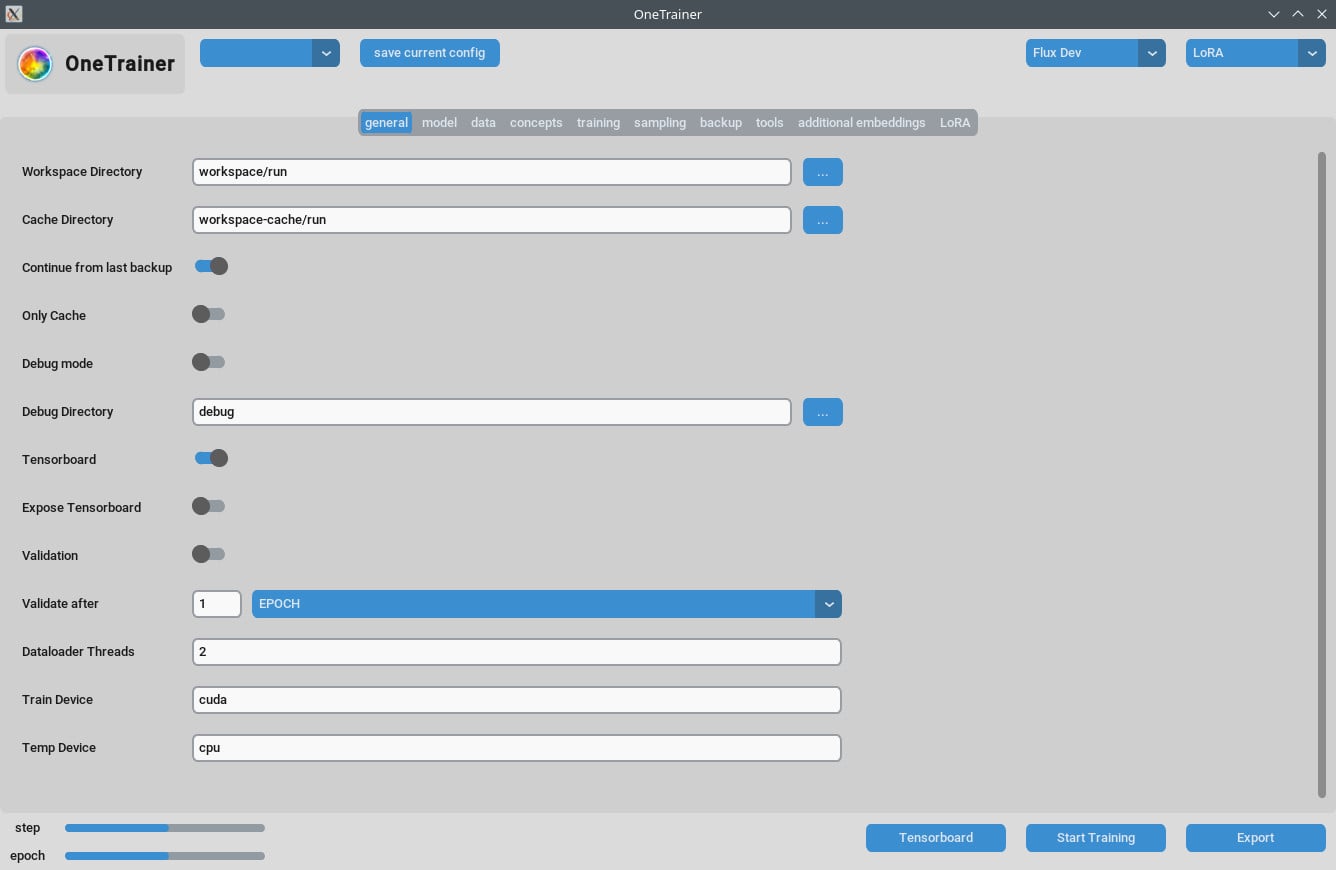

De Omgeving Instellen

Hardware Vereisten:

- GPU: Een 3060 is aanbevolen. Training met een 4090 levert betere prestaties.

- VRAM: Minimaal 12 GB om hogere resoluties aan te kunnen.

- RAM: Ten minste 10 GB RAM is aan te raden, meer is beter.

Software Vereisten:

- Besturingssysteem: Werkt goed op zowel Windows als Linux.

- Afhankelijkheden: Zorg dat alle afhankelijkheden zijn geïnstalleerd. Check de documentatie van OneTrainer voor een lijst van benodigde bibliotheken en tools.

Gedetailleerde Instellingen en Configuraties

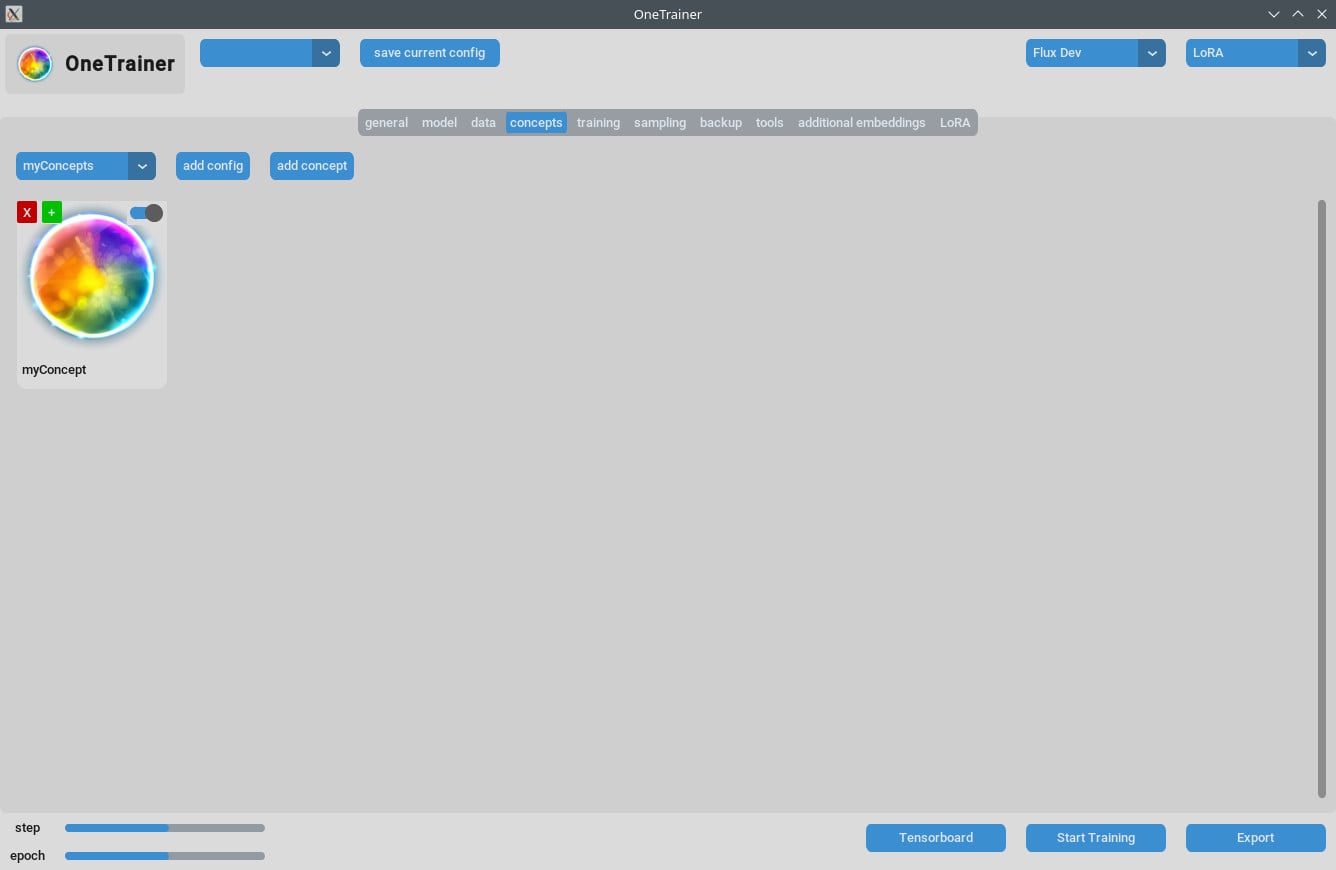

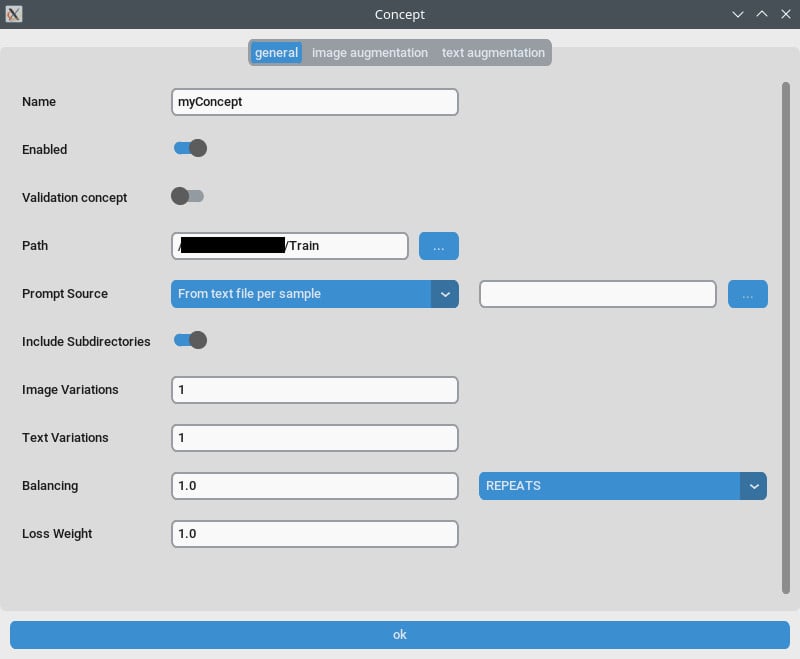

Concept Tab / Algemeen Instellingen

- Herhalingen: Zet

Herhalingenop 1. Beheer het aantal herhalingen via hetAantal Epochsop de trainings tab. - Prompt Bron: Gebruik "van enkel tekstbestand" als je een "triggerwoord" wilt in plaats van aparte captions per afbeelding. Verwijs deze instelling naar een tekstbestand met jouw triggerwoord/-zin.

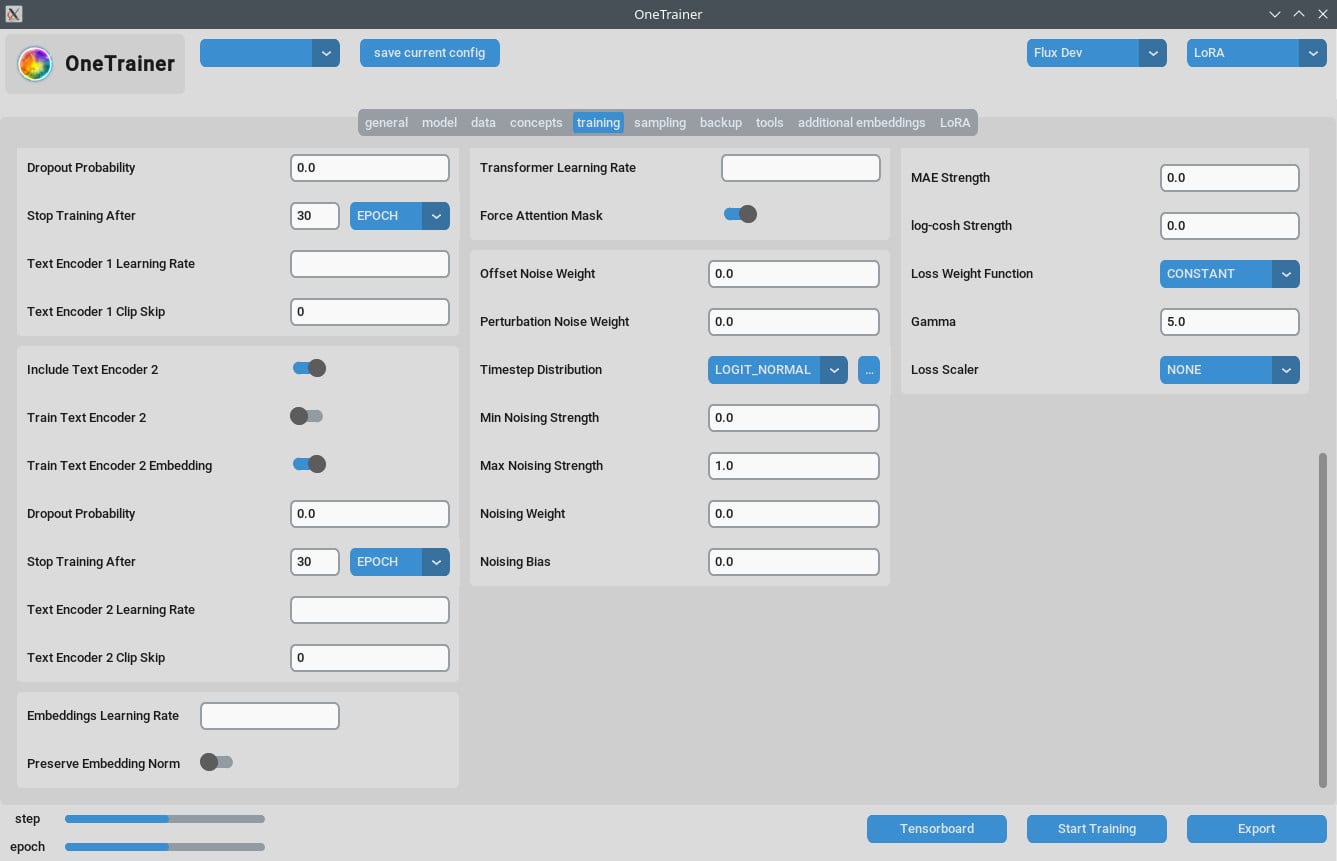

Trainings Tab

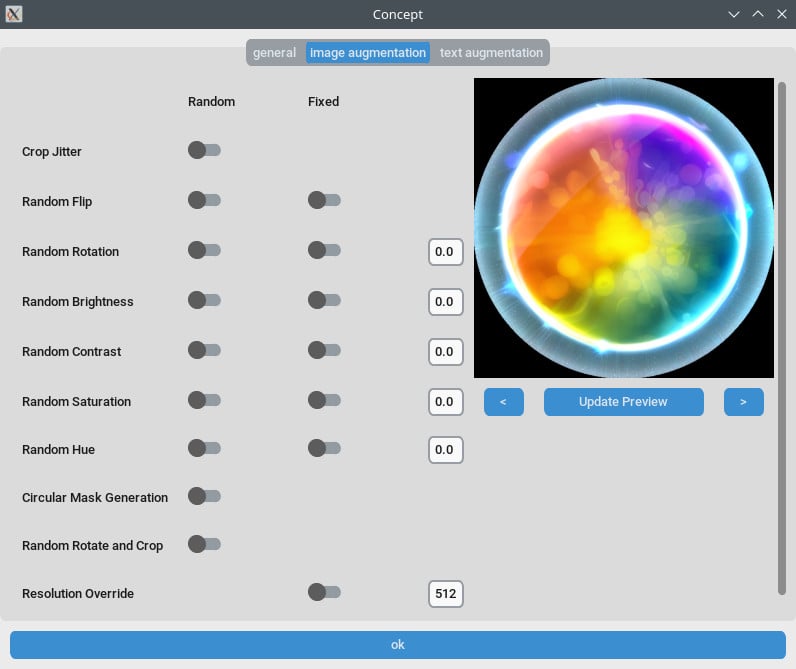

Resolutie Instellingen

- Voor Betere Kwaliteit:

- Zet

Resolutieop 768 of 1024 voor hogere kwaliteit omzettingen.

- Zet

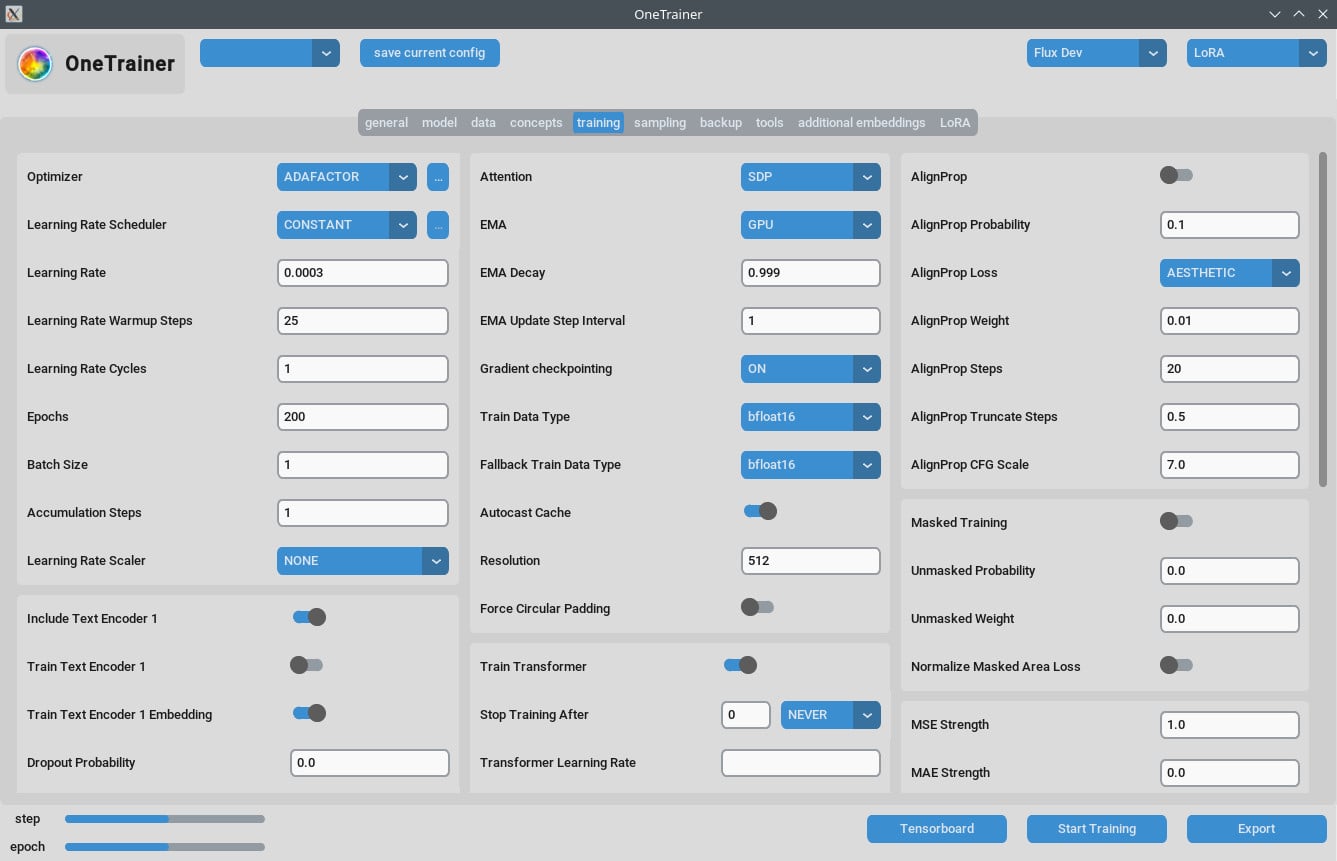

- EMA Instellingen:

- EMA: Gebruik tijdens SDXL trainingen.

- EMA GPU: Om VRAM te besparen, zet EMA van "GPU" naar "UIT."

- Leerpercentage:

- Een startpunt kan 0.0003 of 0.0004 zijn. Pas aan volgens jouw specifieke behoeften.

- Aantal Epochs:

- Gewoonlijk, 40 epochs geven goede resultaten. Pas dit aan op basis van de complexiteit van jouw dataset.

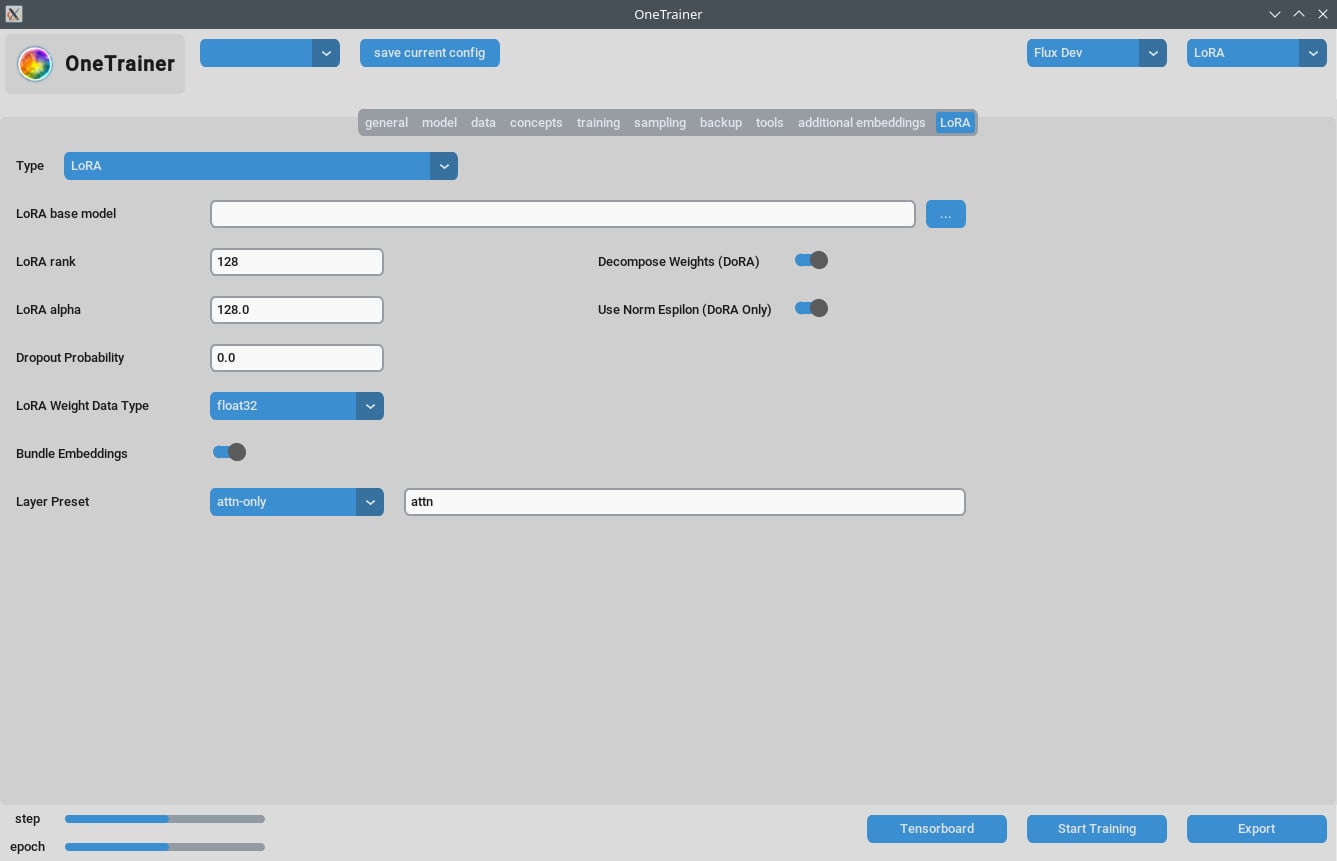

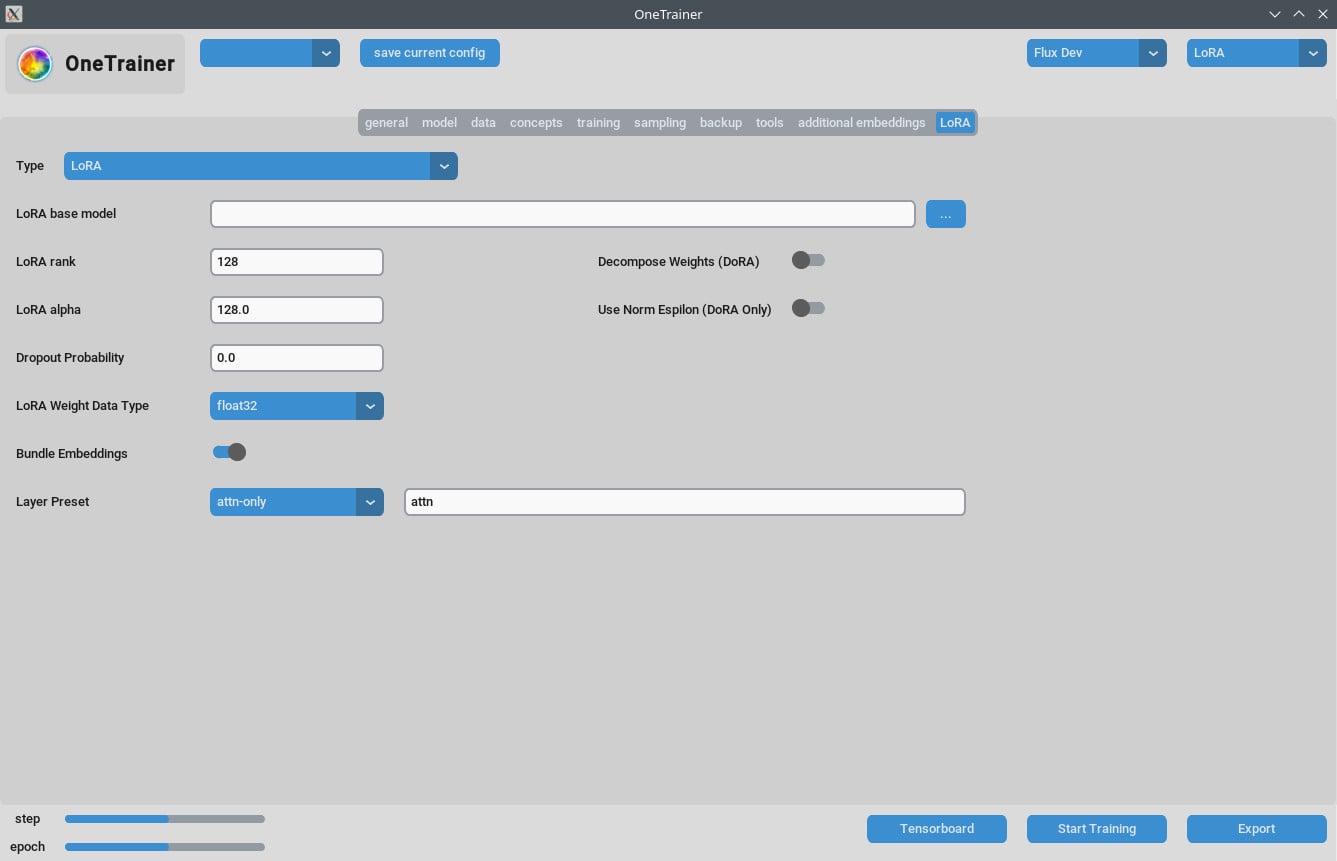

LoRA Tab

- Rank en Alpha:

- Houd deze waarden hetzelfde (bijv. 64/64, 32/32) of pas je leerpercentage aan.

- Resultaten LoRA Modellen:

- Zorg ervoor dat updates worden toegepast als je recente versies van ComfyUI gebruikt.

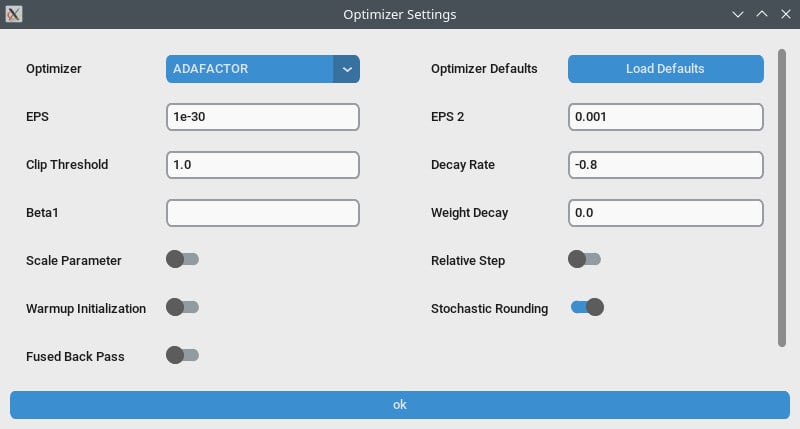

Prestatie Optimalisatie

- Gradient Checkpointing:

- Probeer dit uit te schakelen als je traagheid ervaart, vooral als jouw hardware hogere VRAM ondersteunt.

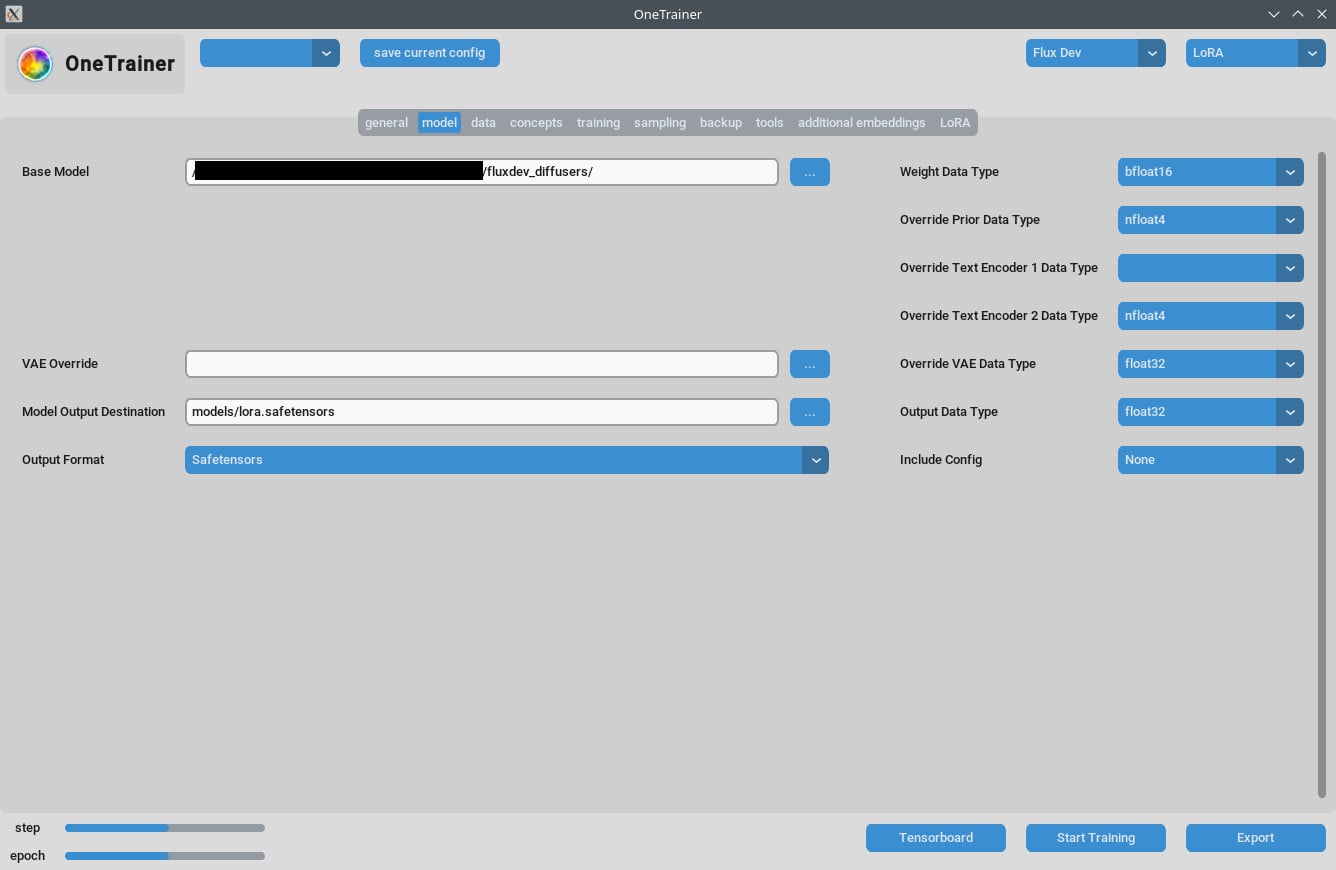

- bf16 vs nfloat4:

- In de "model" tab, verander

Override Prior Data Typenaar bf16 om mogelijk de kwaliteit te verhogen. Deze instelling heeft effect op VRAM en snelheid.

- In de "model" tab, verander

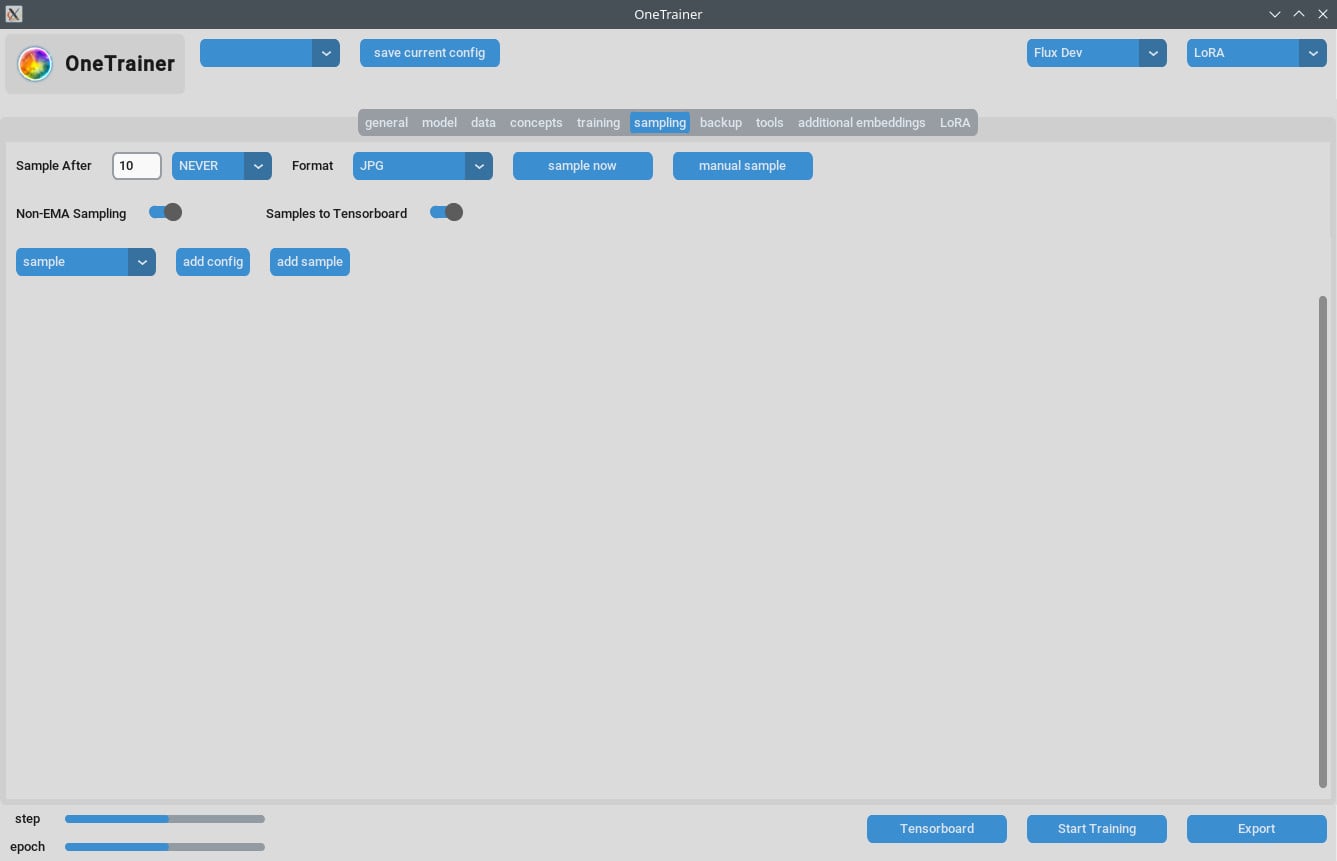

Omgaan met Sampling Problemen

- Sommige gebruikers hebben Out Of Memory (OOM) fouten ervaren tijdens het sampelen. Zorg ervoor dat je GPU voldoende VRAM heeft.

- Update OneTrainer regelmatig om bugfixes en patches te integreren die zulke problemen aanpakken.

Tips voor Multi-Concept Training

Huidige Beperkingen

- Training van meerdere mensen met verschillende triggerwoorden in dezelfde sessie faalt vaak.

- Verschillende objecten of situaties (bijv. trainingschoenen en specifieke auto’s) werken beter.

Beste Praktijken

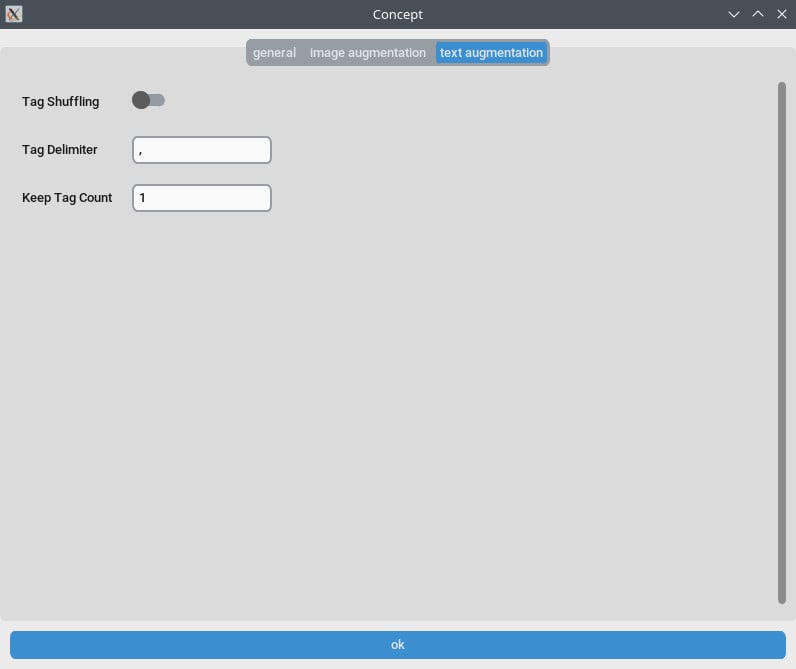

- Korte Captions:

- Gebruik korte, natuurlijke taal captions. Deze werken vaak goed in een paar honderd stappen.

- Stapelen van LoRA’s:

- Het stapelen van een concept en karakter LoRA geeft betere resultaten dan gecombineerde training.

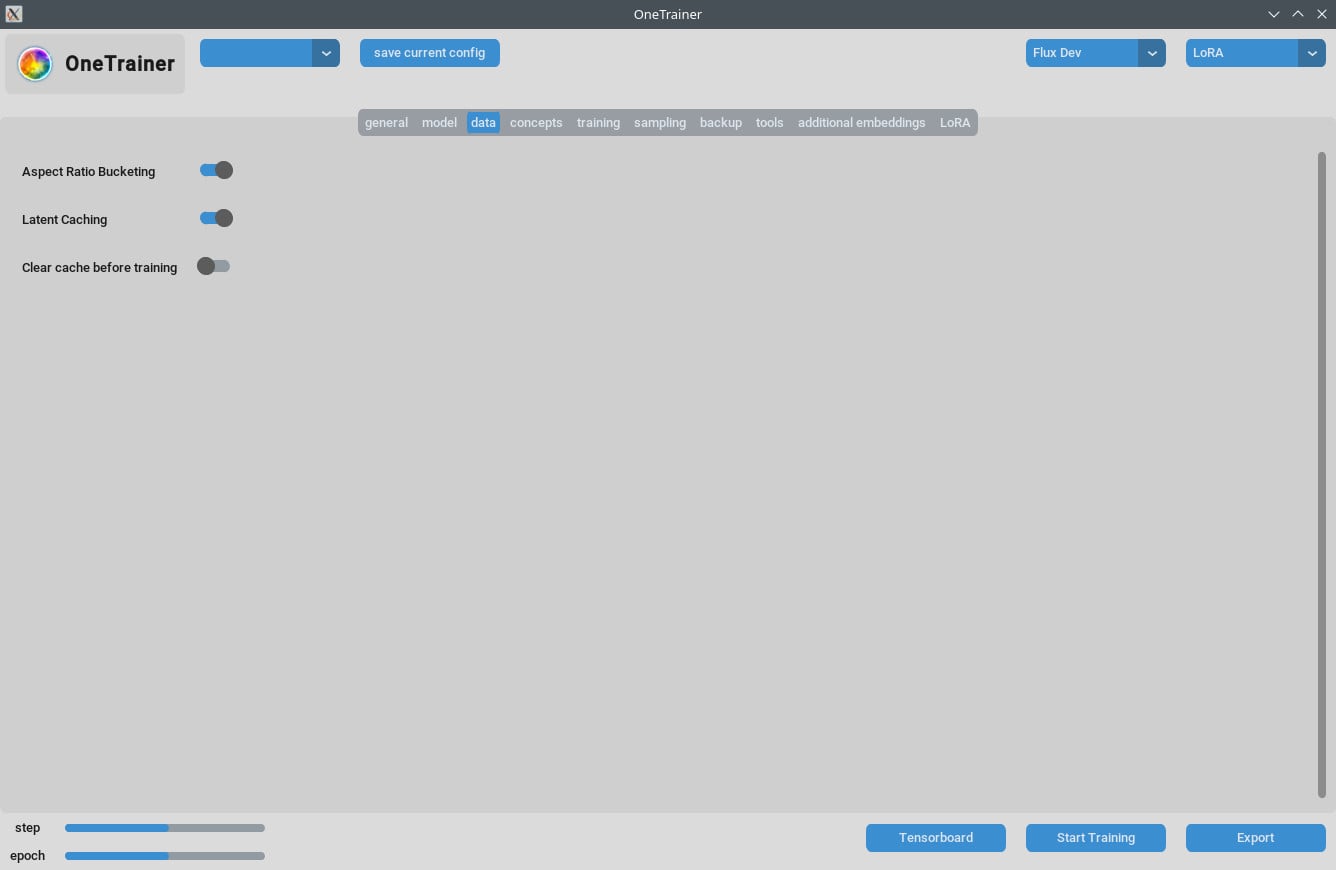

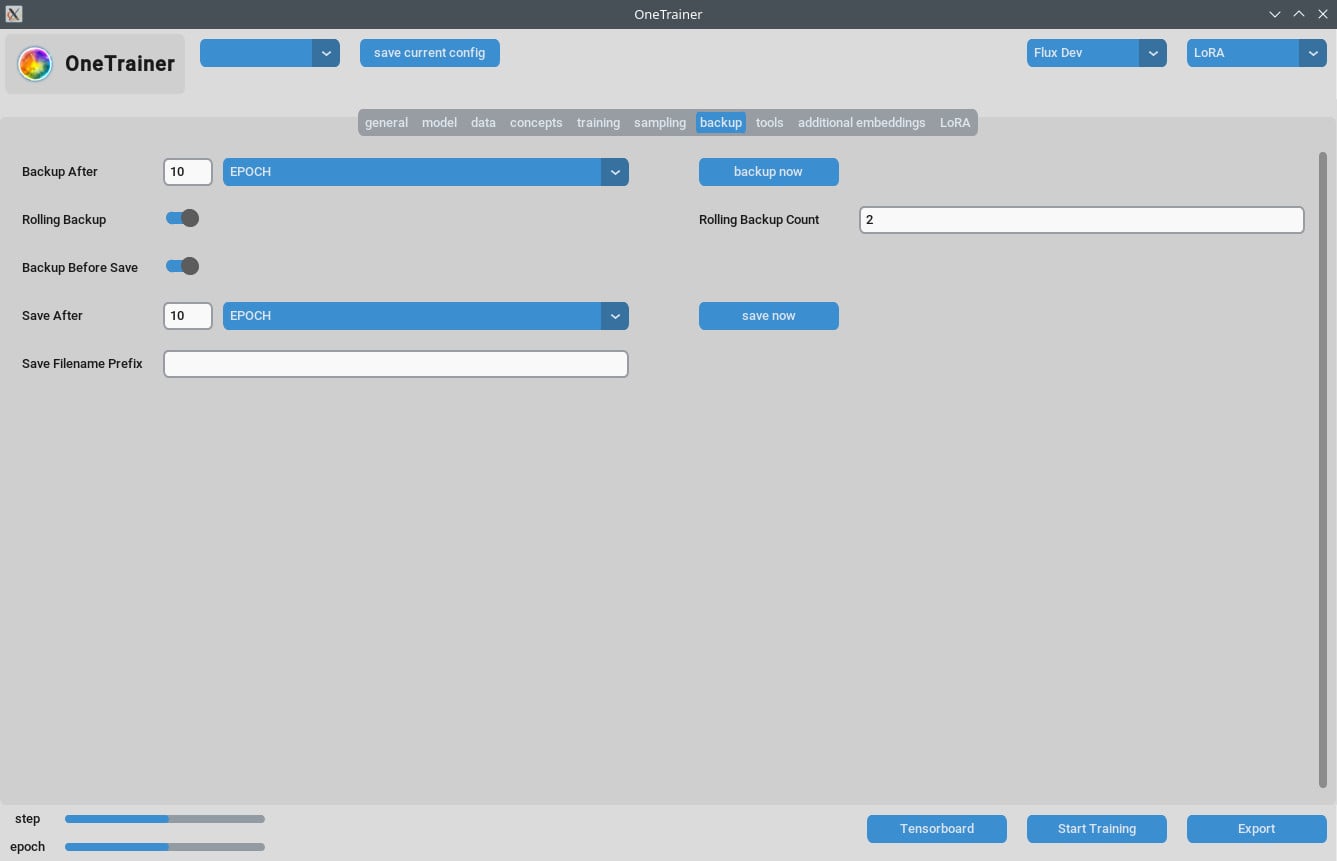

Captions en Gegevensbeheer

- Organiseer je trainingsgegevens zorgvuldig. Het aantal epochs hangt af van de complexiteit van jouw gegevens.

- Korte, precieze captions kunnen de trainings efficiëntie flink verbeteren.

Veelgestelde Vragen

Q1: Kan ik OneTrainer gebruiken voor andere modellen dan Flux.1?

Ja, OneTrainer ondersteunt SD 1.5, SDXL, en meer. De instellingen variëren per model.

Q2: Gebruikt OneTrainer automatisch de conceptnaam als een triggerwoord?

Ja, de conceptnaam kan als triggerwoord fungeren. Zorg dat het betekenisvol is voor jouw project.

Q3: Hoe kan ik VRAM effectief beheren tijdens de training?

Zet Gradient Checkpointing op CPU_OFFLOAD. Deze instelling helpt om het VRAM gebruik te verminderen zonder veel impact op de snelheid.

Q4: Wat is de impact van het gebruik van NF4 vs. full precision lagen?

NF4 vermindert het VRAM gebruik, maar kan de kwaliteit iets verminderen. Full precision lagen behouden de kwaliteit, maar vereisen meer VRAM.

Q5: Hoe kan ik de grootte van mijn LoRA-model verkleinen?

Je kunt Rank en Alpha waarden verlagen of het LoRA gewicht datatype instellen op bfloat16. Dit vermindert de grootte maar kan de kwaliteit beïnvloeden.

Q6: Kan OneTrainer multi-resolutie training aan?

Ja, OneTrainer ondersteunt multi-resolutie training. Volg de richtlijnen in de OneTrainer wiki om het in te stellen.

Q7: Mijn afbeeldingen verschijnen als roze statisch wanneer ik DoRA gebruik. Wat moet ik doen?

Controleer je aandacht laag instellingen. Vermijd "volledig" voor de aandacht lagen, dit kan het probleem veroorzaken.

Q8: Hoe ga ik om met meerdere onderwerpen in OneTrainer?

Gebruik gebalanceerde training door verschillende herhalingswaarden voor verschillende onderwerpen in te stellen. Organiseer de gegevens zorgvuldig zodat beide onderwerpen gelijkmatig worden getraind.

Q9: Is er een equivalent voor 'split mode' in OneTrainer?

OneTrainer heeft geen 'split mode'. Gebruik in plaats daarvan instellingen zoals CPU_OFFLOAD voor Gradient Checkpointing om VRAM effectiever te beheren.

Q10: Kunnen de OneTrainer instellingen worden aangepast voor betere kwaliteit bij hoger VRAM gebruik?

Ja, verhoog de resolutie en pas datatype- en gradient checkpointing-instellingen aan om de kwaliteit te verbeteren.

Deze gids moet alle benodigde stappen, instellingen en probleemoplossing tips bieden voor het effectief gebruiken van OneTrainer met Flux AI modellen. Veel succes met trainen!