- pub

Impostazioni e Consigli Ottimizzati per OneTrainer: Allenamento di Flux.1 LoRA e DoRA (20% Più Veloce)

Prepararsi per l’Allenamento

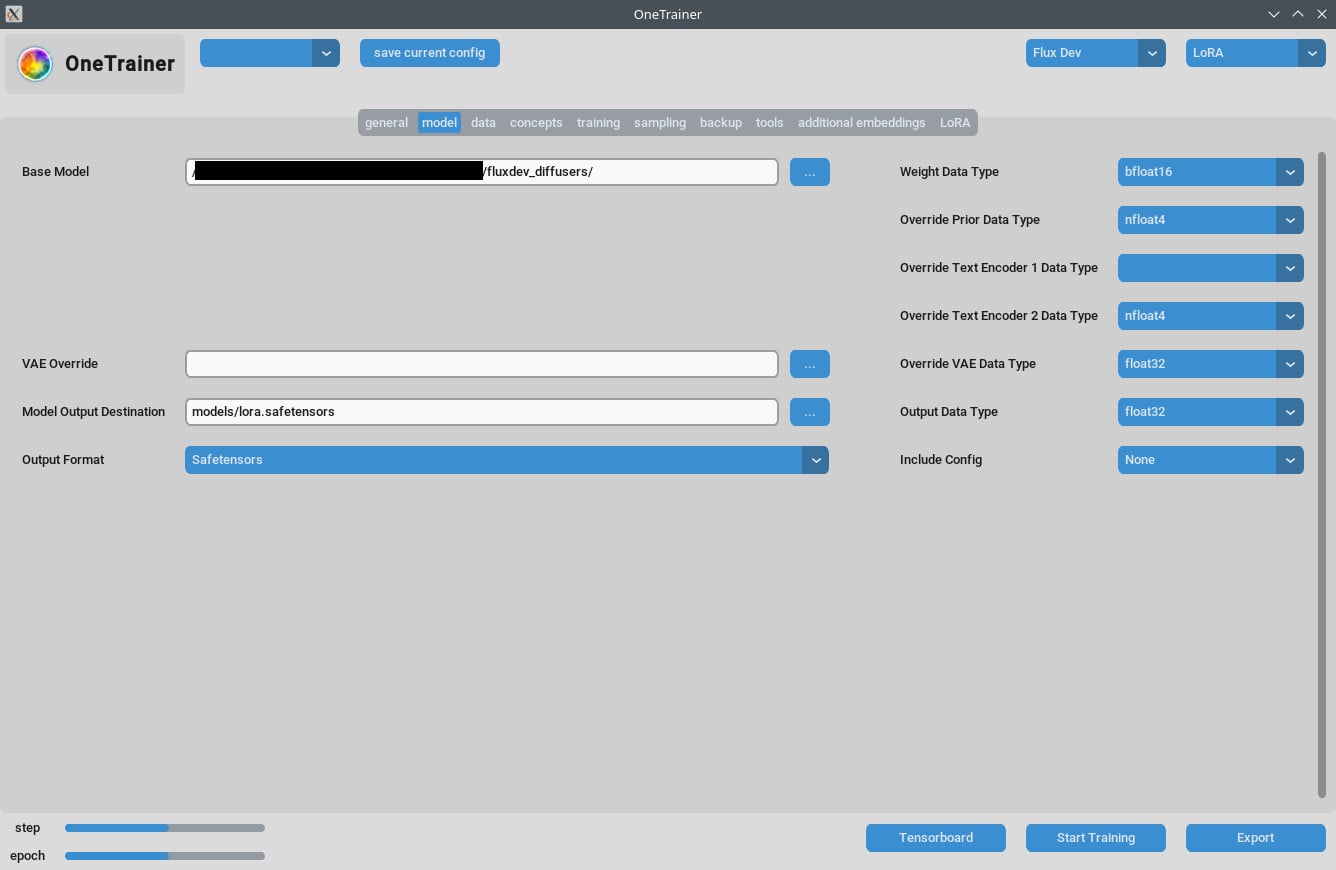

Scegliere il Modello

Prima di tutto, assicurati di aver selezionato il modello giusto Flux AI. OneTrainer supporta vari modelli, come Flux.1 dev, pro e schnell. Controlla che il modello sia adatto al tuo progetto.

- Acquisire il Modello: Scarica il modello desiderato dalle fonti ufficiali, come Hugging Face.

- Caricare il Modello: In OneTrainer, vai alle impostazioni del modello e carica i file del modello.

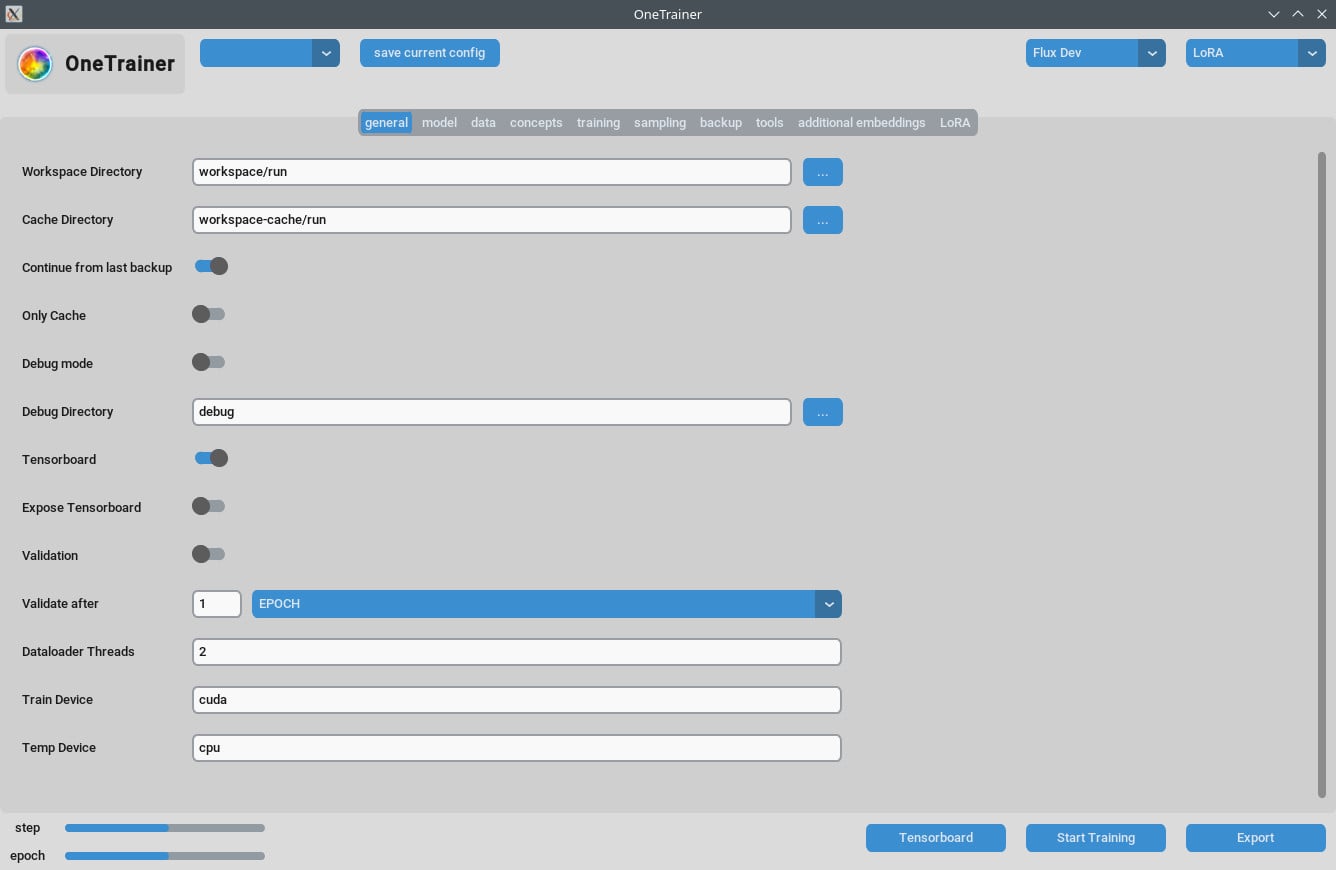

Impostare l’Ambiente

Requisiti Hardware:

- GPU: Si consiglia almeno una 3060. Se hai una 4090, avrai prestazioni migliori.

- VRAM: Almeno 12 GB per gestire risoluzioni più alte.

- RAM: Ti serviranno almeno 10 GB di RAM, ma meglio avere di più.

Requisiti Software:

- Sistema Operativo: Testato sia su Windows che su Linux.

- Dipendenze: Controlla che tutte le dipendenze siano installate. Dai un'occhiata alla documentazione di OneTrainer per la lista delle librerie e strumenti necessari.

Impostazioni e Configurazioni Dettagliate

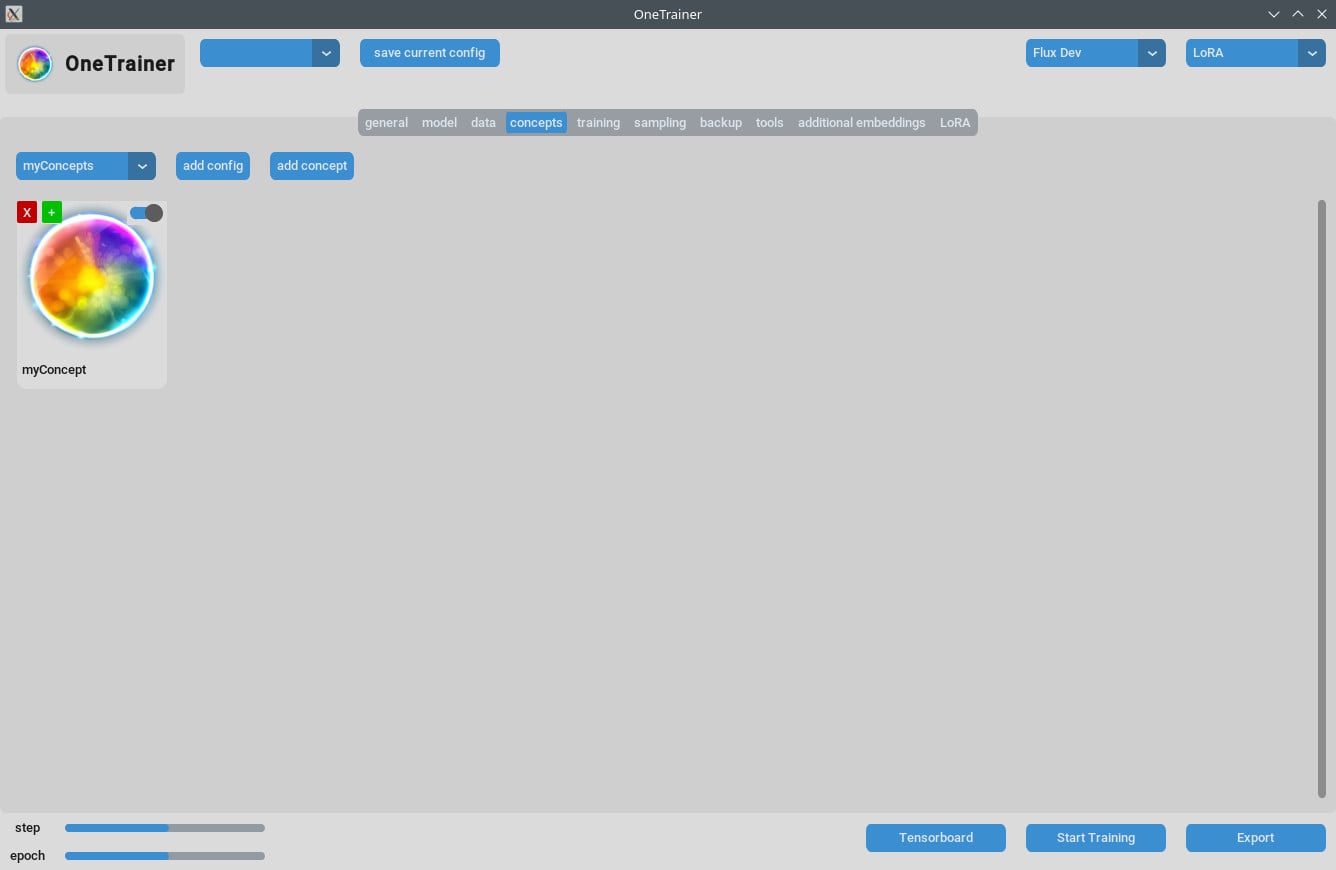

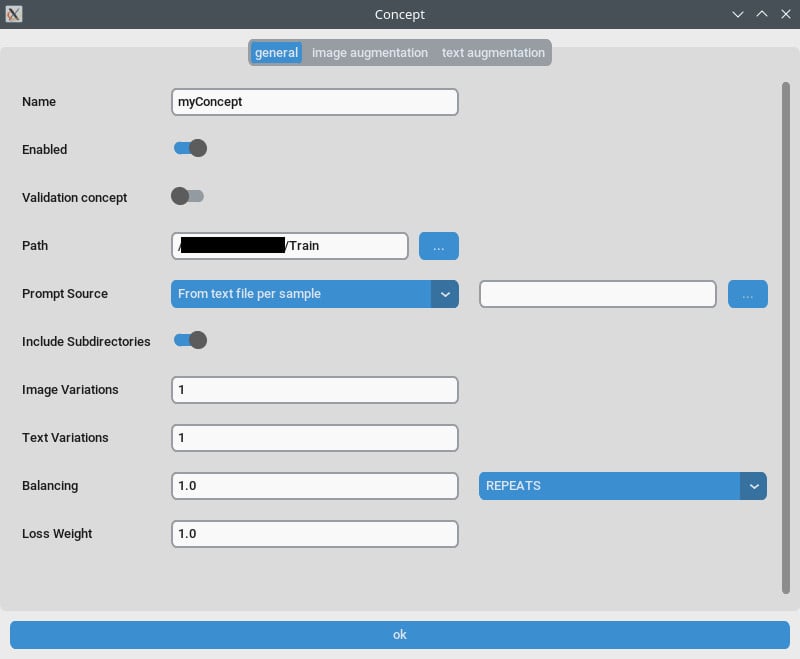

Scheda Concetto / Impostazioni Generali

- Ripetizioni: Imposta

Ripetizionia 1. Gestisci il numero di ripetizioni attraverso ilNumero di Epochsnella scheda di allenamento. - Fonte del Prompt: Usa "da un singolo file di testo" se vuoi una "parola trigger" invece di didascalie singole per ogni immagine. Indica questa impostazione a un file di testo contenente la tua parola/ frase trigger.

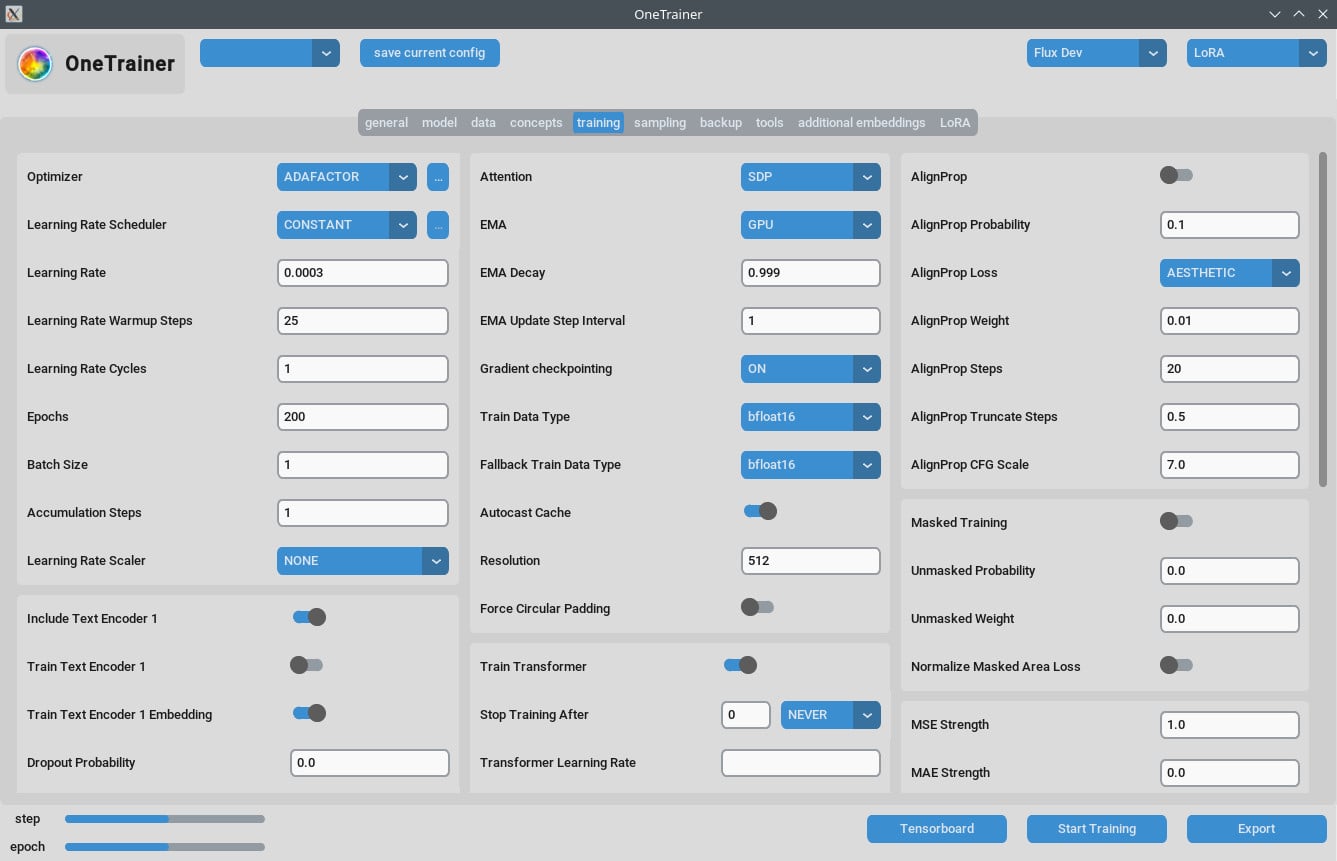

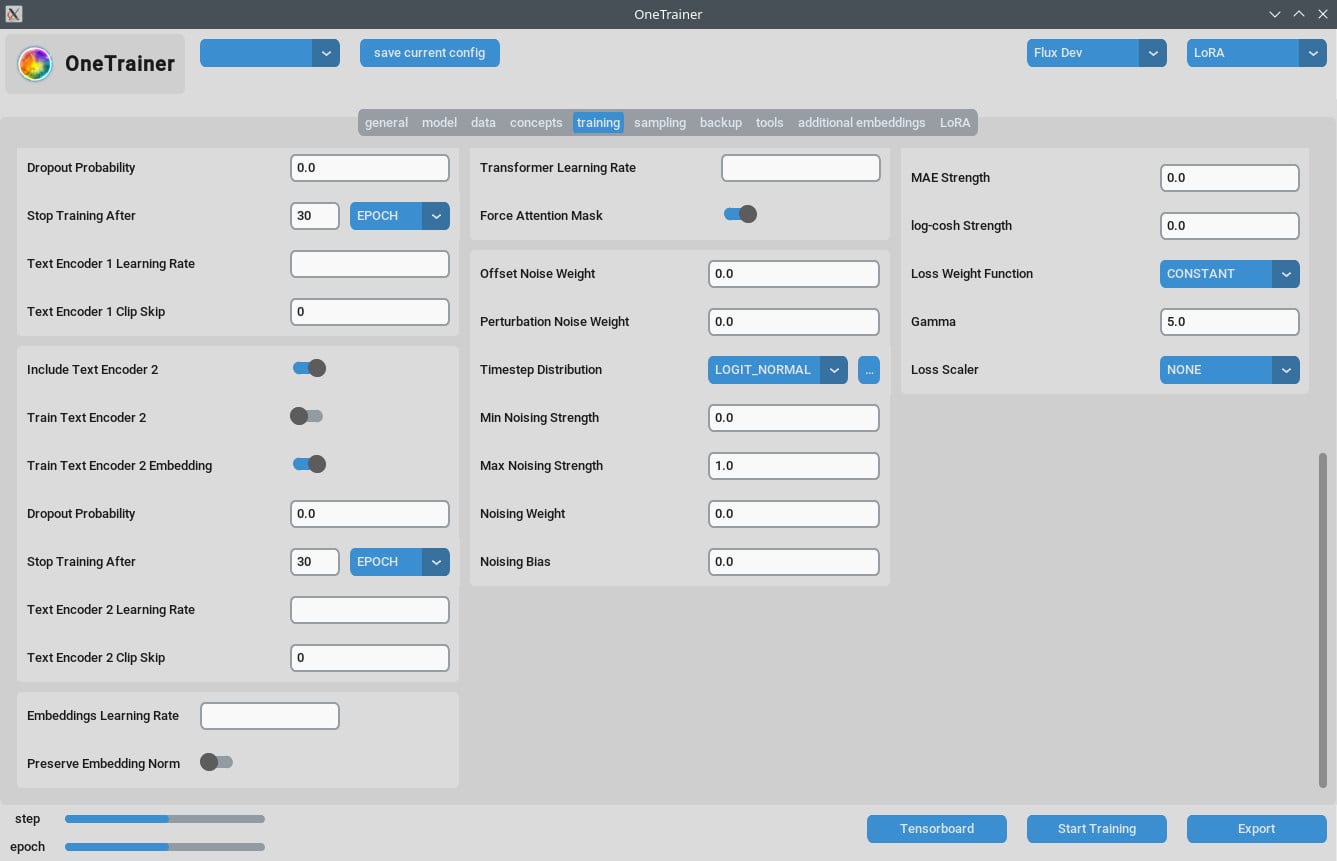

Scheda Allenamento

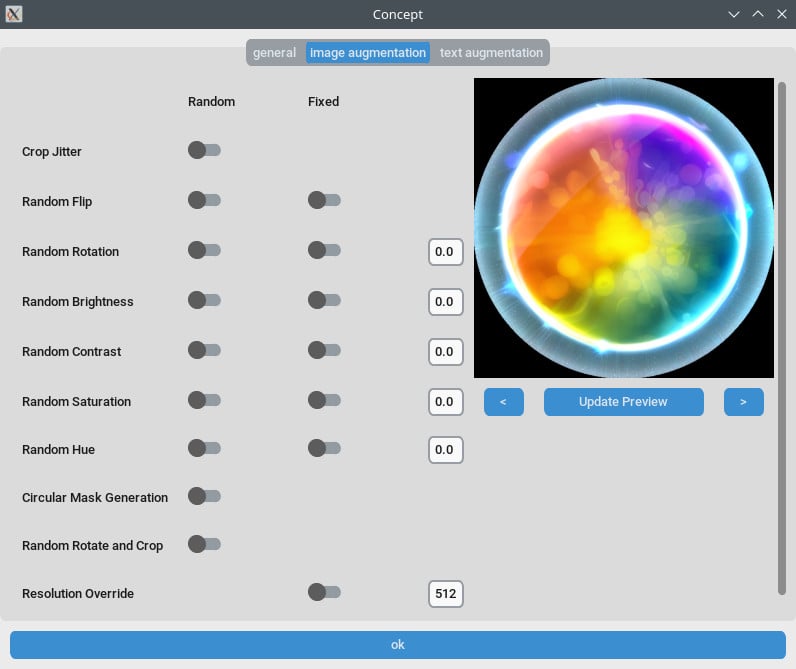

Impostazioni di Risoluzione

- Per Migliore Qualità:

- Imposta

Risoluzionea 768 o 1024 per uscite di alta qualità.

- Imposta

- Impostazioni EMA:

- EMA: Usalo durante gli allenamenti SDXL.

- EMA GPU: Per risparmiare VRAM, imposta EMA da "GPU" a "OFF."

- Tasso di Apprendimento:

- Un buon punto di partenza può essere 0.0003 o 0.0004. Regola in base alle tue necessità specifiche.

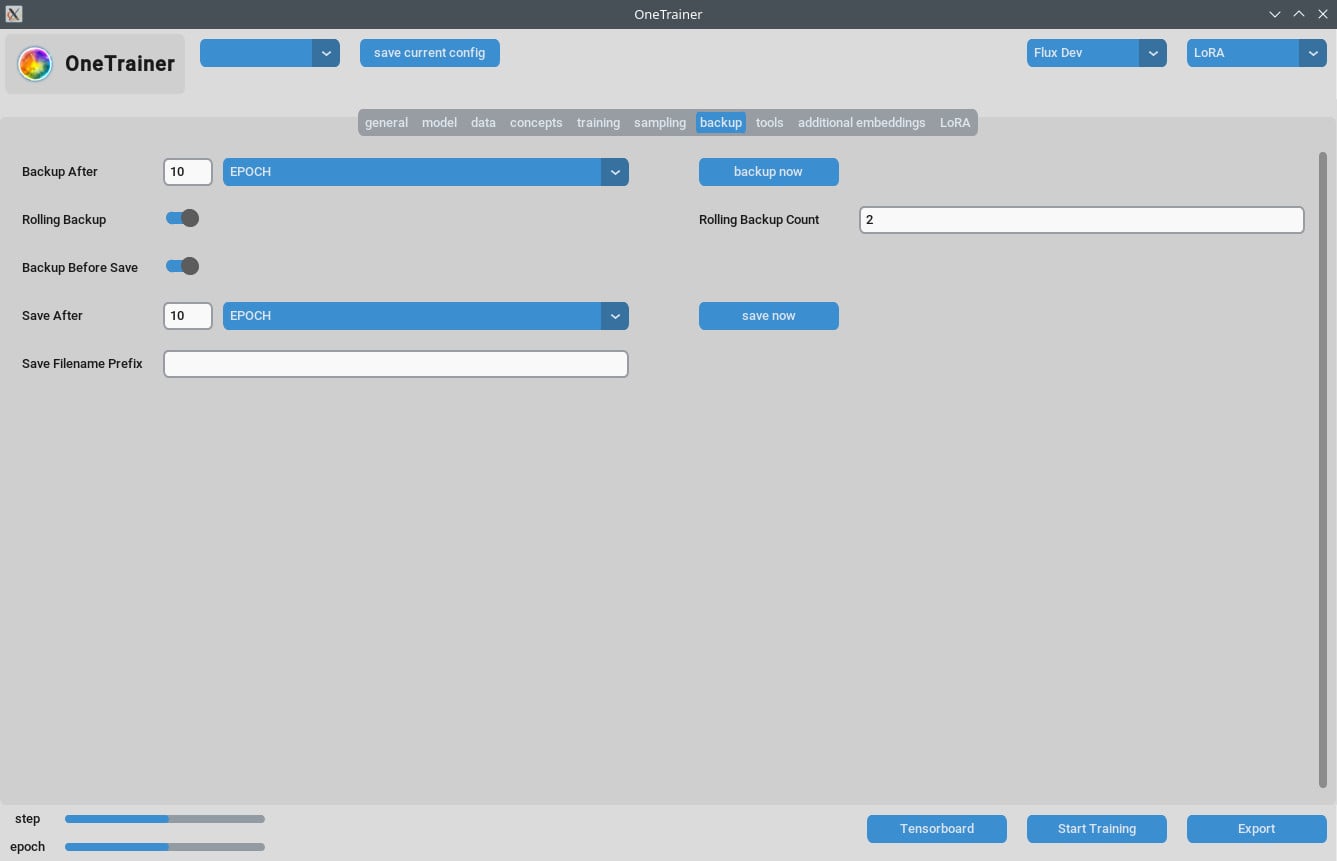

- Numero di Epochs:

- In genere, 40 epochs danno buoni risultati. Aggiusta in base alla complessità del tuo dataset.

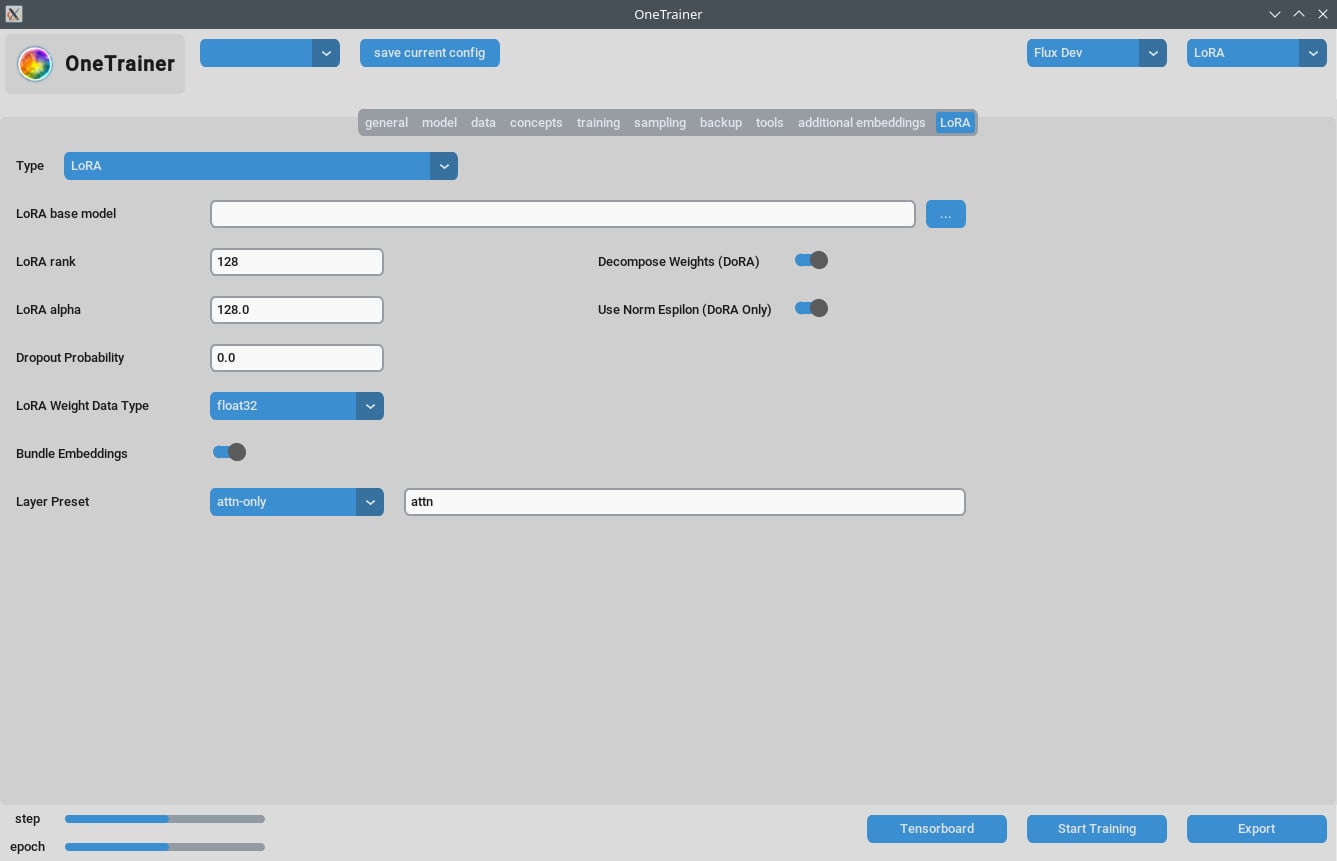

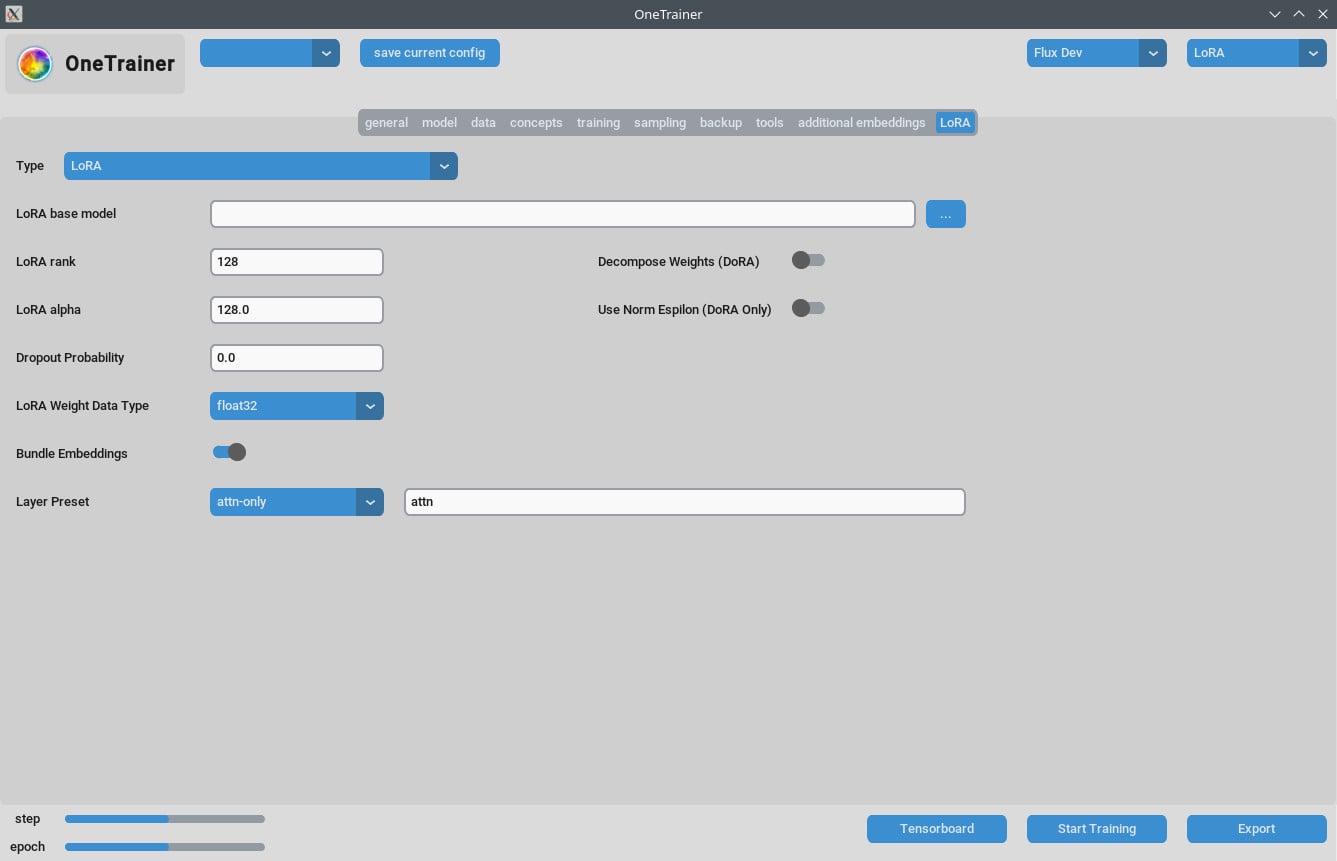

Scheda LoRA

- Rank e Alpha:

- Tieni questi valori uguali (es. 64/64, 32/32) o regola il tuo tasso di apprendimento di conseguenza.

- Modelli LoRA Risultanti:

- Assicurati che gli aggiornamenti siano applicati se stai usando versioni recenti di ComfyUI.

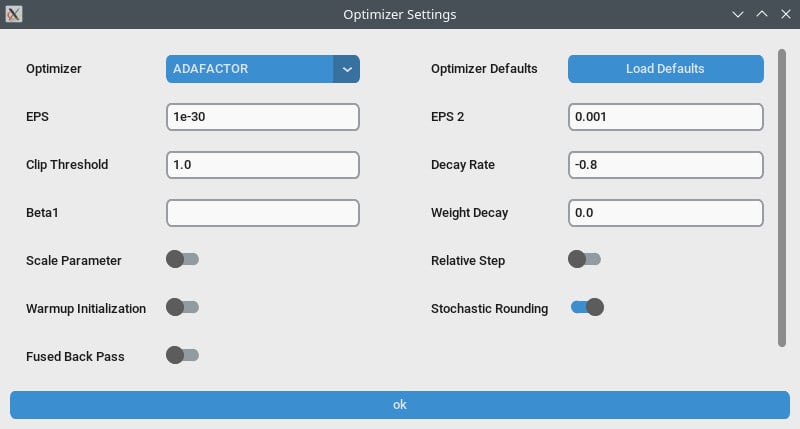

Ottimizzazione delle Prestazioni

- Gradient Checkpointing:

- Prova a disattivarlo se noti rallentamenti, soprattutto se il tuo hardware supporta VRAM più alta.

- bf16 vs nfloat4:

- Nella scheda "modello", cambia

Override Prior Data Typea bf16 per aumentare la qualità. Questa impostazione influisce su VRAM e velocità.

- Nella scheda "modello", cambia

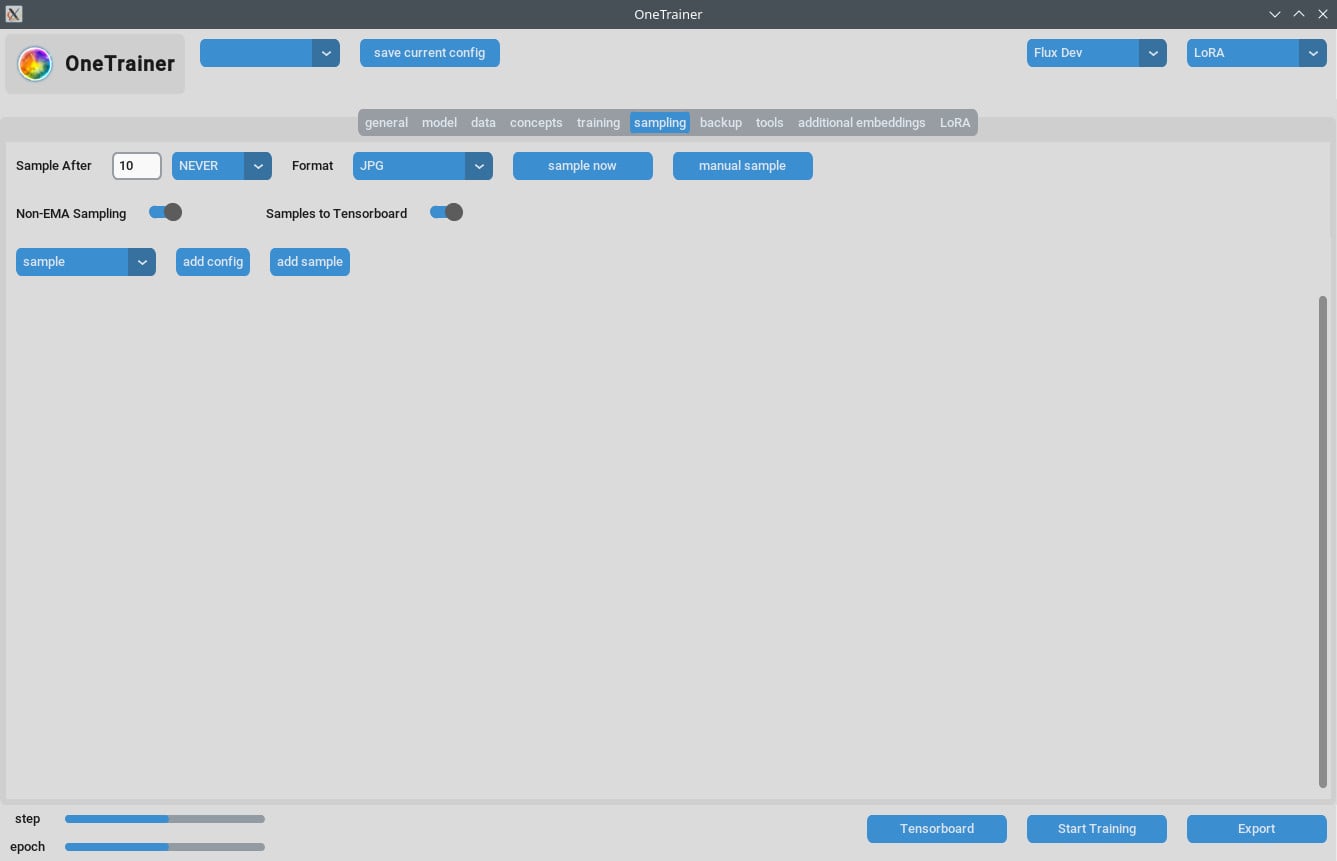

Gestire Problemi di Campionamento

- Alcuni utenti hanno avuto errori di Out Of Memory (OOM) durante il campionamento. Assicurati che la tua GPU abbia sufficiente VRAM.

- Aggiorna regolarmente OneTrainer per includere correzioni e patch che risolvono tali problemi.

Suggerimenti per Allenamento Multi-Concezione

Limitazioni Attuali

- Allenare più persone con parole trigger diverse nella stessa sessione spesso non funziona.

- Oggetti o situazioni differenti (es. scarpe da allenamento e auto specifiche) danno risultati migliori.

Best Practices

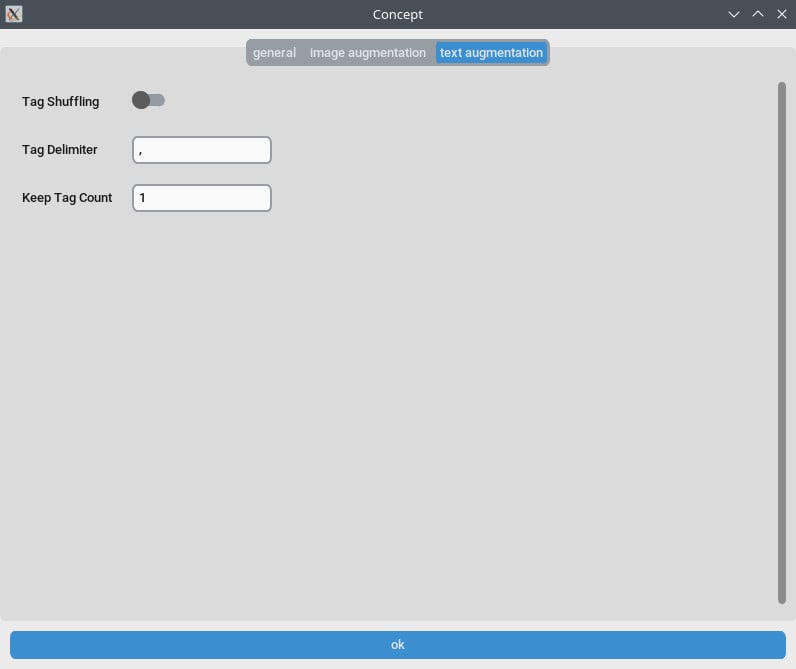

- Didascalie Brevi:

- Usa didascalie brevi e in linguaggio naturale. Tendono a funzionare bene in poche centinaia di step.

- Stacking LoRAs:

- Combinare un concetto e un LoRA di personaggio dà risultati migliori rispetto all'allenamento combinato.

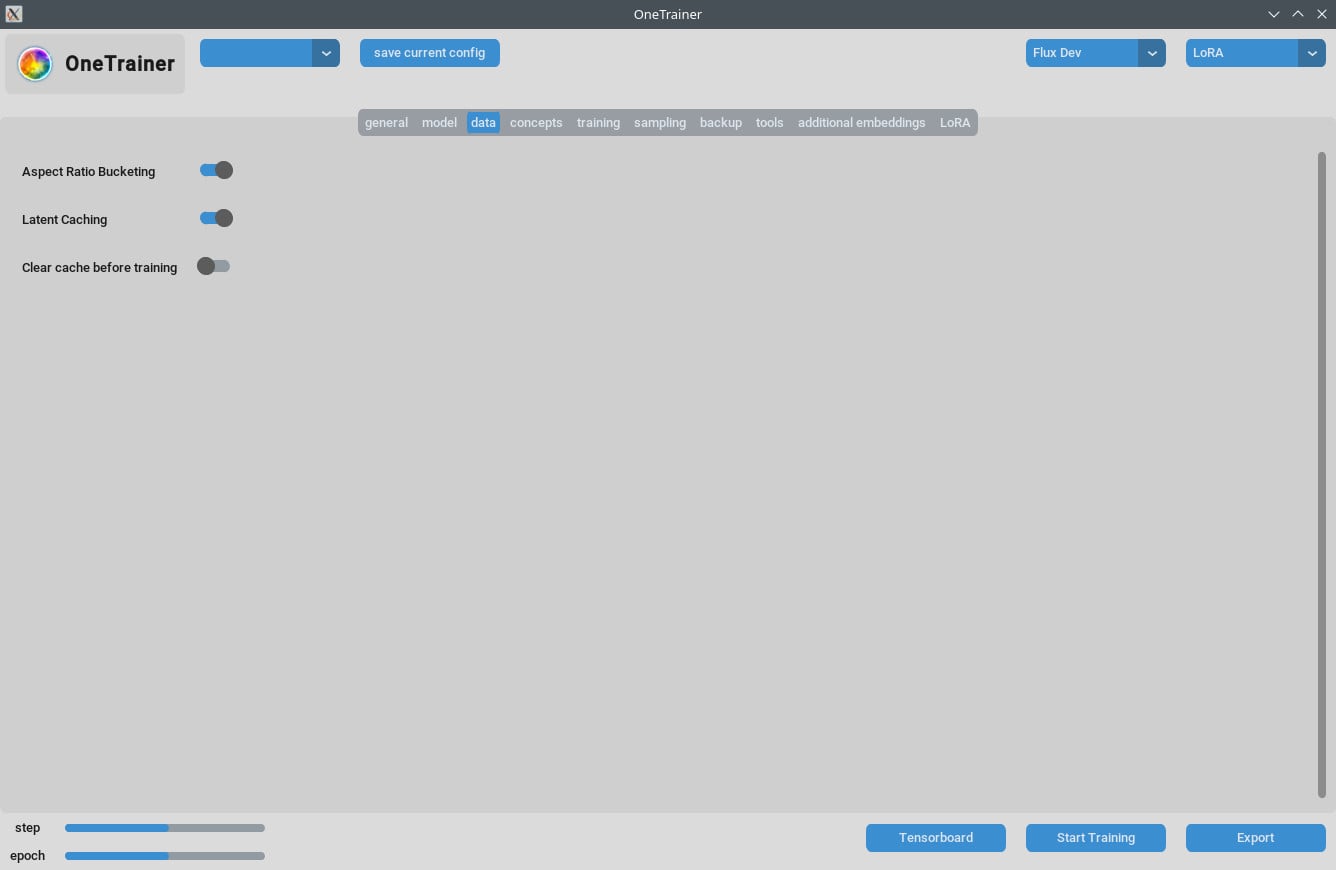

Didascalie e Gestione Dati

- Organizza i tuoi dati di allenamento con attenzione. Il numero di epochs dipende dalla complessità dei tuoi dati.

- Didascalie brevi e precise possono migliorare significativamente l'efficienza dell'allenamento.

Domande Frequenti

D1: Posso usare OneTrainer per modelli diversi da Flux.1?

Sì, OneTrainer supporta SD 1.5, SDXL e altro. Le impostazioni varieranno in base al modello.

D2: OneTrainer usa automaticamente il nome del concetto come parola trigger?

Sì, il nome del concetto può agire come parola trigger. Assicurati che sia significativo per il tuo progetto.

D3: Come posso gestire bene la VRAM durante l'allenamento?

Imposta Gradient Checkpointing su CPU_OFFLOAD. Questa impostazione aiuta a ridurre l'uso della VRAM senza impattare troppo sulla velocità.

D4: Qual è l'impatto dell'uso di NF4 rispetto a strati a precisione completa?

NF4 riduce l'uso della VRAM ma potrebbe diminuire leggermente la qualità. Gli strati a precisione completa mantengono la qualità ma richiedono più VRAM.

D5: Come posso ridurre la dimensione del mio modello LoRA?

Puoi ridurre i valori di Rank e Alpha oppure impostare il tipo di dati del peso LoRA su bfloat16. Questo riduce la dimensione ma potrebbe influenzare la qualità.

D6: OneTrainer può gestire l'allenamento multi-risoluzione?

Sì, OneTrainer supporta l'allenamento multi-risoluzione. Segui le linee guida nel wiki di OneTrainer per configurarlo.

D7: Le mie immagini appaiono come statiche rosa quando uso DoRA. Cosa devo fare?

Controlla le impostazioni del tuo livello di attenzione. Evita di usare "completo" per i livelli di attenzione, potrebbe essere quella la causa del problema.

D8: Come gestisco più soggetti in OneTrainer?

Usa allenamenti bilanciati impostando valori di ripetizione diversi per soggetti diversi. Organizza bene i dati per garantire allenamenti equi per entrambi i soggetti.

D9: Esiste una modalità equivalente al 'split mode' in OneTrainer?

OneTrainer non ha una 'modalità di divisione'. Piuttosto, usa impostazioni come CPU_OFFLOAD per Gradient Checkpointing per gestire la VRAM in modo più efficace.

D10: Posso regolare le impostazioni di OneTrainer per una qualità migliore con un uso più elevato della VRAM?

Sì, aumenta la risoluzione e regola i tipi di dati e le impostazioni di checkpointing per migliorare la qualità.

Questa guida dovrebbe darti tutti i passaggi necessari, impostazioni e suggerimenti per risolvere i problemi per usare OneTrainer in modo efficace con i modelli Flux AI. Buon allenamento!