- pub

Configurações e Dicas Otimizadas do OneTrainer para Treinamento de Flux.1 LoRA e DoRA (20% Mais Rápido)

Preparando-se para o Treinamento

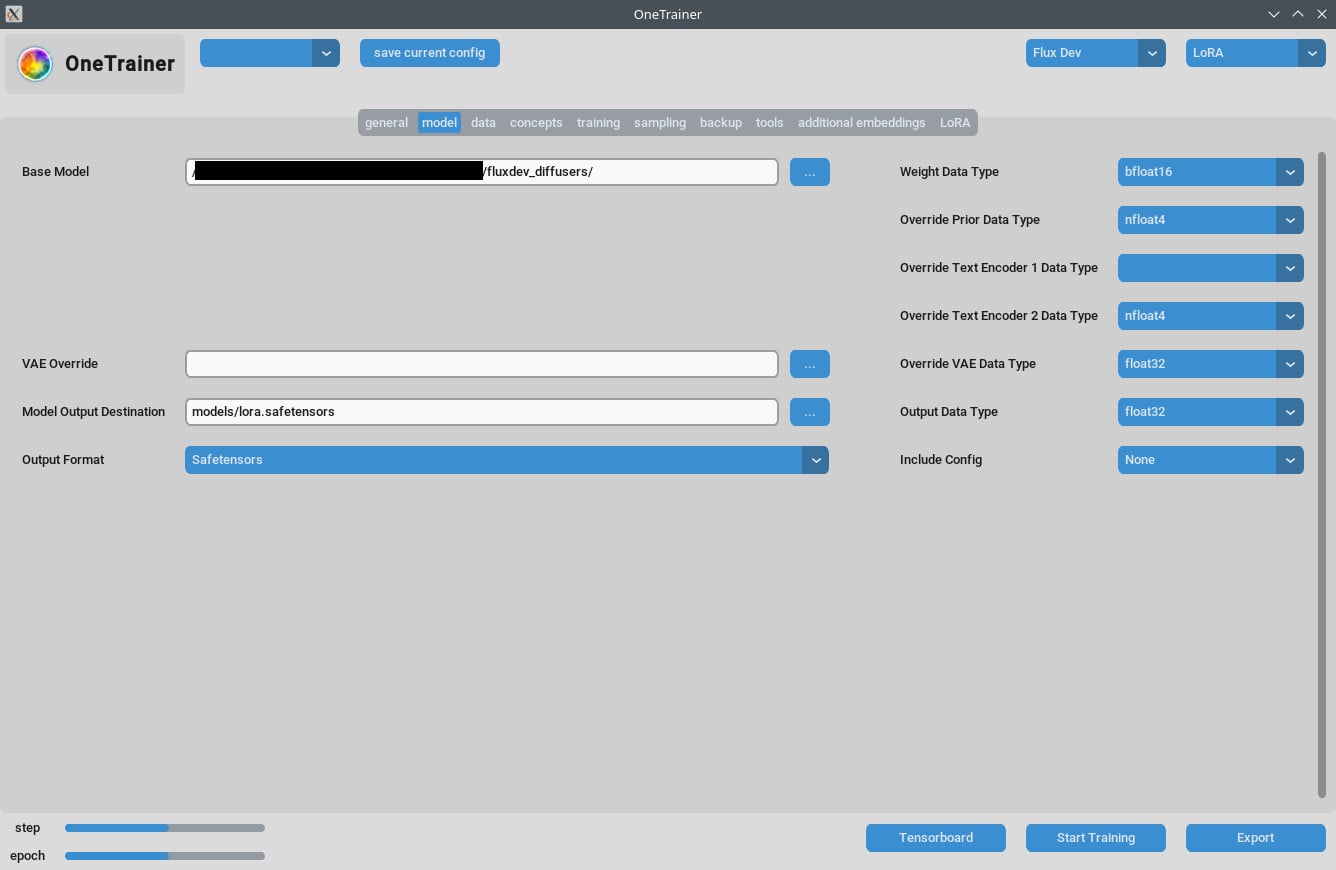

Selecionando o Modelo

Primeiro, garanta que você selecionou o modelo correto, Flux AI. O OneTrainer suporta vários modelos, incluindo Flux.1 dev, pro e schnell. Certifique-se de usar um modelo que se encaixe no seu projeto.

- Adquira o Modelo: Baixe o modelo desejado das fontes oficiais, como o Hugging Face.

- Carregue o Modelo: No OneTrainer, vá nas configurações do modelo e carregue os arquivos do modelo.

Configurando o Ambiente

Requisitos de Hardware:

- GPU: É recomendado ter pelo menos uma 3060. Uma 4090 vai te dar um desempenho melhor.

- VRAM: Pelo menos 12 GB pra lidar com resoluções mais altas.

- RAM: O ideal é ter no mínimo 10 GB de RAM, quanto mais, melhor.

Requisitos de Software:

- Sistema Operacional: Testado tanto em Windows quanto em Linux.

- Dependências: Garanta que todas as dependências estão instaladas. Confira a documentação do OneTrainer pra ver a lista de bibliotecas e ferramentas necessárias.

Configurações e Detalhes

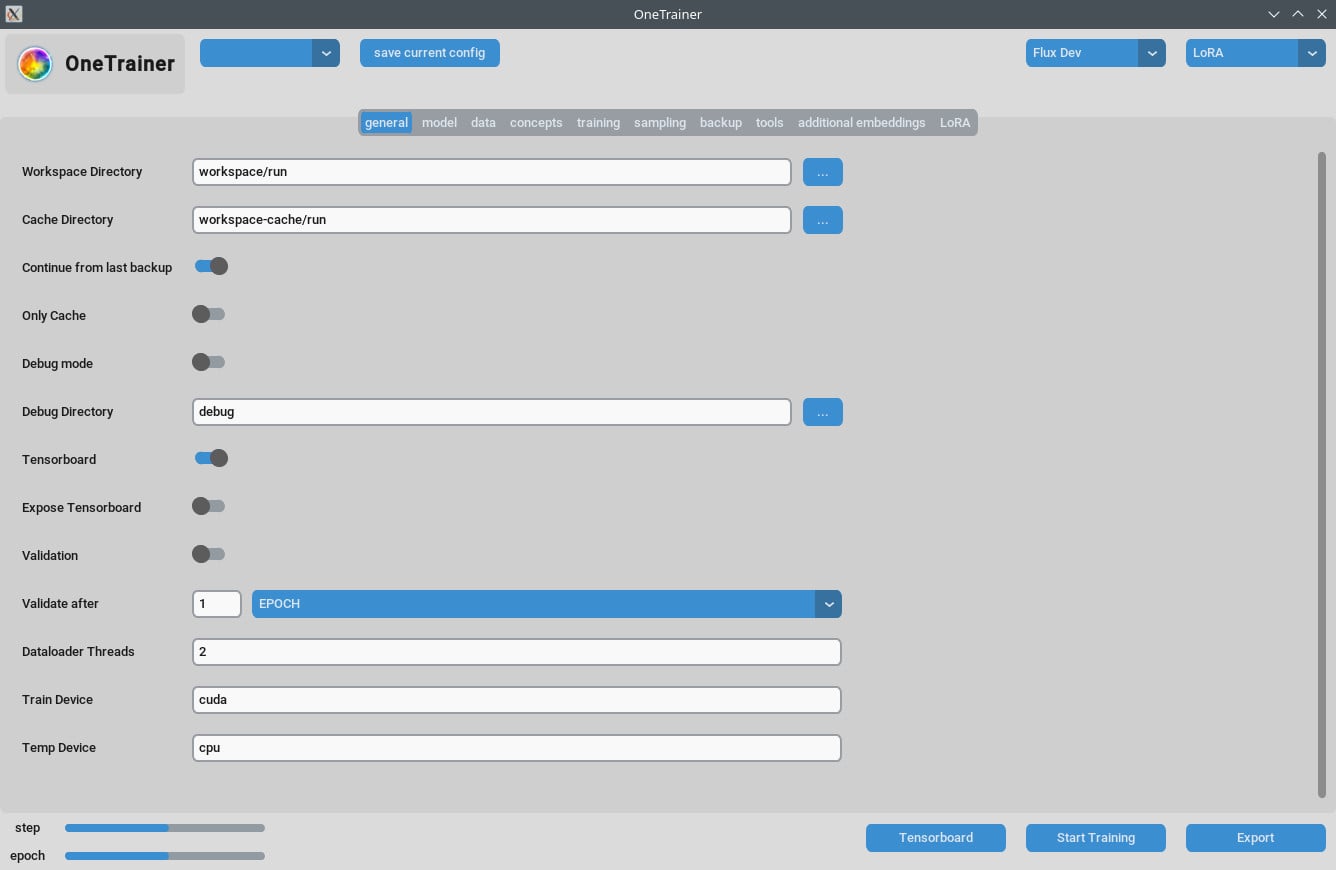

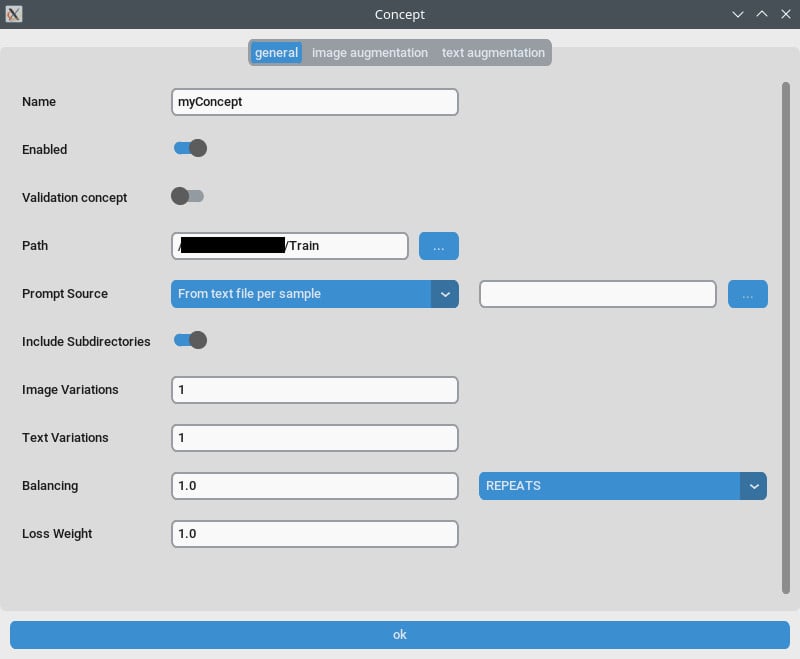

Aba Conceito/Configurações Gerais

- Repetições: Defina

Repetitionspara 1. Gerencie o número de repetições pelaNumber of Epochsna aba de treinamento. - Fonte do Prompt: Use "from single text file" se quiser uma "palavra-chave" ao invés de legendas individuais por imagem. Aponte essa configuração pra um arquivo de texto com sua palavra/frase-chave.

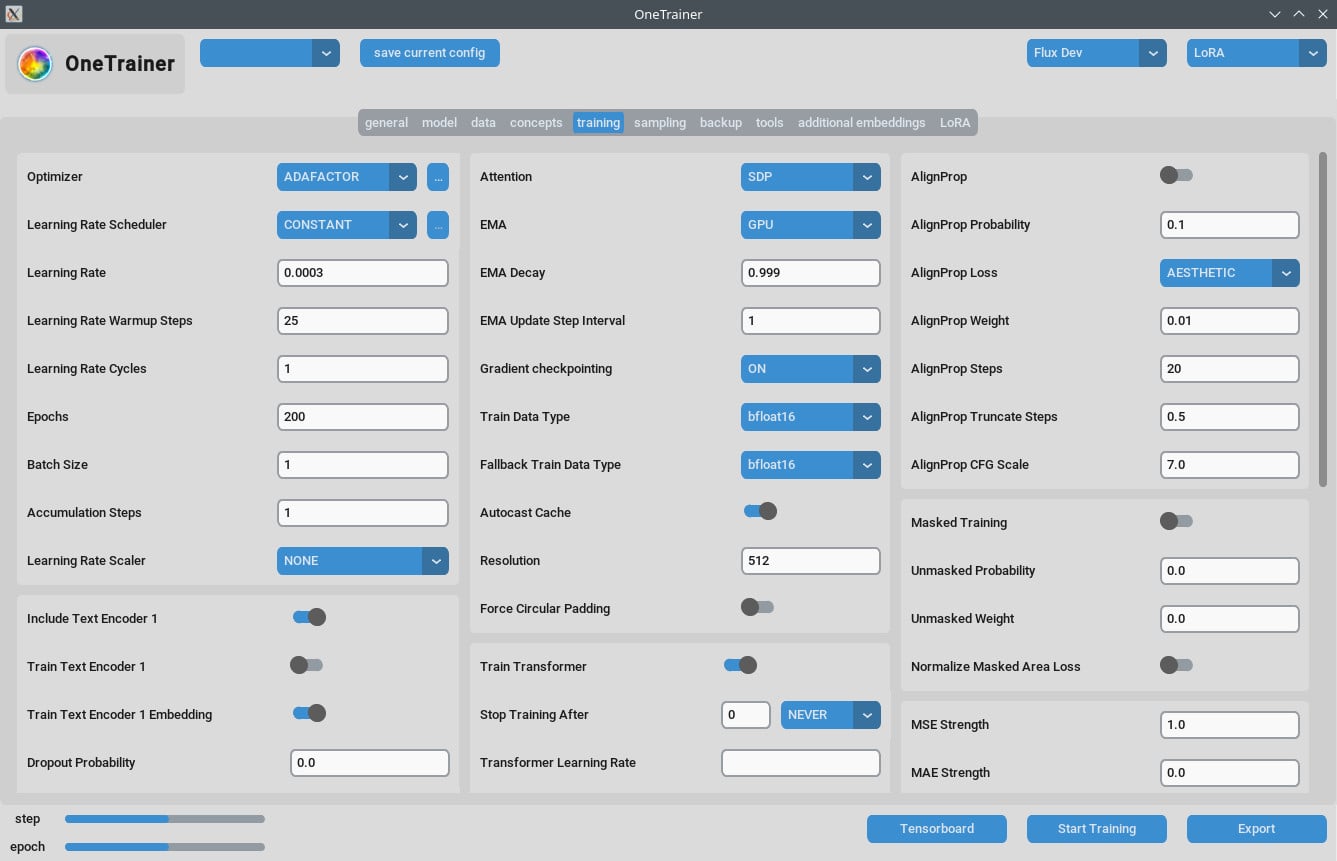

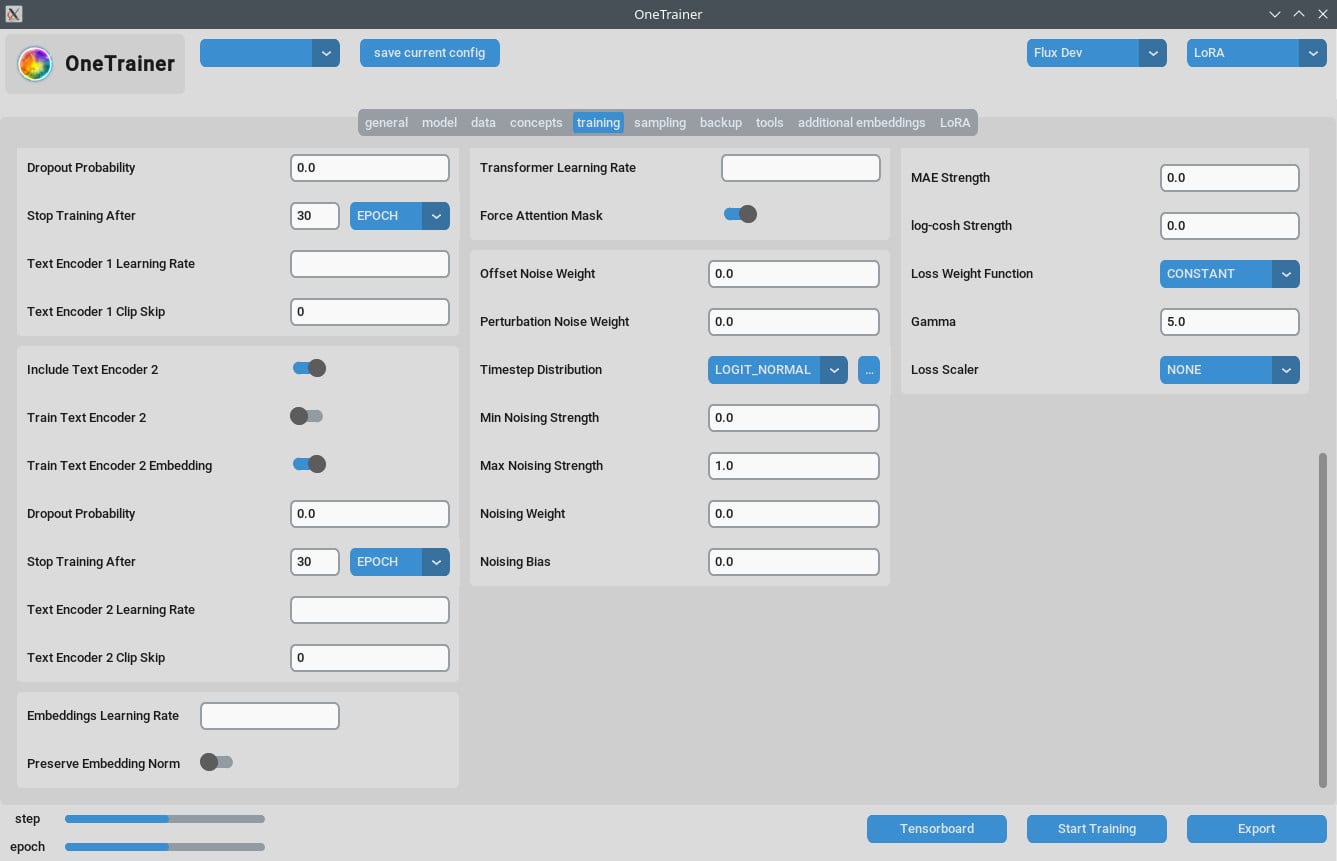

Aba de Treinamento

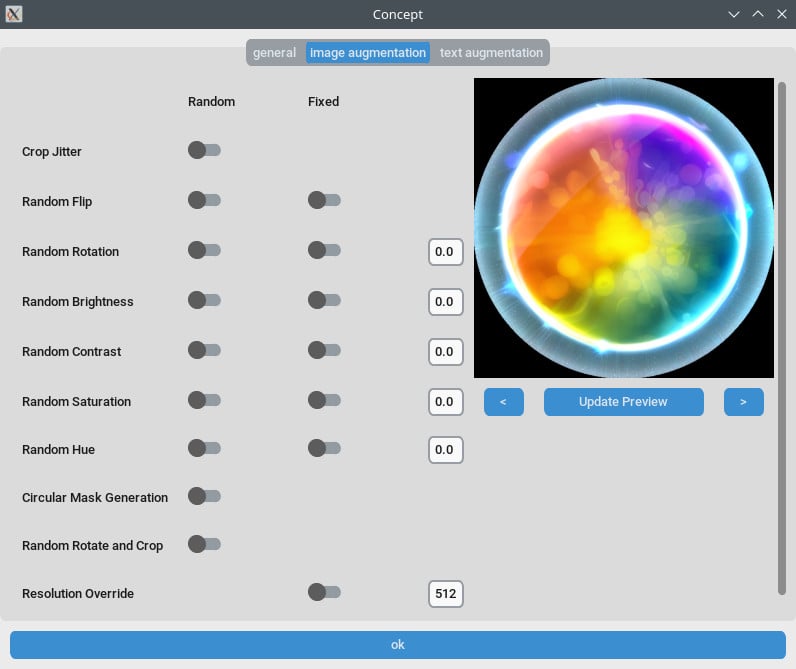

Configurações de Resolução

- Pra Melhor Qualidade:

- Defina

Resoluçãopara 768 ou 1024 pra saídas de qualidade superior.

- Defina

- Configurações de EMA:

- EMA: Use durante os treinos de SDXL.

- EMA GPU: Pra economizar VRAM, mude EMA de "GPU" para "OFF."

- Taxa de Aprendizado:

- Um bom ponto de partida pode ser 0.0003 ou 0.0004. Ajuste conforme suas necessidades.

- Número de Épocas:

- Normalmente, 40 épocas mostram bons resultados. Ajuste de acordo com a complexidade do seu conjunto de dados.

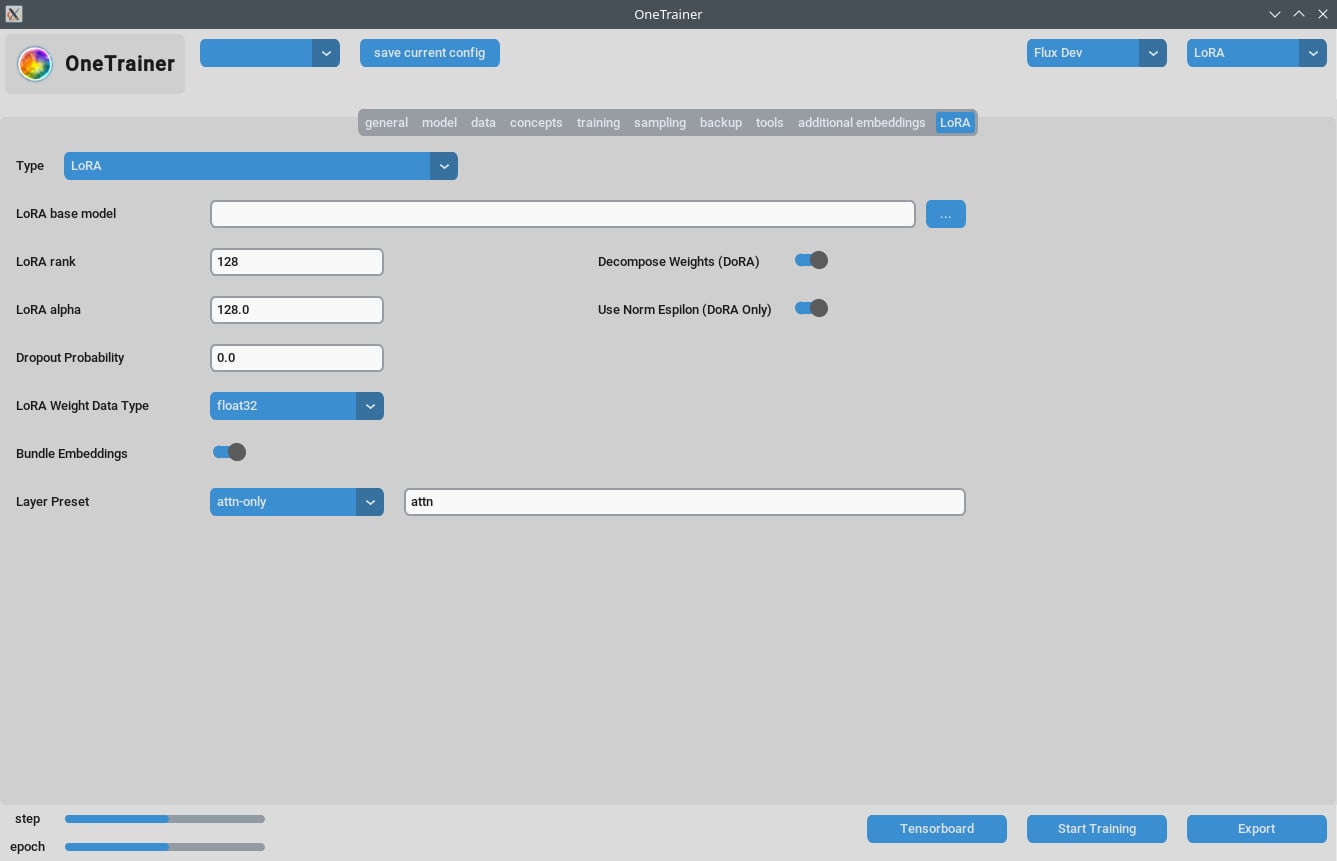

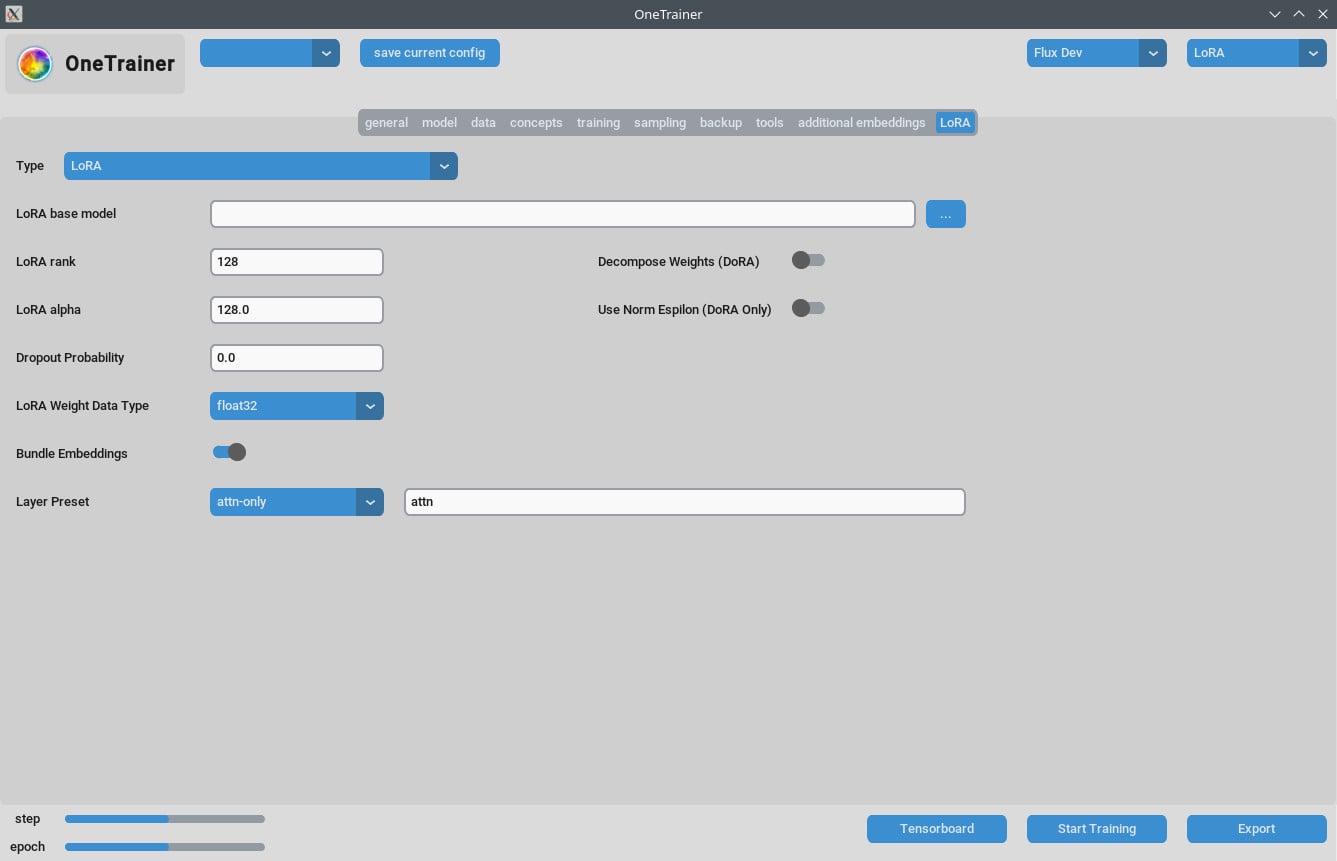

Aba LoRA

- Rank e Alpha:

- Mantenha esses valores iguais (ex: 64/64, 32/32) ou ajuste sua taxa de aprendizado de acordo.

- Modelos Resultantes de LoRA:

- Garanta que as atualizações sejam aplicadas se você estiver usando nas versões recentes do ComfyUI.

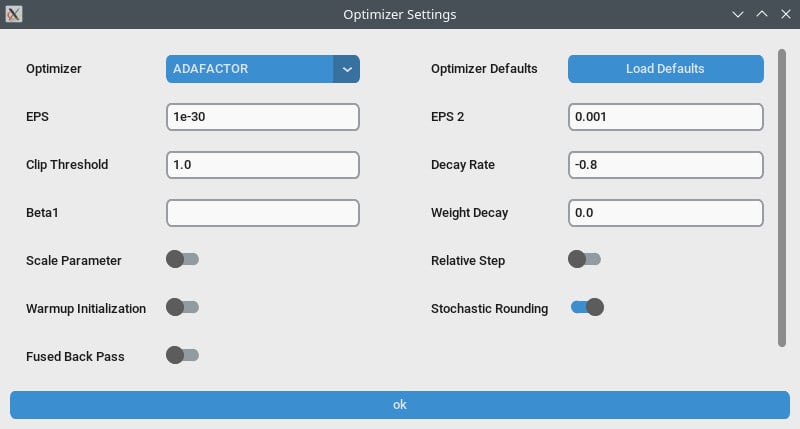

Otimização de Performance

- Checkpointing de Gradiente:

- Experimente desativar isso se você estiver enfrentando lentidão, especialmente se seu hardware suporta VRAM alta.

- bf16 vs nfloat4:

- Na aba "model", mude

Override Prior Data Typepara bf16 pra potencialmente aumentar a qualidade. Essa configuração impacta VRAM e velocidade.

- Na aba "model", mude

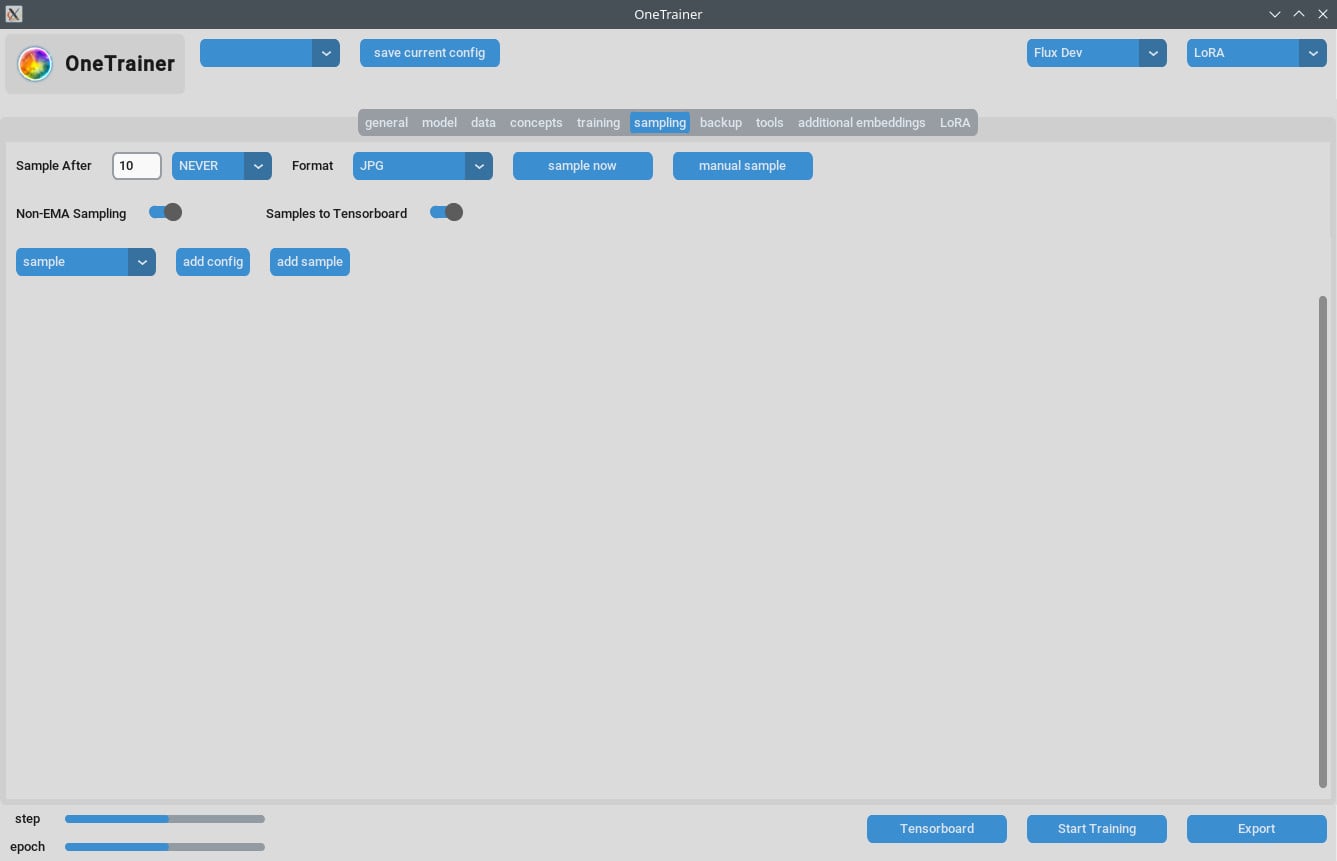

Lidando com Problemas de Amostragem

- Alguns usuários tiveram erros de Out Of Memory (OOM) durante a amostragem. Verifique se sua GPU tem VRAM suficiente.

- Atualize regularmente o OneTrainer pra incluir correções de bugs e patches que tratam desses problemas.

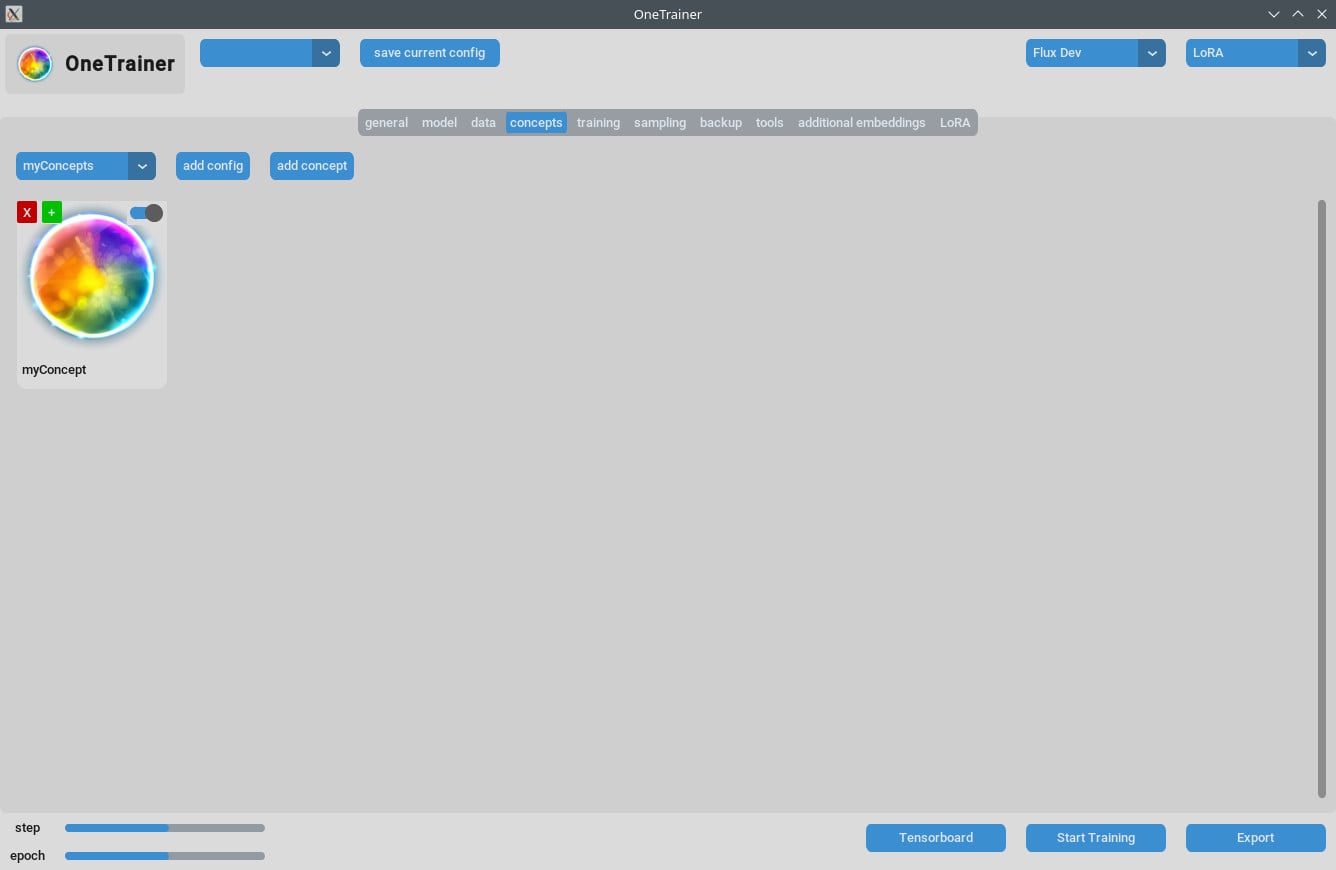

Dicas para Treinamento de Múltiplos Conceitos

Limitações Atuais

- Treinar várias pessoas com palavras-chave diferentes na mesma sessão frequentemente falha.

- Objetos ou situações diferentes (ex: tênis de treino e carros específicos) funcionam melhor.

Melhores Práticas

- Legendas Curtas:

- Use legendas curtas, com uma linguagem natural. Essas costumam funcionar bem em apenas algumas centenas de passos.

- Empilhando LoRAs:

- Empilhar um conceito e um LoRA de personagem traz melhores resultados do que o treinamento combinado.

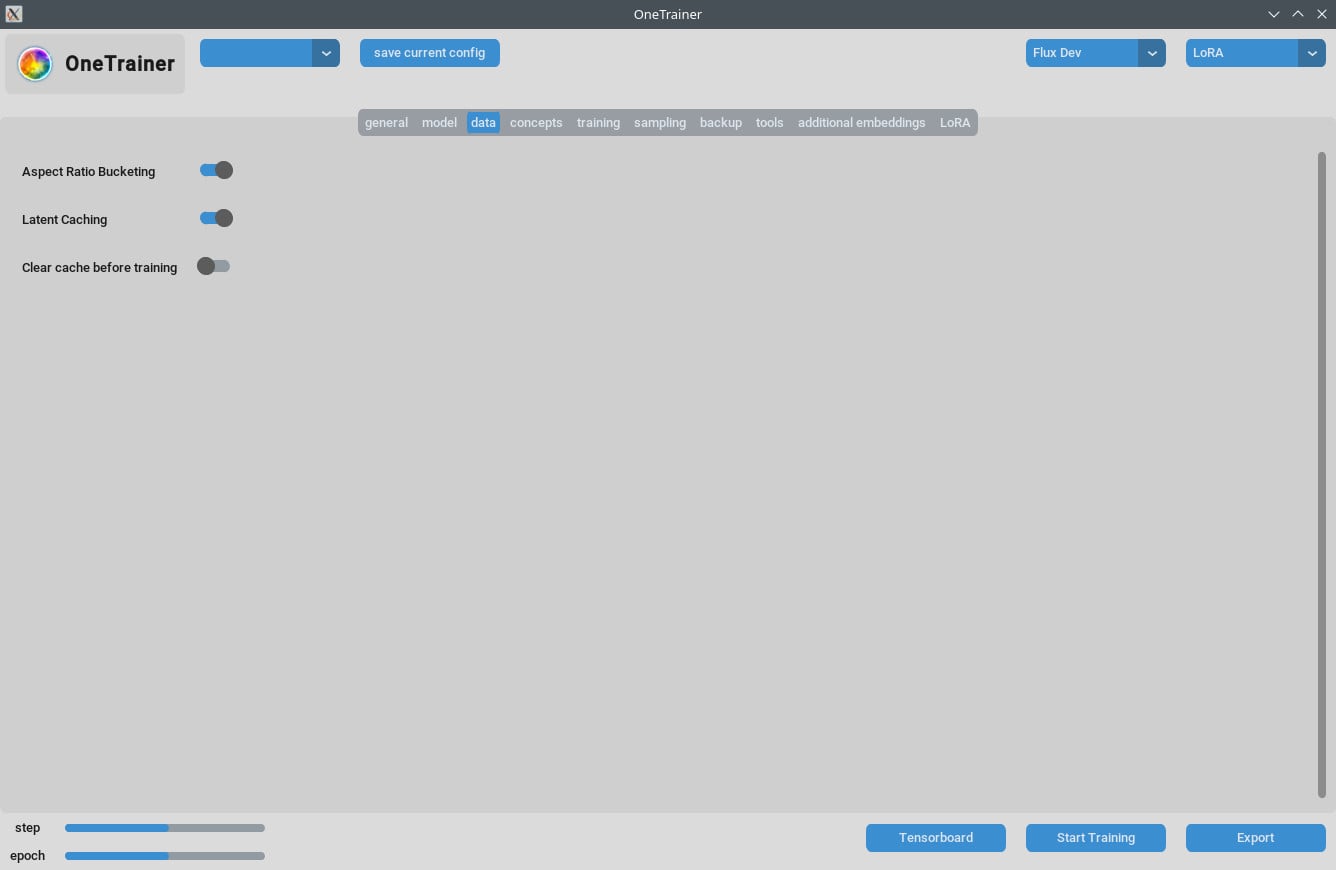

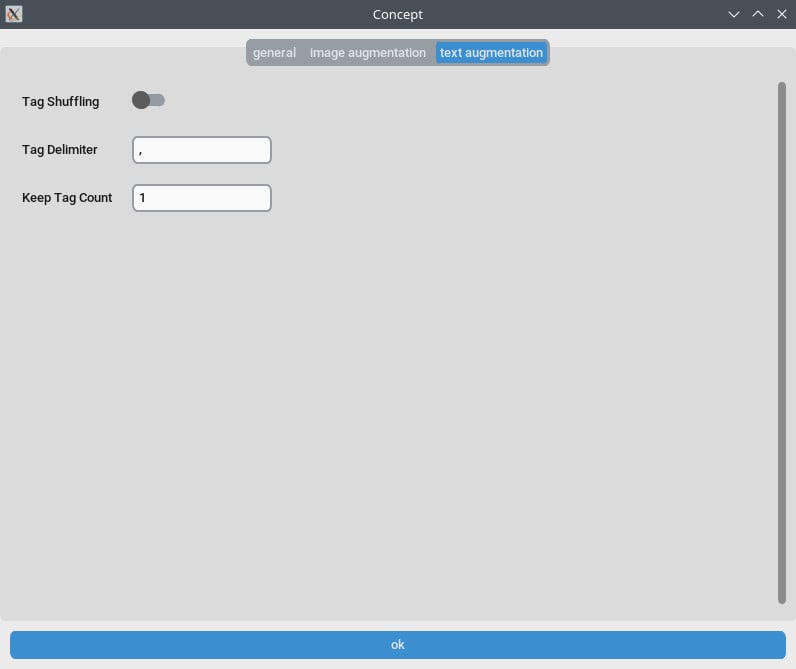

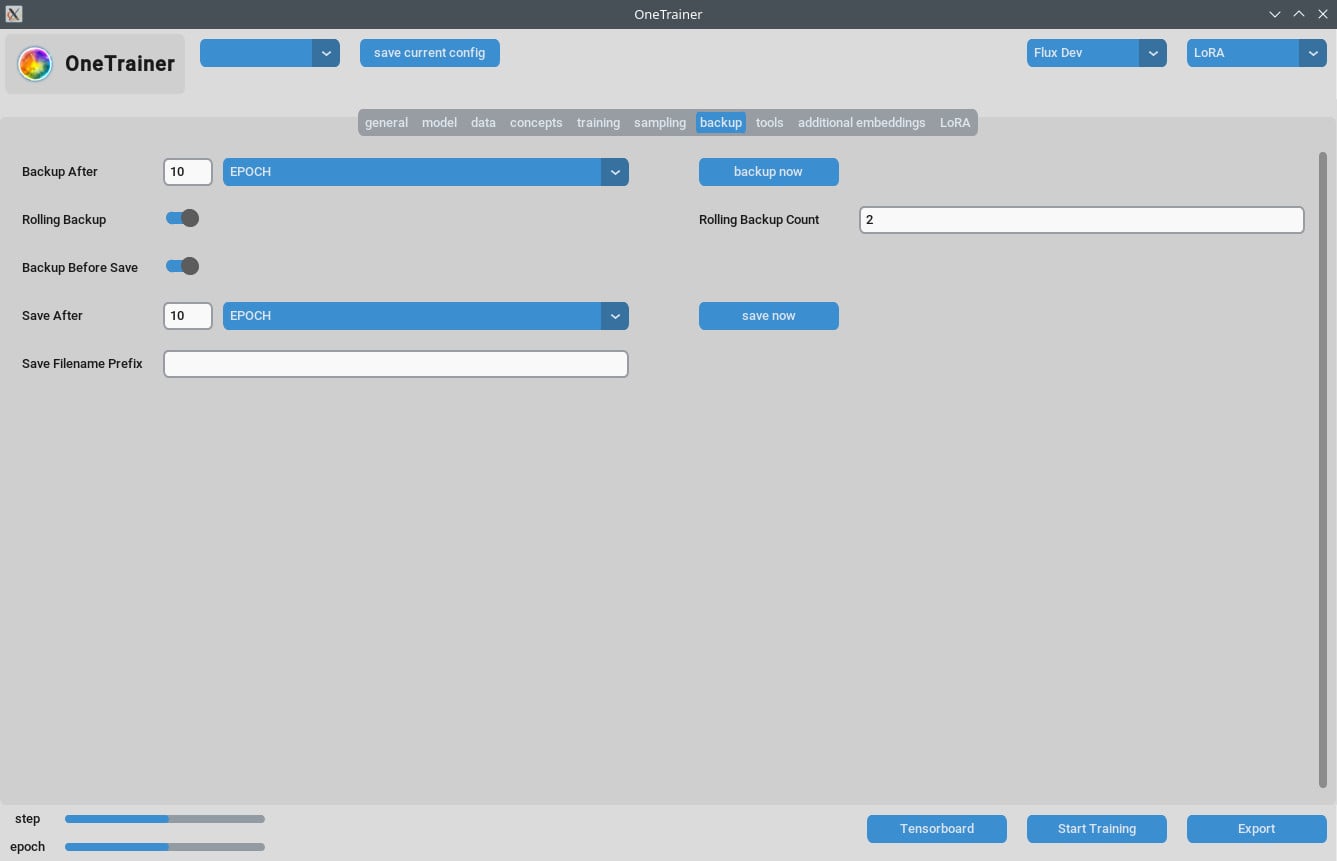

Gestão de Legendas e Dados

- Organize bem seus dados de treinamento. O número de épocas depende da complexidade dos seus dados.

- Legendas curtas e precisas podem melhorar bastante a eficiência do treinamento.

FAQs

Q1: Posso usar OneTrainer para modelos além do Flux.1?

Sim, o OneTrainer suporta SD 1.5, SDXL, e mais. As configurações vão variar conforme o modelo.

Q2: O OneTrainer usa automaticamente o nome do conceito como uma palavra-chave?

Sim, o nome do conceito pode funcionar como uma palavra-chave. Certifique-se de que seja significativo para seu projeto.

Q3: Como posso gerenciar melhor a VRAM durante o treinamento?

Defina Gradient Checkpointing como CPU_OFFLOAD. Essa configuração ajuda a reduzir o uso de VRAM sem impactar muito a velocidade.

Q4: Qual é o impacto do uso de NF4 versus camadas de precisão total?

NF4 reduz o uso de VRAM, mas pode diminuir um pouco a qualidade. Camadas de precisão total mantêm a qualidade, mas requerem mais VRAM.

Q5: Como faço pra diminuir o tamanho do meu modelo LoRA?

Você pode reduzir os valores de Rank e Alpha ou definir o LoRA weight data type como bfloat16. Isso diminui o tamanho, mas pode afetar a qualidade.

Q6: O OneTrainer consegue lidar com treinamento multi-resolução?

Sim, o OneTrainer suporta treinamento multi-resolução. Siga as orientações na wiki do OneTrainer pra configurá-lo.

Q7: Minhas imagens aparecem como estática rosa quando uso DoRA. O que eu faço?

Verifique as configurações da sua camada de atenção. Evite usar "full" nas camadas de atenção, pois isso pode estar causando o problema.

Q8: Como lido com múltiplos sujeitos no OneTrainer?

Use treinamento balanceado definindo diferentes valores de repetição para diferentes sujeitos. Organize os dados pra garantir que ambos os sujeitos recebam treinamento igual.

Q9: Existe um equivalente ao 'modo de divisão' no OneTrainer?

O OneTrainer não tem um 'modo de divisão'. Em vez disso, use configurações como CPU_OFFLOAD para Gradient Checkpointing pra gerenciar a VRAM mais efetivamente.

Q10: Posso ajustar as configurações do OneTrainer pra melhorar a qualidade com maior uso de VRAM?

Sim, aumente a resolução e ajuste os tipos de dados e as configurações de checkpointing de gradiente pra melhorar a qualidade.

Esse guia deve te dar todos os passos necessários, configurações e dicas de resolução de problemas pra usar o OneTrainer com os modelos Flux AI de forma eficaz. Boa sorte no treinamento!